CVPR 2022 | 点云分割的对比边界学习

点云分割是理解 3D 环境的基础。然而,当前的 3D 点云分割方法通常在场景边界上表现不佳,这会降低整体分割性能。在本文中,我们专注于场景边界的分割。因此,我们首先探索指标来评估场景边界上的分割性能。为了解决边界上不令人满意的性能,我们提出了一种新颖的对比边界学习(Contrastive Bouindary Learning)框架用于点云分割。具体来说,所提出的 CBL 通过在多个尺度的场景上下文的帮助下对比它们的表示来增强跨边界点之间的特征区分。通过在三种不同的基线方法上应用 CBL,我们通过实验表明 CBL 持续改进不同的基线并帮助它们在边界以及整体上实现引人注目的性能。实验结果证明了我们方法的有效性以及边界对 3D 点云分割的重要性。本工作是由京东探索研究院、悉尼大学联合完成,已经被CVPR2022 接收。

01

研究背景

3D 点云语义分割旨在为每个 3D 数据点分配语义类别,而稳健的 3D 分割对于各种应用非常重要,包括自动驾驶、无人机和增强现实。

现有的各种点云分割方法中, 3D 点云的边界并未收到很多的关注,然而这些边界上的准确分割是非常重要的。首先,干净的边界估计可能有利于整体分割性能。例如,在 2D 图像分割中,准确的边界分割是生成高保真掩码的关键。其次,与通常具有大部分 3D 点的对象类别相比,例如建筑物和树木,错误的边界分割可能会在更大程度上影响对具有更少点的对象类别(例如,行人和柱子)的识别。这对于自动驾驶等应用尤其危险,例如,如果自动驾驶汽车无法准确识别边界,则会撞到路边。

不幸的是,大多数以前的 3D 分割方法通常忽略了场景边界的分割。尽管一些方法考虑了边界,但它们仍然缺乏明确和全面的对边界区域的分割性能的分析。而且,它们在整体分割性能上的表现也不尽如人意。

因此,为了对边界分割进行更深入的研究,我们首先探索场景边界分割性能的指标。在揭示了令人不满意的性能之后,我们提出了一种新颖的对比边界学习(CBL)框架,以帮助优化边界上的分割性能,这也不断提高不同基线方法的整体性能。

特别是,当前流行的分割指标缺乏对边界的具体测量,使得现有方法难以揭示边界分割质量。为了更清楚地了解边界的性能,我们分别计算了边界区域和内部(非边界)区域的流行平均交并比(mIoU)。通过比较区域类型的表现以及整体表现,可以直接揭示边界区域的不理想表现。

此外,为了更全面地描述边界上的性能,我们考虑了标注真值中的边界与模型分割结果中的边界之间的对齐。因此,我们引入了用于评估的 2D 实例分割中流行的 boundary-IoU 分数(B-IoU),与 mIoU 的整体性能相比,它的分数也低得多。

在确定边界分割的困难后,我们进一步提出了一种新颖的对比边界学习(CBL)框架,以更好地将模型预测的边界与真实数据的边界对齐。

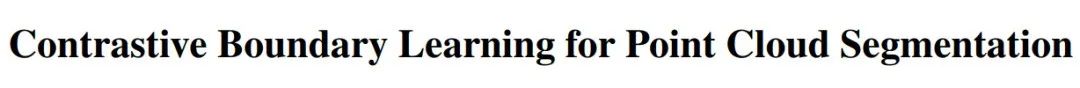

如图所示,CBL 优化了边界区域中点的特征表示的模型,增强了跨场景边界的特征识别。

图1对比边界学习(顶部)通过降采样过程从每个降采样点云(即子场景)中发现边界。通过在多个尺度上对边界区域进行对比优化,CBL 增强了跨边界的特征识别(中)。在没有明确的边界预测的情况下,CBL 改进了边界分割并获得了更好的场景分割结果(下)

此外,为了使模型更好地了解多个语义尺度的边界区域,我们还开发了一种子场景边界挖掘策略,该策略利用降采样过程来发现每个降采样点云中的边界点,即-场景。

具体来说,CBL 在不同的降采样阶段和促进 3D 分割方法以更好地学习边界区域周围的特征表示。

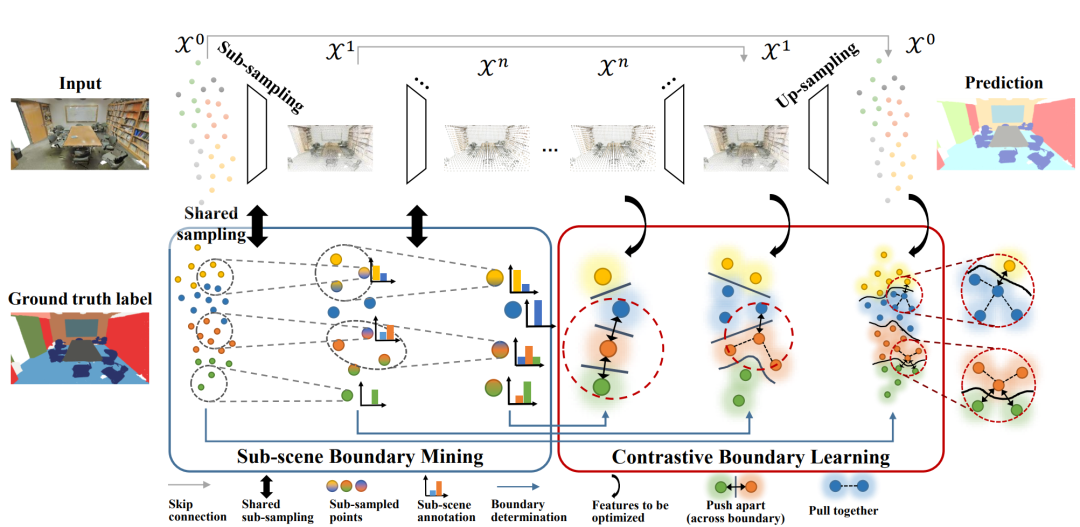

根据经验,我们对四个数据集的三个基线进行了实验。我们首先展示了使用当前点云分割方法时边界区域的不令人满意的性能,然后表明 CBL 可以帮助基线实现有希望的边界和整体性能。例如,所提出的 CBL 帮助 RandLA-Net 在 Semantic3D 数据集上超越了当前最先进的方法,并使基本的 ConvNet 能够在 S3DIS 数据集上实现领先的性能。

我们的贡献如下:

我们探索当前 3D 点云分割中的边界问题,并使用考虑边界区域的指标(例如边界 IoU)对其进行量化。结果表明,当前方法在边界区域的准确性比它们的整体性能差得多。

我们提出了一种新颖的对比边界学习(CBL)框架,它通过对比场景边界上的点特征来改进特征表示。因此,它提高了边界区域周围的分割性能,从而提高了整体性能。

我们进行了广泛的实验,并表明 CBL 可以在边界区域以及所有基线的整体性能上带来显着且一致的改进,这些实证结果。

02

边界上的分割

由于当前大部分工作都集中在改进一般指标,例如平均交集比联合(mIoU)、整体准确度(OA)和平均平均精度(mAP),点云分割中的边界质量通常被忽略。与最近的边界相关工作 [3,4] 只给出边界的定性结果不同,我们是第一个量化边界分割质量的。特别是,我们引入了一系列用于表示的指标,包括 mIoU@boundary、mIoU@inner 和来自 2D 实例分割任务的边界 IoU (B-IoU) 分数 [2]。

基于ground-truths数据,如果在其邻域中存在具有不同注释标签的点,我们将其视为边界点。类似地,对于模型预测,如果附近存在具有不同预测标签的点,我们将一个点视为边界点。

更正式地,我们将点云记为

(1)

遵循惯例,我们将

为了检查边界分割结果,一种直观的方法是计算边界区域内的mIoU,即mIoU@boundary。为了进一步比较模型在边界和非边界(内部)区域的性能,我们进一步计算了内部区域的 mIoU,即 mIoU@inner。

已有的 mIoU 在整个点云

(2)

其中

我们则可将 mIoU@boundary 和 mIoU@inner 定义为:

其中

(3)

然而,mIoU@boundary 和 mIoU@inner 没有考虑模型预测分割中的错误边界。受用于 2D 实例分割的边界 IoU的启发,为了更好地评估,我们考虑了分割预测中的边界与标注真值中的边界之间的对齐。因此,它引出以下 B-IoU 进行评估:

(4)

03

方法

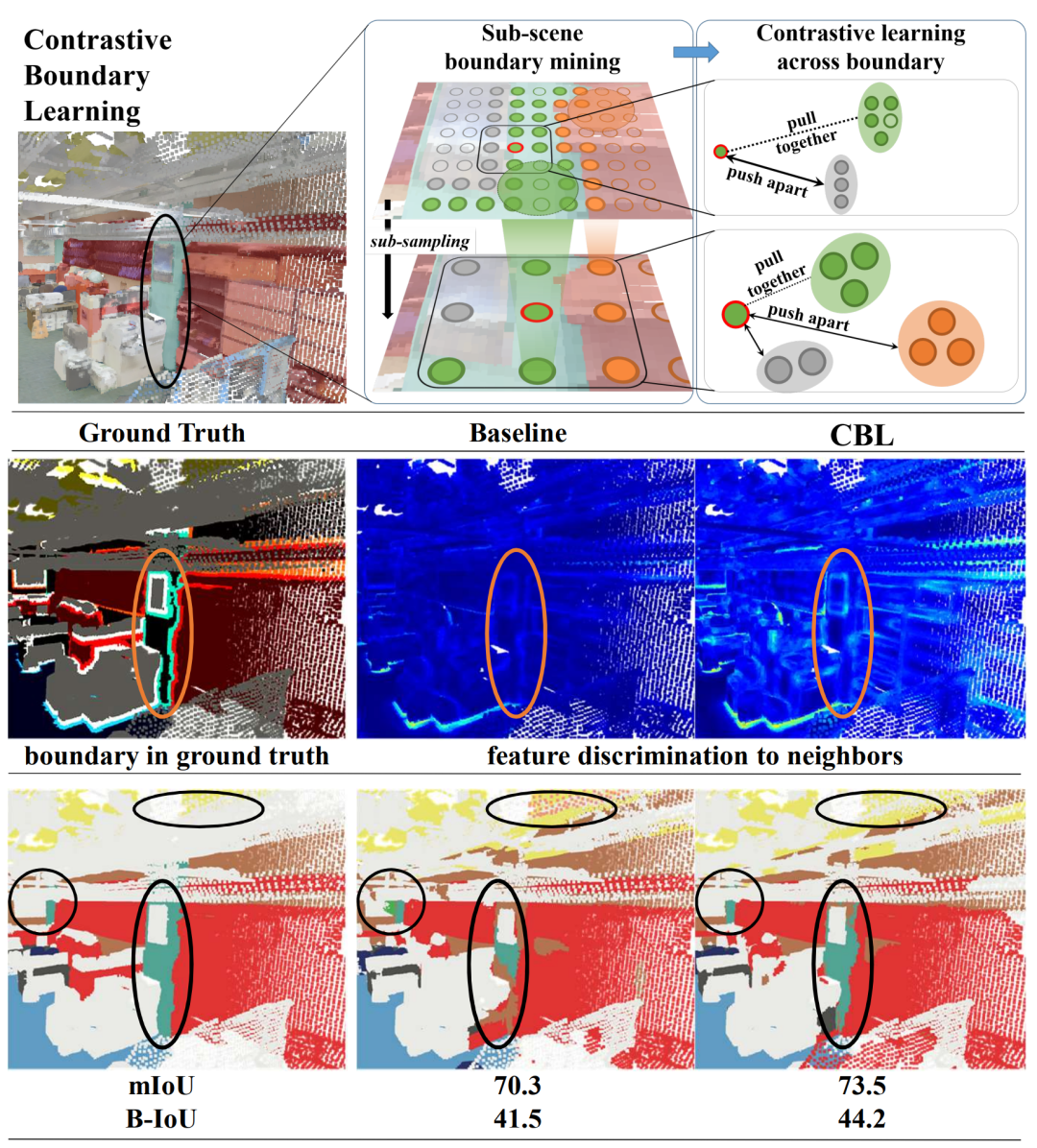

图2对比边界学习

在本节中,我们将展示我们的对比边界学习 (CBL) 框架} 所示。它强加对比学习以增强跨边界的特征识别。然后,为了深入增强模型在边界上的性能,我们通过子场景边界挖掘在降采样点云(即子场景)中启用 CBL。

对比边界学习

我们遵循广泛使用的 InfoNCE loss 及其泛化形式来定义边界点上的对比优化目标。

特别是,对于边界

(5)

其中是

(5)描述的对比学习只关注边界点 ,图2中的红色虚线圆圈)。首先,我们考虑ground-truth中的所有边界点

然后,对于每个

因此,对比学习增强了跨场景边界的特征识别,这对于改进边界区域的分割非常重要。

子场景边界挖掘

为了更好地探索场景边界,我们在多个尺度上检查降采样点云的边界,这使得能够在骨干模型的不同降采样阶段进行对比边界学习。

使用ground-turth标签从输入点云中收集边界点是比较容易地。然而,在降采样之后,由于降采样点的标签未定义,很难在之后获得边界点集的正确定义。因此,为了在降采样点云中启用 CBL,我们提出了子场景边界挖掘,它在每个降采样阶段确定一组真实边界点。具体来说,我们使用上标来表示阶段。在降采样阶段

由于每个降采样点

(6)

其中

通过 (6) 和 ground-truth 标签,我们可以迭代得到子场景标注

(7)

其中

04

实验结果

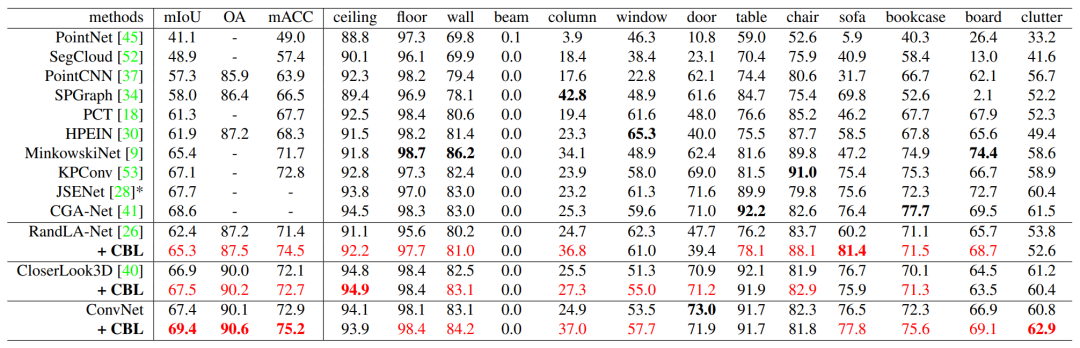

表1 不同模型在边界上的提升

表2 不同模型在总体性能上的提升(S3DIS)

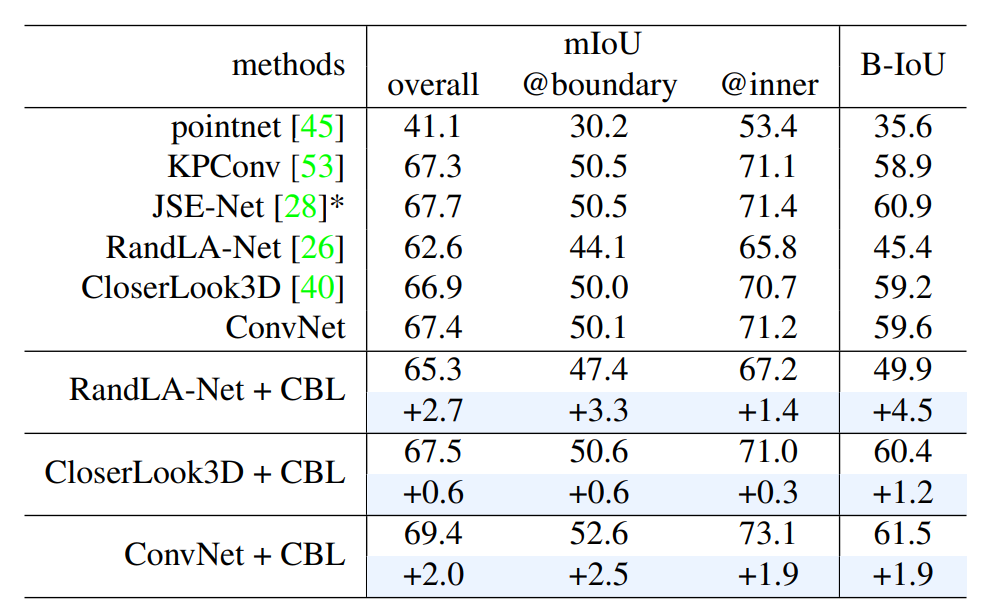

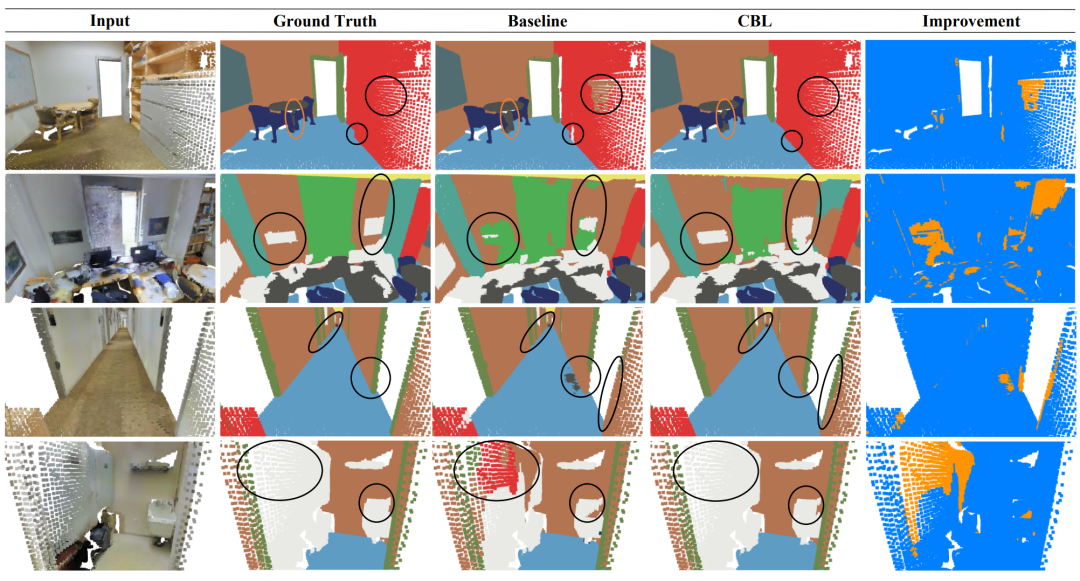

图3 在S3DIS 上的提升的可视化

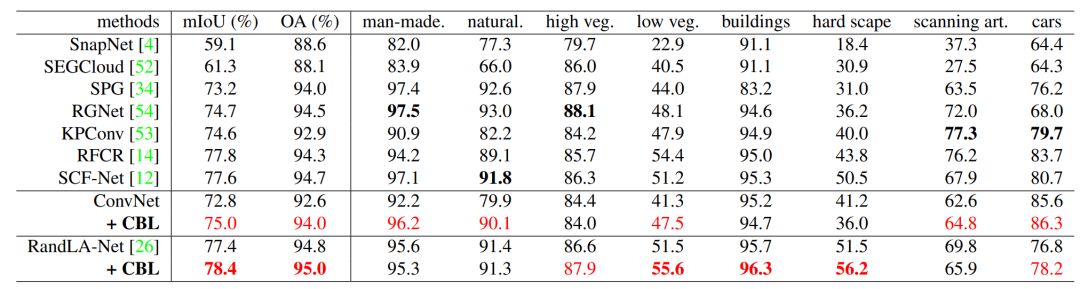

表3在总体性能上的提升(semanticd3d)

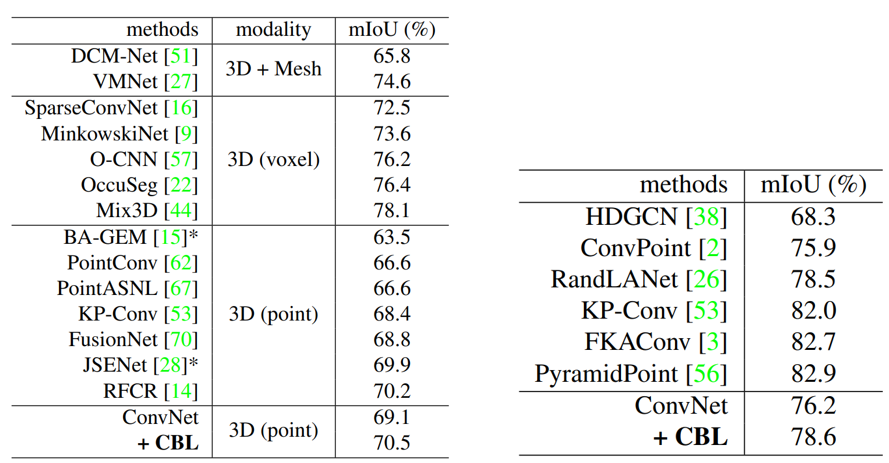

表4、5 在总体性能上的提升(ScanNet, NPM3D)

05

结论

在本文中,我们全面分析了当前点云分割方法在场景边界上的分割性能。我们表明,当前边界上的分割精度不能令人满意,并通过指标(包括 mIoU@boundary 和 B-IoU)定量地呈现边界问题。我们进一步提出了对比边界学习(CBL)来显式优化边界上的特征并提高边界上的模型性能。各种基线和数据集的领先性能和持续改进证明了 CBL 的有效性以及场景边界在 3D 点云分割中的重要性。

局限性和未来工作: 我们的局限之一是我们主要关注场景边界,而忽略了广阔的内部区域。因此,在未来,我们希望进一步探索边界在点云分割中的作用及其与内部区域的关系。

文章:

https://arxiv.org/abs/2203.05272

代码:

https://github.com/LiyaoTang/contrastBoundary

参考文献

THE END

专知便捷查看

便捷下载,请关注专知公众号(点击上方蓝色专知关注)

后台回复“CPCS” 就可以获取《CVPR 2022 | 点云分割的对比边界学习》,46页pdf》专知下载链接