IJCAI20 | 保持网络模式的异质信息网络表示学习

题目: 保持网络模式的异质信息网络表示学习

会议: IJCAI 2020

论文代码: https://github.com/Andy-Border/NSHE

1 引言

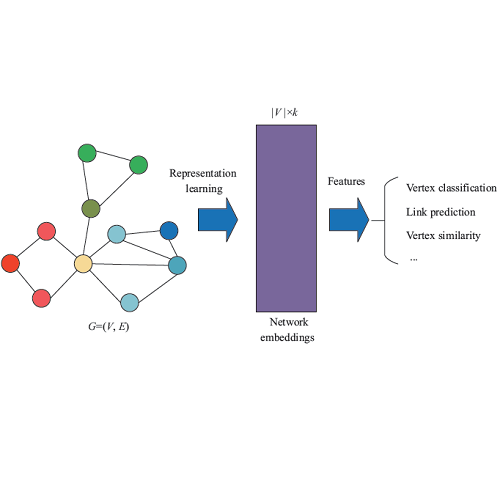

网络表示学习旨在保留网络的结构的前提下将网络的节点投影到低维空间中。近年来,基于异质信息网络的表示学习已引起越来越多的关注,并被广泛应用在现实场景中。

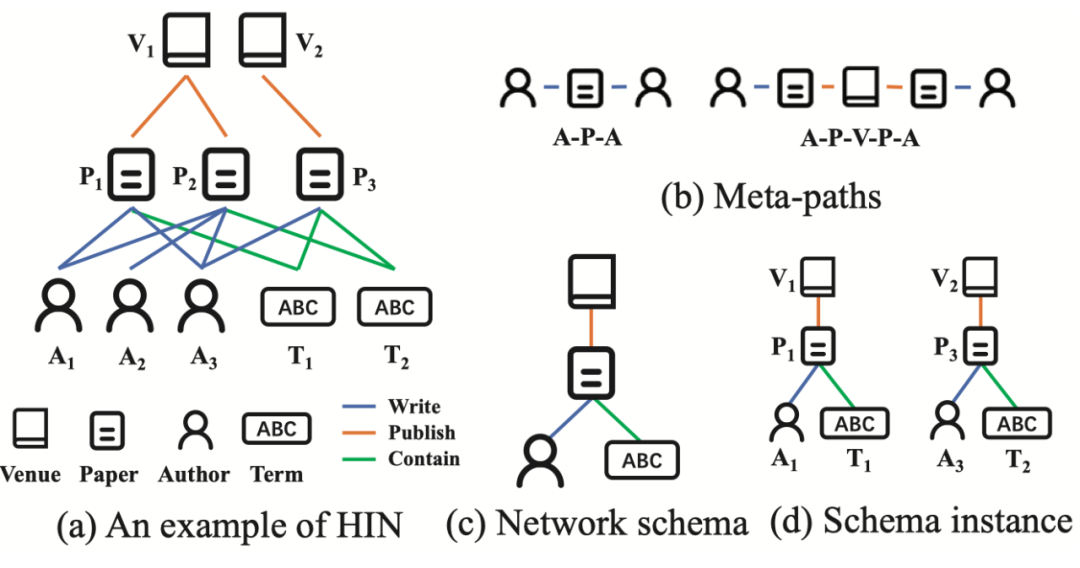

图 1 一个样例论文异质信息网络

为了学习异质信息网络上的节点表示,研究者们提出了许多异质信息网络表示学习方法。其中大多数方法利用元路径来保留不同类型节点之间的相似关系(proximity)。如图1 (a)所示的论文异质信息网络中,图 1 (b) 展示了两条元路径APA和APVPA,分别描述了两个作者之间的共同作者或共同参会的关系。基于元路径的表示学习方法通过元路径对高阶结构进行约束,从而得到包含特定语义的高阶结构的网络表示。

然而,尽管基于元路径的异质信息网络表示学习方法取得了巨大成功,元路径类异质信息网络表示学习方法仍面临着两个主要局限:

-

元路径的选择依赖领域知识:基于元路径的表示学习的效果极大程度上取决于元路径(集合)选择。而元路径的选择很依赖研究人员的领域知识。人工选择元路径可能适用于简单的异质信息网络,但元路径的选择空间会随着节点类型的增加而指数级增长,从而导致很难对复杂异质信息网络进行元路径选择。 -

元路径的语义融合依赖监督信息:不同的元路径根据不同语义生成不同的网络嵌入,用户往往需要融合不同的网络嵌入以生成统一的网络表示。现有的一些模型(如 HAN、HGAT)使用标签信息来指导嵌入融合。然而,这种方法不适用于无监督的情况。

为缓解基于元路径类表示学习方法的问题,我们探求如何在不使用元路径的前提下得到异质信息网络的网络表示。我们观察到网络模式(network schema),作为异质信息网络的统一蓝图,在异质信息网络中全面地保留了节点类型及其之间的关系,并天然的保持了网络中的高阶性质。基于网络模式的表示学习有以下优点:

-

不依赖领域知识:与元路径不同,每个异质信息网络只有唯一一个网络模式,因此我们不需要领域知识来做出选择。 -

保持了网络本身的高阶性质:异质信息网络根据网络模式建立,因此网络模式包含了异质信息网络最本质的特征。我们可以从HIN中提取子图(即网络模式实例)来捕获异质信息网络中最本质的高阶特征。图 1 (c) 和图 1 (d) 展示了网络模式及网络模式实例,我们可以看到,网络模式实例除了描述了两个节点的一阶结构信息之外,还描述了这四个节点的高阶结构信息。保持网络模式实例结构将自然地保持异质信息网络本身的高阶性质。

2 方法

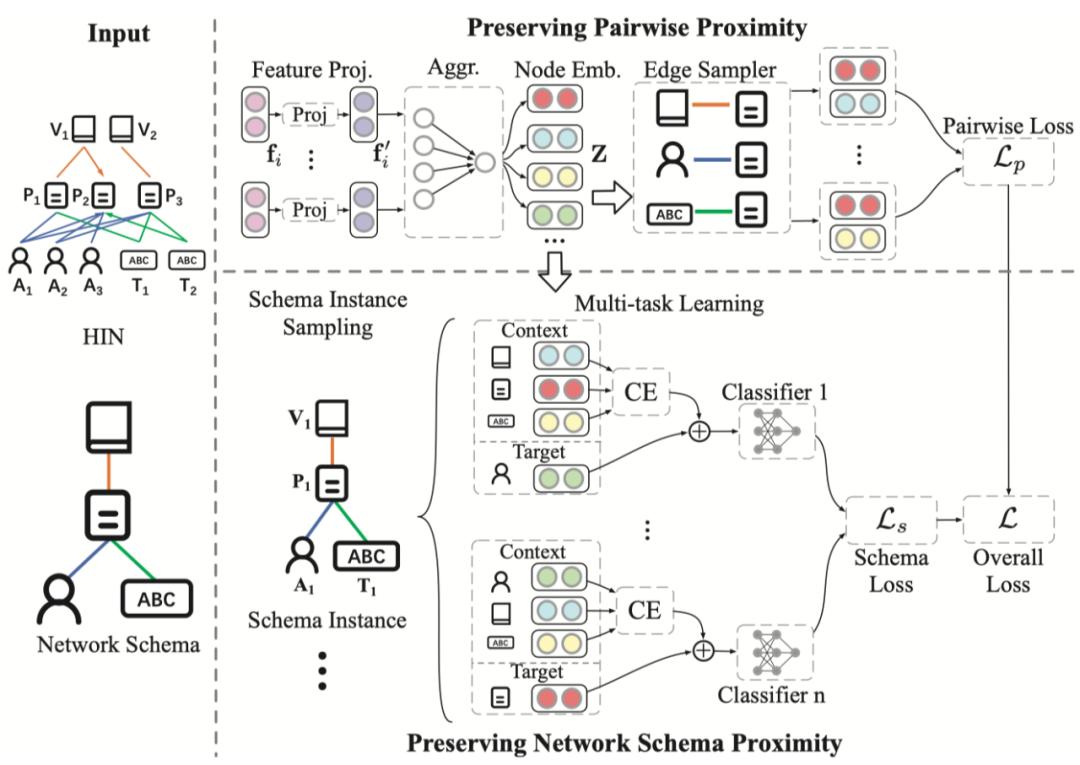

本文提出一种新的异质信息网络表示学习模型 (Network Schema preserving Heterogeneous information network Embedding) NSHE,其模型框架如图 2 所示。

图 2 NSHE 模型框架

NSHE模型首先使用异质图卷积神经网络得到网络表示,随后通过采样得到的节点对和网络模式实例优化得到的表示,从而保持异质信息网络中的一阶结构和高阶结构。最后,NSHE加权融合保持上述两种结构的损失并得到最终的损失函数。

异质图卷积神经网络

为建模异质信息网络中的属性异质性,我们使用异质图卷积神经网络来进行网络表示学习。具体地,我们先将异质特征通过映射函数映射到相同空间(方法上类似 HAN 的特征映射操作,不再赘述),随后使用 L层图卷积神经网络(本文实验上采用的是 GCN)得到节点表示:

我们取第 层GCN 的输出作为节点表示,即 。

保持网络的一阶结构

网络的一阶结构(Pairwise proximity)体现了网络最本质的特征,在网络表示学习中至关重要。在得到异质信息网络的网络表示矩阵后,NSHE保留网络的一阶结构。具体地,给定参数集合 ,保留网络一阶结构的目标函数 为:

其中 表示节点 的邻居节点。该目标函数让模型学得的网络表示最大化当前节点预测节点一阶邻居的条件概率 ,这个条件概率一般由softmax函数定义:

为方便计算,我们采用负采样来并得到保持一阶结构的损失函数 :

其中 表示网络中的噪声分布, 表示负样本的个数。通过优化 ,NSHE模型保持了异质信息网络中的一阶结构。

保持基于网络模式的高阶结构

网络模式实例采样

网络模式是异质信息网络的蓝图。给定一个异质信息网络 ,其网络模式 保存了网络 中所有的节点类型 和关系类型 。

本文假设,能够构成网络模式的内部的节点彼此相似。例如:在图 1 中一篇论文可被看作一个网络模式实例。但是,符合网络模式的节点集合极有可能存在节点数量不均衡的情况,例如一篇论文可以有多个作者但是只有一个会议。为解决这种节点数量不平衡,我们限定网络模式实例的定义为包含了全部异质信息网络节点和边类型的最小子图。根据这种定义,每个网络实例都包含全部的节点类型和关系类型,且每个类型节点有且只有一个。例如,图 1 (d) 为异质信息网络中的两个网络模式实例 和 。

本文提出如下采样方案来采样网络模式实例:初始化一个节点并放入集合 ,持续添加新节点到 中直到节点数 ,其中每次添加的新节点须满足两个条件:(1) 新节点类型需区别于 中的现有节点类型 (2) 新节点和 中的节点存在连边。

NSHE使用上述采样方案从网络中采样出一个网络模式实例集合 ,并通过保持 中的网络实例来保持网络的高阶结构。

通过多任务学习捕获网络模式

得到网络模式实例集合 后,NSHE 通过预测网络模式实例是否存在于网络中来保持异质信息网络中的网络模式结构。给定一个网络实例,例如图 1 (d) 中的 ,我们可以预测 是否在网络中和 构成联系。也可以预测 是否和 构成联系。很显然,这两种预测是截然不同的,对 A 的预测是以确定的 PV、PT 关系来预测PA 关系,而对 P 的预测则是预测 P 是否能和给定的 A、V、T 构成PA、PV和 PT 三种关系。在异质信息网络中由于边的异质性, PA、PV 和 PT 三种关系彼此区分,那么对它们的保持也理应设计不同的方法。考虑到这种异质性,NSHE设计了一个多任务学习模型。

为方便理解,我们以保持三个类型节点的网络模式实例为例进行讲解。假定我们想要保持一个网络实例 。如果我们要预测 是否存在于给定 的网络模式中,则称 为目标节点, 为上下文节点。这样一来,每个节点都有两种角色:目标节点和上下文节点,那么也理应有两种相对应网络表示:目标嵌入和上下文嵌入。考虑到这种区别,我们以 为目标节点表示,并为每一个节点类型 设计了一个上下文编码器(Context Encoder),记为 ,去学习该节点的上下文嵌入,在本例中, 和 的上下文表示 和 分别为:

其中,每个上下文编码器由一层全连接神经网络构成。随后,对于目标节点为 的网络模式实例(记为 ),我们将目标节点的节点表示 和上下文节点的上下文表示 拼接得到以 做目标节点时 的节点表示 :

其中, 符号表示向量拼接操作。

得到 后,我们预测以 为目标节点的 存在于网络中的概率,记为 :

其中 是识别网络模式实例目标节点类型为 的网络模式分类器,是一个多层神经网络分类器。

相同地,当我们把 和 看成目标节点的时候,也可以通过类似的方式得到 和 。值得注意的是,虽然我们以包含三种节点类型的网络模式为例进行讲解,但NSHE并不局限于节点类型的个数,读者可以轻易地泛化NSHE于其他情况。

得到对网络模式实例的预测之后,NSHE 使用交叉熵损失函数来计算保持网络模式的损失 ,可以通过如下公式得到:

其中,对于每个网络模式实例,我们采样 个负样本(从网络中采样一个节点来替换目标节点)。通过最小化 , NSHE 保留了网络模式的高阶结构.

为了更好的保持异质信息网络的一阶结构和高阶结构,NSHE采用综合考虑一阶结构和高阶结构的复合损失函数:

并使用 Adam 来优化模型。

3 实验

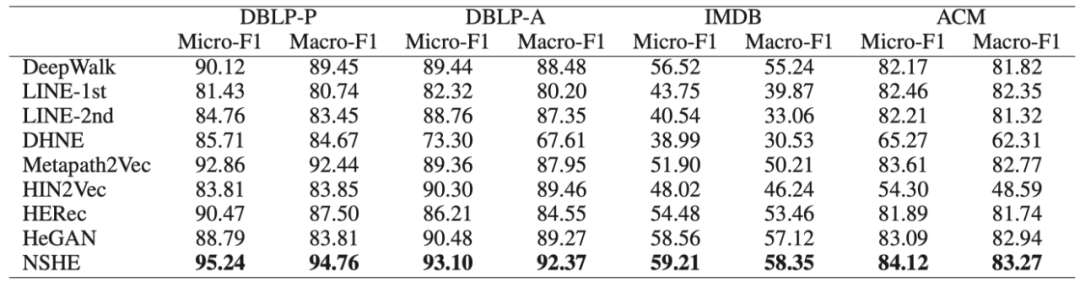

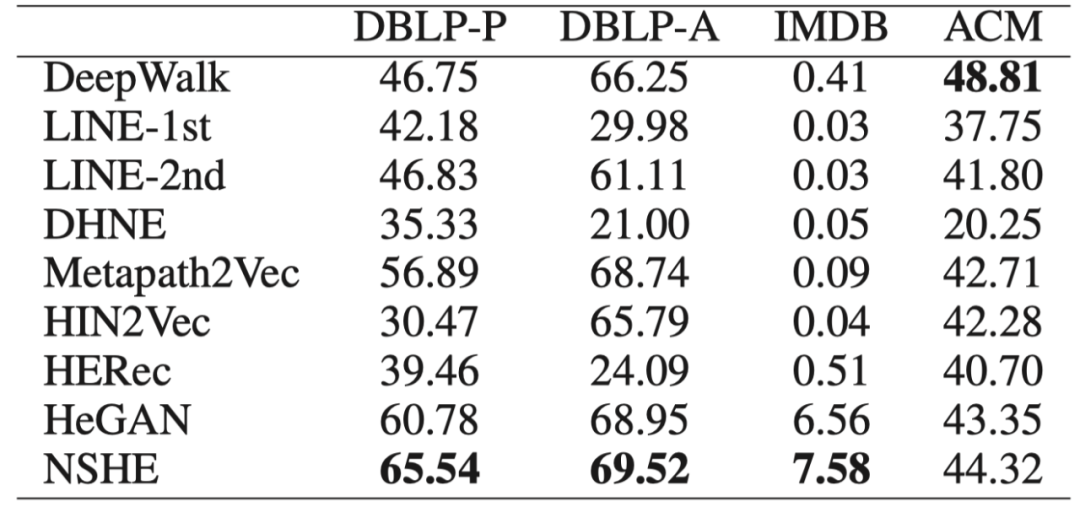

分类和聚类实验

为证明模型的有效性,本文在DBLP、ACM、IMDB 3 个数据集上进行了聚类和分类实验。

图 3 分类任务实验

图 4 聚类任务实验

从实验结果可以看出,即使和使用领域知识的元路径类表示学习方法相比,在大部分任务中,NSHE 的表现也超过了 baseline。

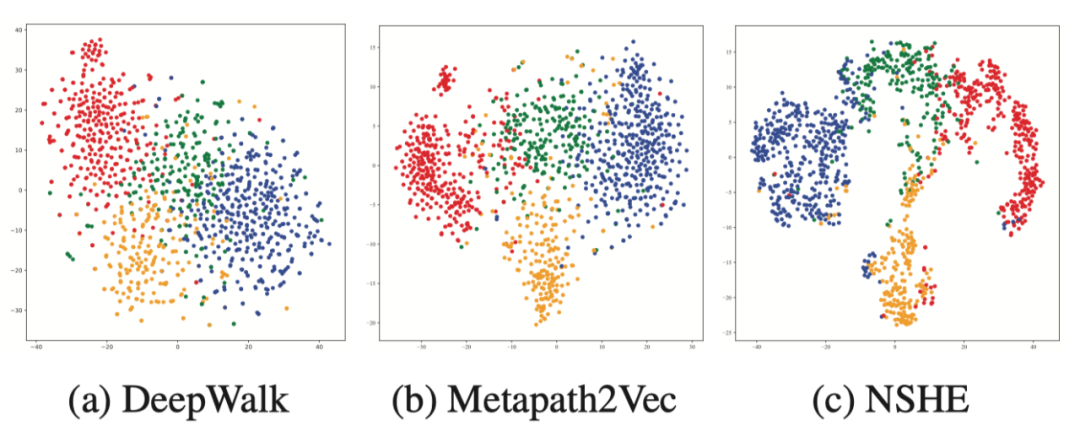

可视化实验

图 5 可视化实验

为了直观地理解学习到的网络表示,我们使用 tSNE 算法对 DBLP 中作者节点的节点表示进行可视化。我们选择 DeepWalk 和 Metapath2Vec 作为同质和异质表示学习方法的代表。从图 5中我们可以发现:在没有任何先验知识或监督信息的情况下,NSHE 成功地将不同研究领域的作者具界限清晰地分隔开来,这进一步表明了 NSHE 的有效性。

长按下图并点击“识别图中二维码”

即可关注北邮 GAMMA Lab 公众号