韩国ETRI提出实时Anchor-Free实例分割算法CenterMask,代码将开源

加入极市专业CV交流群,与6000+来自腾讯,华为,百度,北大,清华,中科院等名企名校视觉开发者互动交流!更有机会与李开复老师等大牛群内互动!

同时提供每月大咖直播分享、真实项目需求对接、干货资讯汇总,行业技术交流。关注 极市平台 公众号 ,回复 加群,立刻申请入群~

这几天来自韩国ETRI的一篇论文CenterMask : Real-Time Anchor-Free Instance Segmentation 很抢眼,作者称“CenterMask outperforms all previous state-of-the-art models at a much faster speed”,其分割精度打败了所有之前的State-of-the-art,速度也更快!

作者信息:

作者均来自韩国电子与通信研究所ETRI。

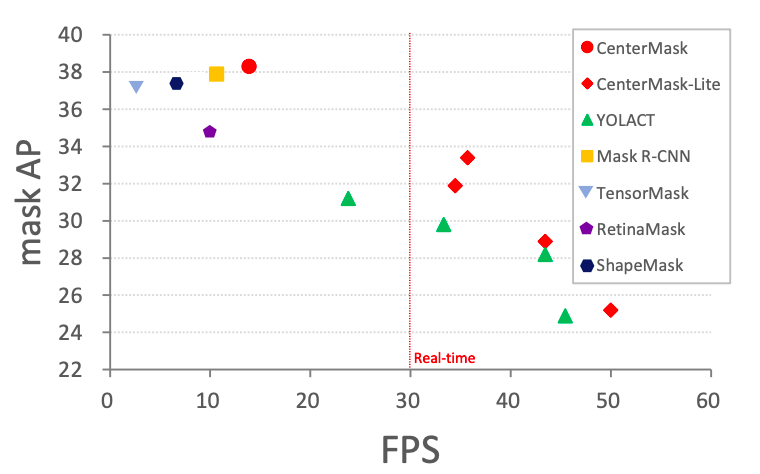

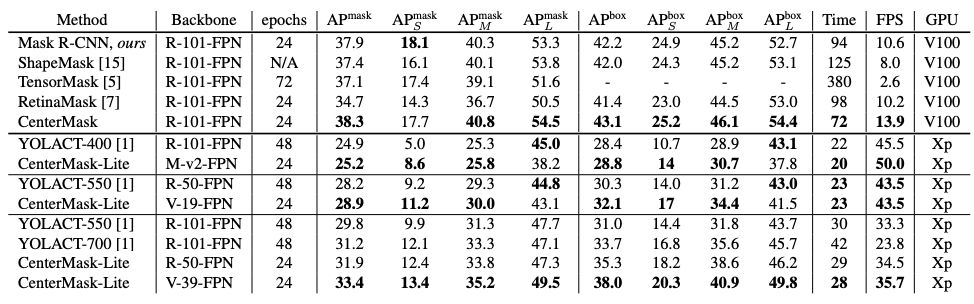

下图展示了CenterMask的精度和fps,其在精度和速度上均超越了Mask R-CNN。

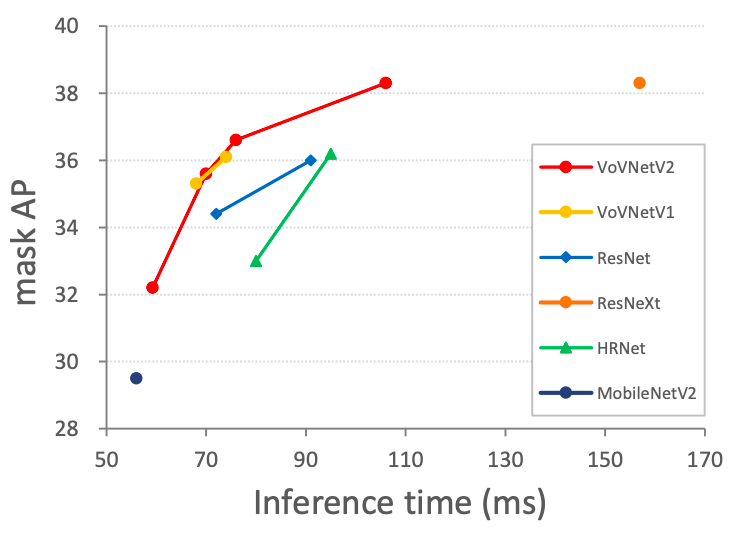

在CenterMask中使用了作者新提出的骨干网VoVNetV2,下图展示了相比于现有其他骨干网,VoVNetV2可大幅度改进精度。

作者使用的GPU为V100/Xp。

主要改进点

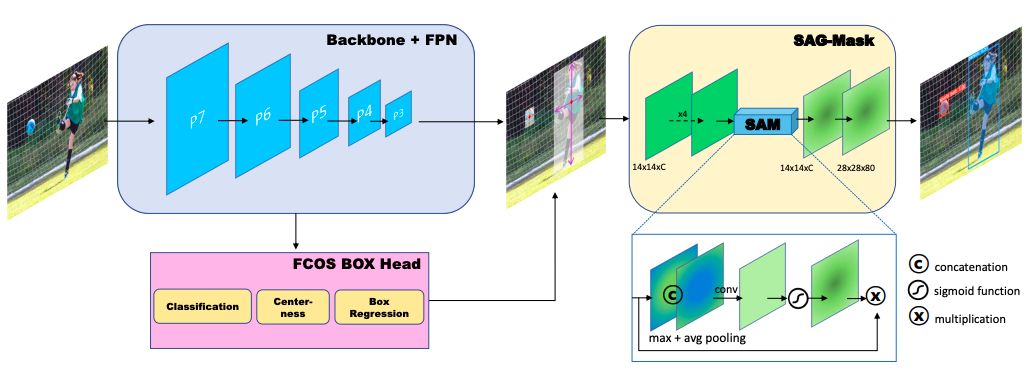

仿照Mask R-CNN是在Faster R-CNN基础上实现实例分割,CenterMask是在著名的一阶段anchor-free目标检测算法FCOS基础上添加了作者发明的SAG-Mask模块,实现了更快也更好的实例分割。

CenterMask架构图:

SAG-Mask 为 spatial attention-guided mask branch,即空间注意力引导的mask分枝,作者称空间注意力模块 (SAM)可让分割模块有效聚焦于有意义的像素而抑制无信息的像素。

实验结果

在 COCO tes-dev2017 数据集上的分割精度和速度:

可见CenterMask整体上取得了更好的精度,mask AP达到38.3,而其快速模型CenterMask-Lite 也相比于之前的实时实例分割算法YOLACT速度更快、精度更高。

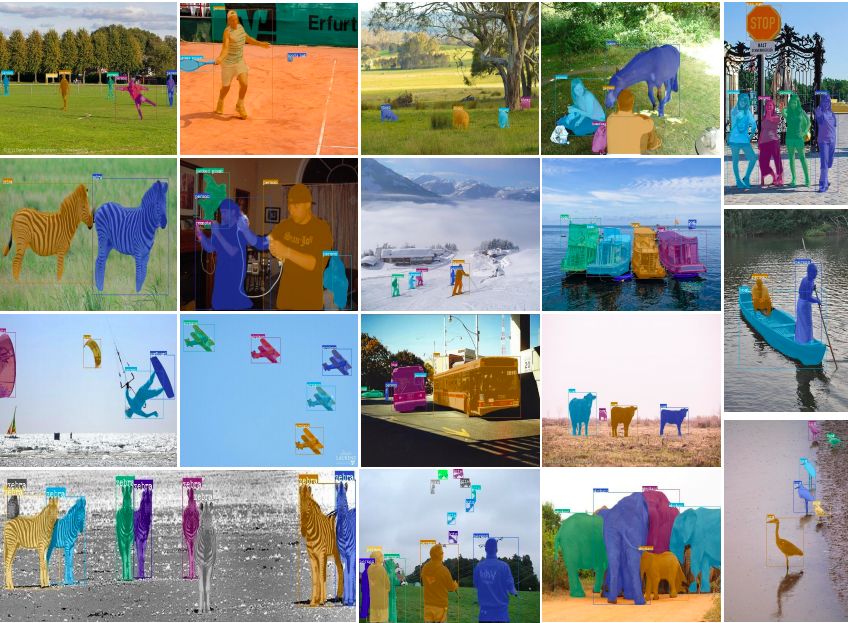

一些分割结果例子:

作者称CenterMask不仅是又好又快的实例分割算法,其使用的骨干网也非常值得在其他任务中尝试,代码将开源。

论文地址:

https://arxiv.org/abs/1911.06667v1

在极市平台公众号后台回复“CenterMask”,即可收到国内下载地址。

-End-

*延伸阅读

图像分割交流群

添加极市小助手微信(ID : cv-mart),备注:研究方向-姓名-学校/公司-城市(如:目标检测-小极-北大-深圳),即可进群。(已经添加小助手的好友直接私信)

△长按添加极市小助手

其他方向如目标检测、目标跟踪、人脸、工业检测、医学影像、三维&SLAM、姿态估计、超分辨率、嵌入式视觉、OCR 等,也可扫码添加极市小助手拉你进群,更有每月大咖直播分享、真实项目需求对接、干货资讯汇总,行业技术交流,一起来让思想之光照的更远吧~

△长按关注极市平台

觉得有用麻烦给个在看啦~