本文从统一的角度对视觉识别领域的半监督学习(SSL)和无监督学习(UL)深度学习算法进行了综述,

最先进的深度学习模型通常使用大量昂贵的标记训练数据进行训练。然而,在有限标签的情况下,需要详尽的人工标注可能会降低模型的泛化能力。半监督学习和无监督学习为从大量无标签视觉数据中学习提供了很有前途的范式。这些范式的最新进展表明,利用未标记数据来改进模型泛化和提供更好的模型初始化具有很大的好处。本文从统一的角度对视觉识别领域的半监督学习(SSL)和无监督学习(UL)深度学习算法进行了综述。为了全面了解这些领域的最新技术,我们提出了一个统一的分类法。我们对现有的代表性SSL和UL进行了全面而深刻的分析,突出了它们在不同的学习场景和不同的计算机视觉任务中的应用的设计原理。最后,我们讨论了SSL和UL的新兴趋势和公开挑战,以阐明未来的关键研究方向。

https://www.zhuanzhi.ai/paper/8f7472afa6b686ae45998a4f31d35ee6

在过去的十年中,深度学习算法和架构[1],[2]一直在推动各种各样的计算机视觉任务的SOTA水平,从目标识别[3],检索[4],检测[5],分割[6]。为了达到人类水平的性能,深度学习模型通常是通过监督训练在大量标记训练数据上构建的。然而,手动收集大规模标记训练集不仅昂贵和耗时,而且可能由于隐私、安全和道德限制而被法律禁止。此外,有监督深度学习模型倾向于记忆标记数据并加入注释者的偏见,这削弱了其在实践中对新场景的泛化,这些场景中数据分布不可见。

更便宜的成像技术和更方便的网络数据访问,使得获取大量未标记的视觉数据不再具有挑战性。因此,从未标记的数据中学习成为一种自然且有希望的方法来将模型扩展到实际场景中,在这种情况下,无法收集一个大的标记训练集,该训练集涵盖了由不同场景、相机位置、一天中的时间和天气条件引起的照明、视角、分辨率、遮挡和背景杂波等所有类型的视觉变化。半监督学习[7],[8]和无监督学习[9],[10],[11],[12]是两种最具代表性的利用非标记数据的范例。这些范式建立在不同的假设基础上,通常是独立开发的,同时具有相同的目标,即学习使用未标记数据的更强大的表示和模型。

更便宜的成像技术和更方便的网络数据访问,使得获取大量未标记的视觉数据不再具有挑战性。因此,从未标记的数据中学习成为一种自然且有希望的方法来将模型扩展到实际场景中,在这种情况下,无法收集一个大的标记训练集,该训练集涵盖了由不同场景、相机位置、一天中的时间和天气条件引起的照明、视角、分辨率、遮挡和背景杂波等所有类型的视觉变化。半监督学习[7],[8]和无监督学习[9],[10],[11],[12]是两种最具代表性的利用非标记数据的范例。这些范式建立在不同的假设基础上,通常是独立开发的,同时具有相同的目标,即学习使用未标记数据的更强大的表示和模型。

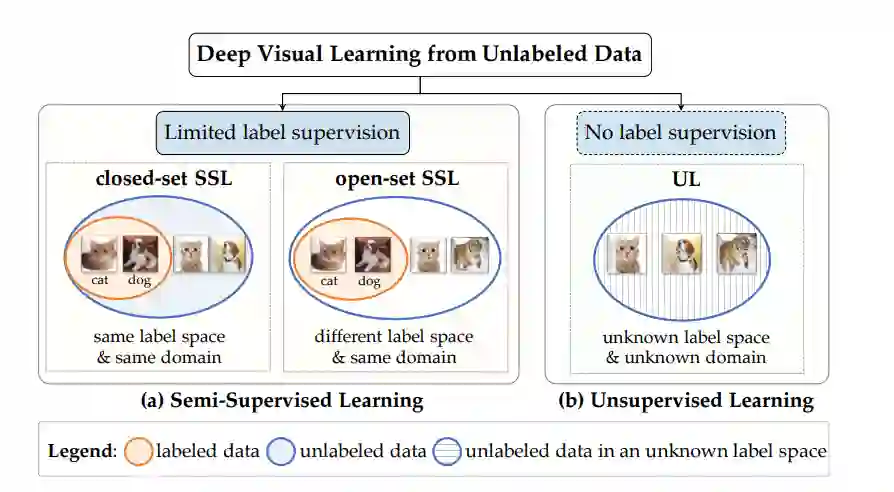

半监督和无监督学习范式的概述——两者都旨在从未标记的数据中学习。

图1总结了本次调研中涉及的两种范式,它们都利用未标记数据进行视觉表征学习。根据是否对一小部分训练数据给出标签注释,我们将范式分为半监督学习和无监督学习,明确定义如下。

-

(a) 半监督学习(SSL)旨在共同学习稀疏标记数据和大量辅助无标记数据,这些数据通常来自与标记数据相同的底层数据分布。在标准的封闭集SSL[8]、[13]中,标记数据和未标记数据属于来自同一域的同一组类。在开放集SSL[14]、[15]中,它们可能不在同一个标签空间中,也就是说,未标记的数据可能包含未知和/或错误标记的类。

-

(b)** 无监督学习(UL)旨在仅从无标签数据中学习**,而不使用任何与任务相关的标签监督。训练完成后,可以使用标记数据对模型进行微调,以在下游任务[16]中实现更好的模型泛化。

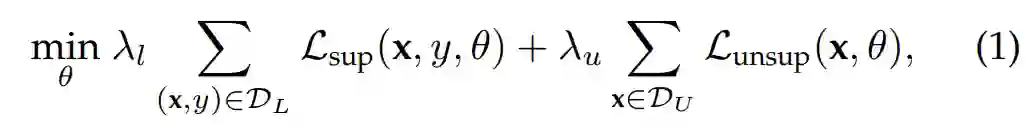

按照上述定义,将已标记数据集和未标记数据集分别表示为Dl和Du。SSL和UL统一的整体学习目标是:

式中θ为深度神经网络(DNN)的模型参数;X是输入图像,y是对应的标签;L_sup和L_unsup是有监督的和无监督的损失条款;λl和λu是平衡超参数。在SSL中,这两个损失项是联合优化的。在UL中,只有无监督损失项用于无监督模型的预训练(即λl = 0)。尽管SSL和UL在无监督目标学习的原理相同,但它们在学习设置上的差异,导致了不同的独特挑战。具体来说,SSL假设有限的已标记数据可用,其核心挑战是用大量的未标记数据扩展已标记集。UL假设主要的学习任务没有标记数据,它的关键挑战是从未标记的数据中学习任务通用表示。

我们专注于及时全面地回顾利用未标记数据来改善模型泛化的进展,涵盖了SSL和UL中最具代表性的最先进的方法及其应用领域,以及自监督学习的新兴趋势。重要的是,我们提出了先进深度学习方法的统一分类,为研究人员提供了一个系统的概述,有助于理解当前的SOTA,并确定未来研究的开放挑战。

我们的贡献是三方面的。首先,据我们所知,这是同类中第一个深度学习调研,全面回顾了利用无标签数据进行视觉识别的三种流行的机器学习范式,包括半监督学习(SSL,§2),无监督学习(UL,§3),并进一步讨论SSL和UL(§4)。其次,我们提供了一个统一的,有洞察力的分类和分析现有的方法在学习设置和模型制定,以揭示他们的潜在算法连接。最后,我们在§5中展望了新兴的趋势和未来的研究方向,以阐明那些未被探索的和潜在的关键的开放途径。

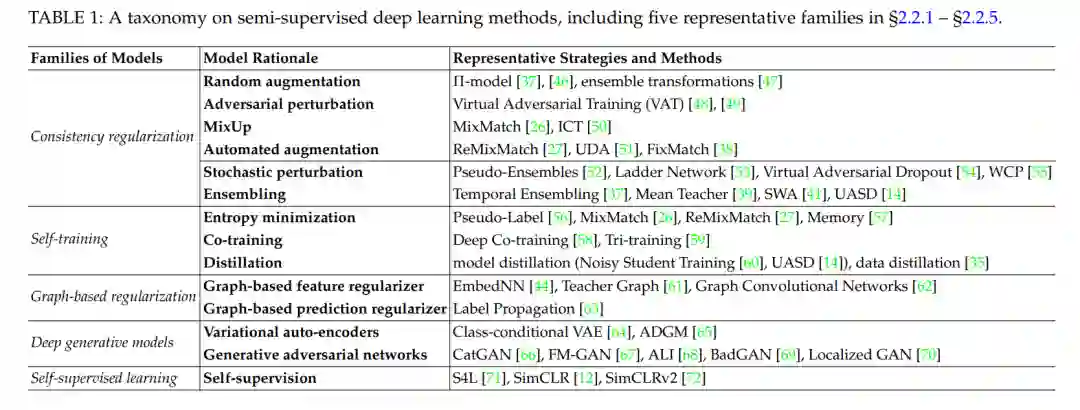

半监督学习分类

现有的SSL方法通常假设未标记的数据是封闭集和任务特定的,也就是说,所有未标记的训练样本都属于一个预定义的类集。现有的大多数工作都采用了基于某种底层数据结构(如流形结构[42]、[44]和图结构[73])为每个未标记的样本分配一个类标签的思路。我们将最具代表性的半监督深度学习方法分为五类: 一致性正则化、自训练、基于图的正则化、深度生成模型和自监督学习(表1),并在§2.2.1、§2.2.2、§2.2.3、§2.2.4和§2.2.5中给出了它们的一般模型公式。

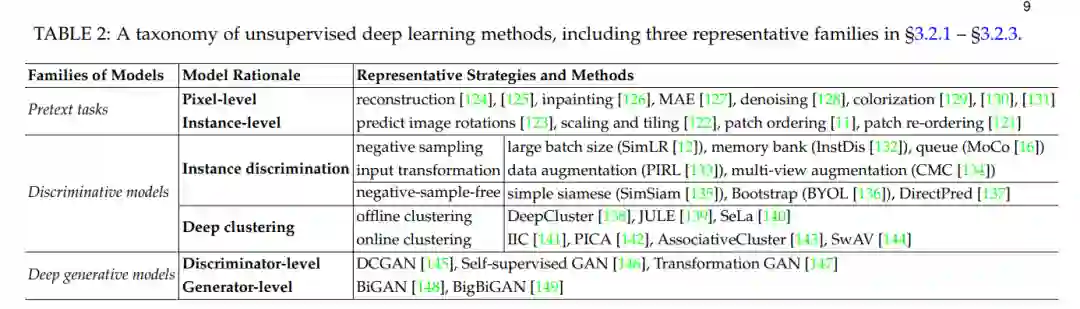

无监督学习分类

现有的无监督深度学习模型主要可以分为三大类: 前置任务、判别模型和生成模型(表2)。前置任务和判别模型也被称为自监督学习,它们通过代理协议/任务驱动模型学习,并构建伪标签监督来制定无监督代理损失。生成模型本质上是无监督的,并且明确地对数据分布建模,以学习没有标签监督的表示。我们在§3.2.1、§3.2.2和§3.2.3中回顾了这些模型。