推荐系统的可解释性已成为确保用户信任和满意度的关键。各种类型的可解释推荐系统已被提出,包括可解释的基于图的推荐系统。本文综述了这些系统的最新方法,并根据三个方面对其进行了分类:学习方法、解释方法和解释类型。本文还探讨了常用的数据集、可解释性评估方法以及该研究领域的未来方向。与现有的综述论文相比,本文侧重于基于图的可解释性,并涵盖了开发新型可解释的基于图的推荐系统所需的主题。

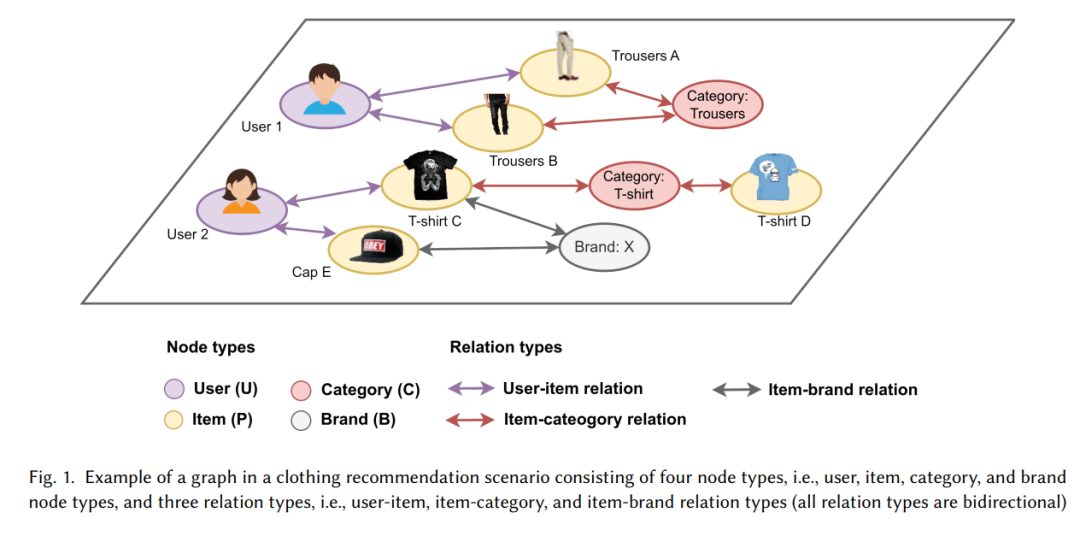

由于在线信息的指数级增长,用户通常会被大量的选择所淹没。为了应对信息过载问题,推荐系统成为了建议可能符合用户个人兴趣的信息(项目)的重要工具。在推荐系统的早期,大多数系统都是作为黑箱系统开发的,这意味着其内部机制或决策过程并不透明或易于解释。然而,最近的研究揭示了使用不透明的推荐系统可能带来的潜在问题,包括决策中的偏见和伦理违规,这些问题可能导致严重后果。为了解决这些问题,近年来出台了一些法规,例如欧盟的《通用数据保护条例》(GDPR)及其他国家的相关规定。这强调了开发不仅在准确性方面表现良好,还能提供推荐解释的推荐系统的重要性。 认识到这一必要性,推荐系统领域的众多研究集中在开发透明且可理解的可解释推荐系统。这些系统旨在生成准确的推荐,同时提供推荐解释或优先考虑可解释的推荐。这些系统使用户能够更好地理解决策过程,从而增加对系统的信任和信心。此外,通过提供清晰的推荐解释,可以识别并相应地解决数据或算法中的任何偏见,确保推荐的公平性、无偏性和伦理性。 为了在推荐中实现准确性和可解释性,各种资源被利用,包括图。图是一组节点(或顶点)和连接节点对的关系(或边)。每条边表示两个节点之间的关系或连接。在推荐场景中,节点可以表示用户、项目或属性等实体,而关系则表示它们之间的连接,例如用户-项目交互、用户之间的社交连接和项目属性。近年来,图被广泛应用于开发可解释的基于图的推荐系统。这些系统利用图结构进行个性化推荐,同时通过图中的连接信息提供推荐解释。与主要依赖用户-项目交互的传统推荐系统不同,可解释的基于图的推荐系统利用多跳关系的各种互联实体和关系。多跳关系表示两个非相邻节点之间的高阶连接。例如,在图1中,“用户1”和“T恤D”之间通过路径“用户1” - “T恤C” - “类别:T恤” - “T恤D”存在多跳关系。基于此路径,可以向“用户1”推荐“T恤D”,因为它们通过高阶连接链接。此外,连接它们的多跳关系可以作为解释。这种解释可以理解为“由于‘T恤D’与‘用户1’之前购买的一个项目属于同一类别,因此推荐给‘用户1’‘T恤D’”。 可解释的基于图的推荐系统在推荐研究领域代表了一个关键的进步,受到了广泛关注并不断发展。在开发可解释的基于图的推荐系统时,应考虑三个主要方面:(1)学习方法,(2)解释方法和(3)解释类型。 * 学习方法涉及用于提取图中连接信息以进行推荐学习的模型架构。在基于图的推荐系统中,有三种方法:基于嵌入的方法、基于路径的方法和混合方法。了解这些方法有助于选择适合开发基于图的推荐系统的架构,考虑可用数据的特性以及用于提取多跳关系的方法。 * 解释方法指的是可解释模型中解释组件的机制。它可以分为模型特定的,旨在提供特定模型决策过程的见解,或模型无关的,旨在提供适用于不同模型的广泛解释。理解这些机制对于在基于图的推荐系统中加入可解释性至关重要。 * 解释类型指的是可解释的基于图的推荐系统提供的解释形式。鉴于图中的多样信息,可以提供多种形式的解释,例如节点级别的解释(例如,预测/显著节点)或路径级别的解释(例如,连接用户和推荐项目的选定路径)。在开发可解释的基于图的推荐系统时,应仔细考虑解释类型的选择,以符合利益相关者的期望。一些场景可能需要节点级别的解释,侧重于个别节点的详细见解,或更高层次的路径解释,强调影响特定推荐的节点之间的互联关系和序列。

深入了解各种学习方法、解释方法和解释类型对于开发可解释的基于图的推荐系统非常有益。它使开发人员或研究人员能够就模型架构、可解释性组件以及模型生成的解释格式做出更明智的决策。因此,为了促进可解释的基于图的推荐系统的进展,本文综述了最新的可解释的基于图的推荐系统,并根据这三个方面对其进行了分类。此外,本文总结了用于评估和验证可解释的基于图的推荐系统性能的基准数据集和可解释性评估技术。这将使新研究人员或对可解释的基于图的推荐系统感兴趣的任何人能够方便地掌握整个研究领域的全貌并识别该领域的研究空白。 贡献与差异。本文综述的贡献和与之前已发表的综述论文的差异总结如下: * 本综述侧重于可解释的基于图的推荐系统,不同于之前关注基于图的推荐系统、涵盖各种类型的可解释推荐系统(不仅限于基于图)、可解释的基于图的人工智能或可解释的人工智能的综述。 * 在本综述中,可解释的基于图的推荐系统根据三个方面进行了分类,即学习方法、解释方法和解释类型。 * 在[22]中,重点是使用深度学习的可解释的基于图的推荐系统。相比之下,我们的论文涵盖了基于深度学习和基于机器学习的系统。虽然[22]根据图、图嵌入或路径嵌入如何与深度学习方法结合进行分类,我们的论文侧重于从各个方面对这些系统进行分类。此外,我们的综述论文还讨论了最新的可解释的基于图的推荐系统中使用的数据集和评估方法。 * 在[15]中,作者重点关注推荐系统中的视觉解释,广泛探索各种类型的可解释推荐系统。相比之下,我们的论文审查了可解释的基于图的推荐系统,从结构到所获解释的可视化,提供了对这种特定类型的推荐系统的更深入的关注。

本文的其余部分安排如下:第2节总结了可解释的基于图的推荐系统中通常使用的定义、符号和技术术语,为后续部分提供背景知识。此外,在本节中还解释了可解释的基于图的推荐系统的分类。第3节讨论了可解释的基于图的推荐系统中的各种学习方法,并介绍了按各自学习方法分类的最新系统。第4节从解释方法的角度探讨了可解释的基于图的推荐系统,并总结了使用不同解释方法的最新系统。第5节深入探讨了可解释的基于图的推荐系统中可用的不同解释类型,并介绍了按这些不同类型分类的最新系统。第6节介绍了常用的可解释的基于图的推荐系统的数据集。第7节讨论了评估基于图的推荐系统可解释性的方法。最后,第8节提供了结论并概述了可解释的基于图的推荐系统的未来方向。

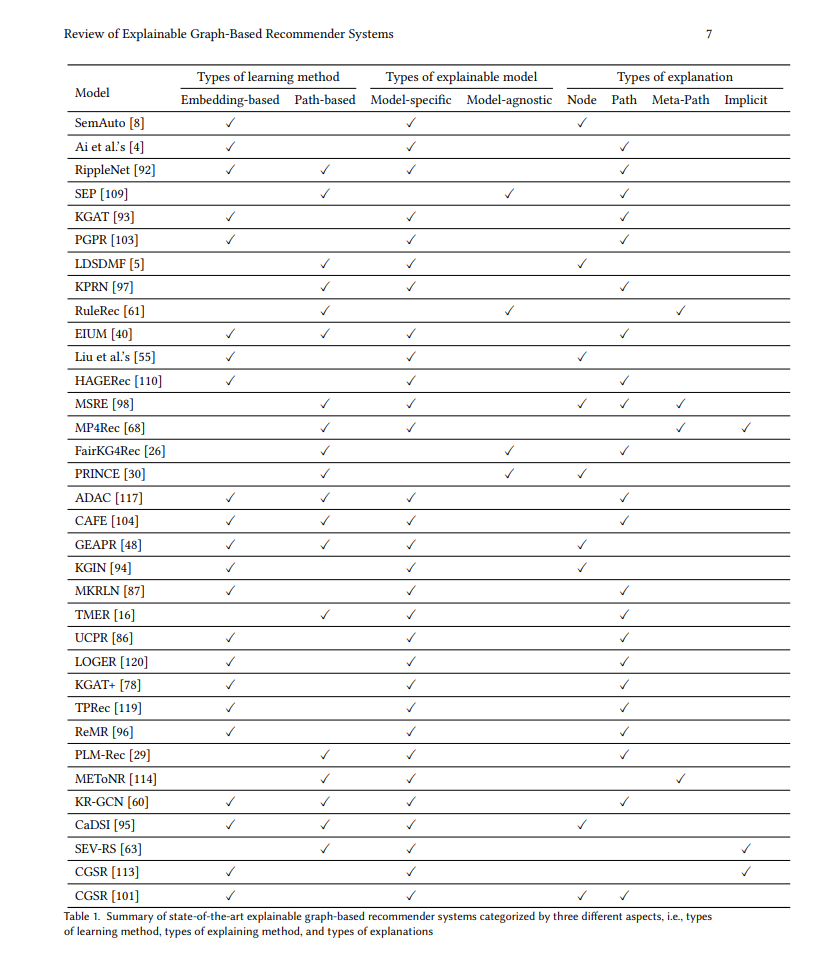

可解释的基于图的推荐系统的分类 可解释的基于图的推荐系统可以根据多方面进行分类。在本综述中,我们考虑以下三个方面: 1. 学习方法类型(基于嵌入、基于路径或混合方法):基于图的推荐系统可以根据其学习方法分为三类,即基于嵌入的方法、基于路径的方法和混合方法。在基于嵌入的方法中,节点嵌入用于捕捉局部邻域结构或全局图结构,而无需明确考虑图中的实际路径。相反,基于路径的方法显式地从图中提取路径,并将这些路径作为学习推荐的信息。最后,混合方法结合了基于路径的方法和基于嵌入的方法,利用这两种方法的优势。 1. 解释方法类型(特定模型或模型无关):在解释方法方面,可解释的基于图的推荐系统可以分为两类:特定模型和模型无关。特定模型的可解释的基于图的推荐系统具有专门为其结构和功能量身定制的可解释性组件。相反,模型无关的可解释的基于图的推荐系统包含后置的可解释性组件,这些组件不仅可以应用于自身,还可以应用于其他各种推荐系统。 1. 解释类型(节点级别、路径级别、元路径级别或隐含):可解释的基于图的推荐系统还可以根据其解释的格式进行分类。这些解释可以有多种形式,包括节点级别的解释(例如,预测或重要节点、反事实节点或节点邻域)、路径级别的解释(例如,连接用户和推荐项目的选定路径)和元路径级别的解释(例如,预测或重要元路径)。此外,还存在隐含级别,在这种分类中不会生成与推荐一起的显式解释,而是强调具有较高可解释性的推荐而不是具有较低可解释性的推荐。

表1总结了根据这三个方面分类的最新的可解释的基于图的推荐系统。详细信息,包括其学习方法、解释方法和解释类型,可以在后续章节中找到。某些最新的可解释的基于图的推荐系统的软件包概述见https://github.com/thanet-m/explainable-graph-based-recommender-systems.git。