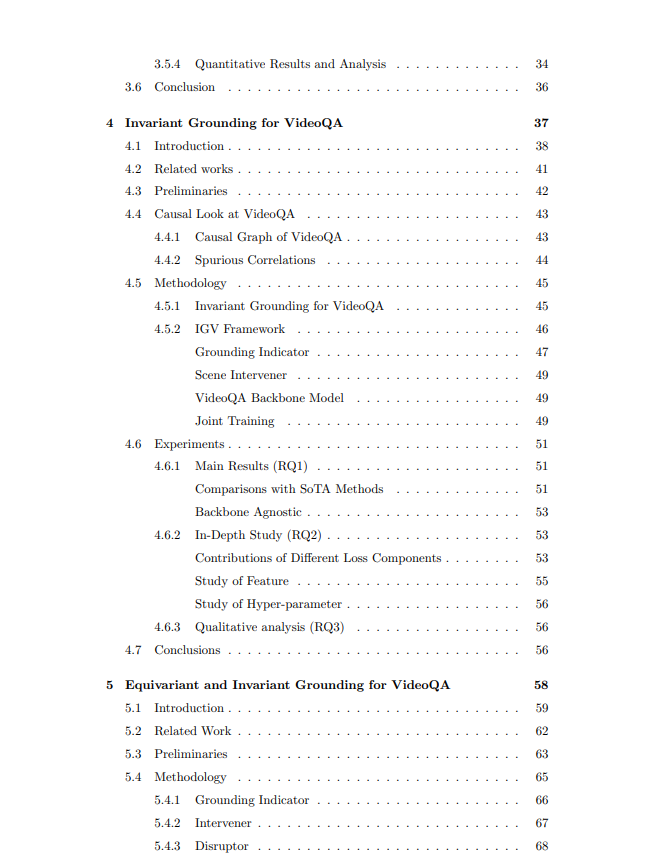

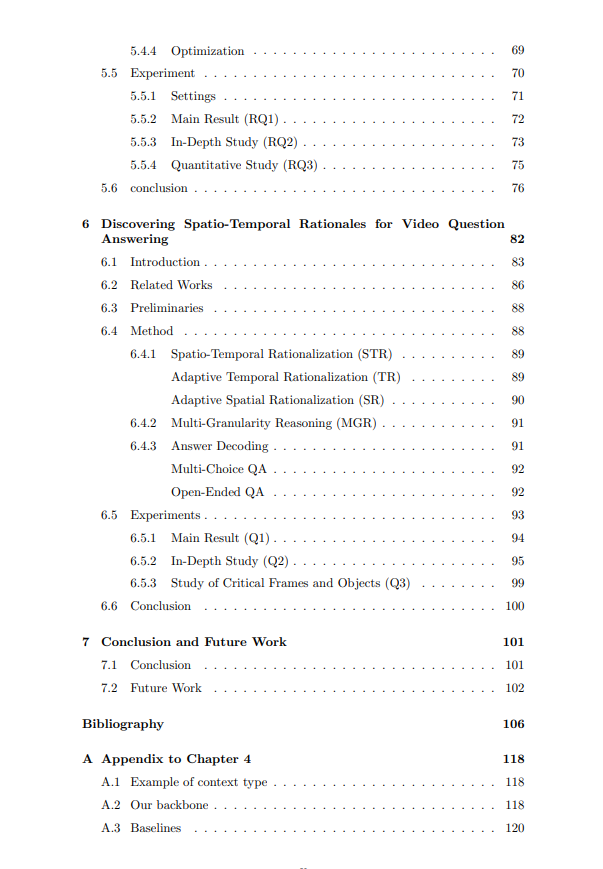

经过十年的蓬勃发展,视频理解领域的发展已到达一个关键节点,单纯依赖海量数据和复杂架构已不再是应对所有场景的万能解决方案。普遍存在的数据不平衡问题阻碍了深度神经网络(DNNs)有效学习潜在的因果机制,导致在遇到分布变化(如长尾不平衡和扰动不平衡)时性能显著下降。这一现实促使研究人员寻求替代方法,以捕捉视频数据中的因果模式。为了应对这些挑战并提高DNNs的鲁棒性,因果建模作为一种原则应运而生,旨在揭示观察到的相关性背后的真实因果模式。本论文聚焦于语义视频理解领域,探索因果建模在推动两项基础任务——视频关系检测(Video Relation Detection, VidVRD)和视频问答(Video Question Answering, VideoQA)中的潜力。主要贡献提出干预式视频关系检测方法(IVRD)针对VidVRD中关系长尾不平衡的问题,我们提出了一种名为IVRD的干预式视频关系检测方法。尽管尾部关系信息丰富,但由于其在数据集中稀缺,难以预测。具体而言,我们以分层方式构建了一组关系原型,迫使关系推理模块专注于实体间动态交互的视觉内容,而非依赖对象与关系标签之间的虚假相关性。通过引入因果推理,IVRD为在长尾不平衡情况下提升视频理解提供了有前景的方向,使模型能够更好地泛化到现实场景中,其中罕见或不频繁的关系可能对场景的整体理解至关重要。提出视频问答的不变基础模型(IGV)我们提出了视频问答的不变基础模型(Invariant Grounding for VideoQA, IGV),这是一个模型无关的学习框架,旨在解决答案环境中虚假相关性带来的负面影响。IGV通过定位问题关键(因果)场景来发现因果推理模式。具体而言,它利用因果场景与答案之间的关系在环境变化时保持不变的特性,并强调移除因果场景会导致回答问题失败。通过定位这些关键场景,IGV迫使VideoQA模型专注于准确推理所需的视觉内容,同时屏蔽环境的负面影响,从而显著提升骨干模型的推理能力。提出视频问答的等变基础模型(EIGV)为了进一步提升鲁棒性和视觉可解释性,我们在IGV的基础上提出了等变基础模型(Equivariant Grounding for VideoQA, EIGV)。EIGV额外引入了等变性,鼓励回答过程对因果场景和问题的语义变化敏感。相比之下,不变基础模型要求回答对环境场景的变化不敏感。这两种正则化方法协同工作,区分因果场景与环境,同时通过呈现视觉-语言对齐提供更高的透明度。通过结合不变和等变基础模型的优势,EIGV为VideoQA创建了一个更鲁棒且可解释的框架。提出视频问答的时空合理化方法(STR)我们发现了视频问答的时空合理化方法(Spatio-Temporal Rationalization, STR),以解决长视频和多对象样本(即复杂VideoQA)的低准确率问题。由于当前的VideoQA实践(包括预训练模型,如SeVila [158])大多使用短视频片段(约15秒)和少量实体(约2个)进行训练,它们在复杂视频(超过80秒和5个对象)上的迁移能力较差。其原因是长视频不可避免地引入了大量冗余和虚假相关性,因为存在大量与问题无关的环境对象。针对这一挑战,我们首先强调了建模问题关键时间点和空间对象的重要性,然后引入了时空合理化(STR)方法,利用可微分选择模块通过跨模态交互自适应地收集问题关键的时间点和对象。结合更合理的候选答案解码策略,STR有效识别了与问题无关的帧和对象作为因果模式,从而提升了预测性能,尤其是在复杂场景中。局限性本论文的一个局限性在于对识别出的因果场景的评估。在整个研究中,我们依赖问答(QA)的整体性能作为发现因果场景质量的间接指标,其依据是更准确的因果场景定位可能提供更丰富的问题-关系视觉线索,从而提升QA性能。然而,必须承认,基于因果场景的直接定量测量将提供更具说服力的见解。遗憾的是,由于缺乏人类级别的定位标注,当前工作中尚未实现此类测量。因此,未来的研究将致力于建立一个专门针对因果场景的评估基准,涉及对支撑回答过程的视觉元素进行人工标注。这一举措将有助于对因果场景发现进行更全面和严格的评估。总结我们的贡献拓展了因果建模在语义视频理解中的前沿,赋能AI系统掌握因果模式,并在具有挑战性的视频理解任务中提升性能。