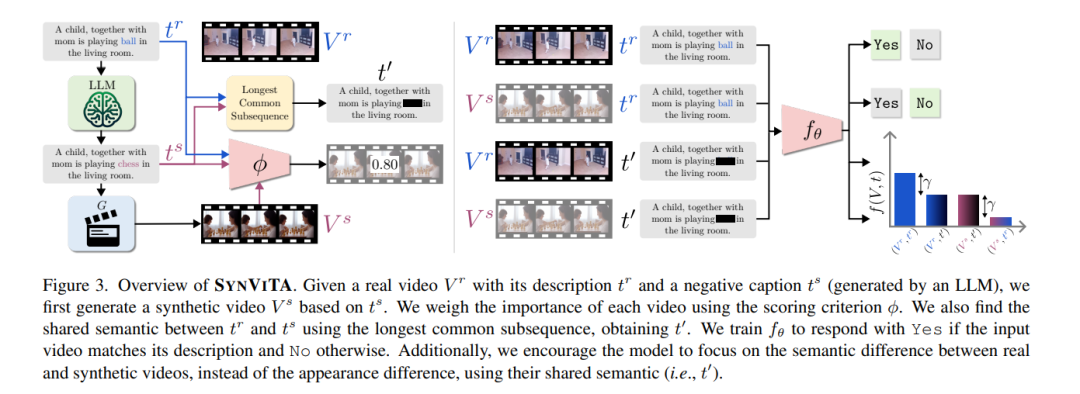

当前视频-语言对齐模型的训练数据通常包含视频片段及其对应文本:一条由大型语言模型生成的正例描述和一条负例描述。这种方法的缺陷在于,负例描述可能引入语言偏差——某些概念仅以负面形式出现,却从未与真实视频关联。虽然可通过收集负例对应视频来解决此问题,但现有数据库缺乏覆盖所有潜在负例所需的细粒度变体。本研究探讨合成视频能否突破这一局限。通过多生成器的实验发现:合成视频在某些任务中表现良好,但在其他任务中会损害模型性能。我们推测这一问题与生成视频中的语义噪声和视觉噪声有关,据此提出动态加权方法SYNVITA:动态加权:根据合成视频目标描述与真实描述的相似度调整权重语义一致性损失:迫使模型关注描述间的细粒度差异,而非视频表观差异实验表明,SYNVITA在VideoCon测试集及SSv2-Temporal、SSv2-Events、ATP-Hard等基准上平均性能优于现有方法,为合成视频在视频-语言模型训练中的应用迈出重要一步。

成为VIP会员查看完整内容

相关内容

Arxiv

202+阅读 · 2023年4月7日