强化学习(RL),特别是与深度神经网络结合的深度强化学习(DRL),在广泛的应用中展现了巨大的前景,表明其有望推动复杂机器人行为的发展。然而,机器人问题为RL的应用带来了根本性的挑战,这些挑战源于与物理世界交互的复杂性和成本。本文提供了关于DRL在机器人领域应用的现代综述,特别关注DRL在实现几项关键机器人能力方面取得的现实世界成功。我们的分析旨在识别这些令人兴奋的成功背后的关键因素,揭示未充分探索的领域,并对DRL在机器人领域的现状进行总体描述。我们强调了未来研究的几个重要方向,包括需要稳定且样本高效的现实世界RL范式,发现和整合各种能力以应对复杂的长期开放世界任务的整体方法,以及原则性的发展和评估程序。本综述旨在为RL从业者和机器人学家提供见解,以利用RL的力量创建具有广泛能力的现实世界机器人系统。

引言

强化学习(RL)(1) 是一类决策问题,其中代理必须通过试错学习以最大化其累积回报,该回报由标量奖励函数编码,映射代理的状态和行动到即时奖励。特别是与深度神经网络结合的深度强化学习(DRL)(2),在解决复杂决策问题方面显示出卓越的能力,即使是在棋类游戏(3)、视频游戏(4)、医疗保健(5)和推荐系统(6)等领域的高维观察中也不例外。这些成功突显了DRL在控制具有高维状态或观察空间和高度非线性动态的机器人系统以执行传统决策、规划和控制方法(如经典控制、最优控制、基于采样的规划)无法有效处理的挑战性任务方面的潜力。然而,迄今为止,DRL最显著的里程碑是在模拟或游戏环境中实现的,在这些环境中,RL代理可以从大量的经验中学习。相比之下,机器人需要在物理世界中完成任务,这带来了额外的挑战。在物理世界中直接通过试错收集样本通常效率低下且/或不安全,而且通常不可能在模拟中创建复杂真实世界的精确副本。尽管存在这些挑战,最近的进展使得DRL在一些现实世界的机器人任务中取得了成功。例如,DRL已实现冠军级别的无人机竞速(7)和集成到生产级四足机器人系统中的多功能四足机器人控制(如ANYbotics1、Swiss-Mile2和Boston Dynamics3)。然而,最先进的DRL解决方案在不同的机器人应用领域的成熟度差异显著。在某些领域,如城市自动驾驶,基于DRL的解决方案仍然局限于模拟或严格限定的现场测试(8)。 本综述旨在全面评估DRL在现实世界机器人应用中的当前进展,识别最令人兴奋的成功背后的关键因素以及在较不成熟领域中仍然存在的开放挑战。具体而言,我们评估了DRL在各种问题领域的成熟度,并对不同领域的DRL文献进行对比,以确定广泛适用的技术、未充分探索的领域以及需要解决的共同开放挑战,以推进DRL在机器人中的应用。我们希望本综述能为研究人员和从业者提供对DRL在机器人领域现状的深入理解,提供有价值的见解,以指导未来的研究并促进现实世界机器人任务中广泛可部署的DRL解决方案。

为什么要进行另一项关于机器人强化学习的综述?

管之前的一些文章已经综述了机器人强化学习,但我们在文献中提供了独特的视角并填补了知识空白,主要贡献有三点。首先,我们专注于在现实世界中至少取得了一定成功的工作,旨在评估DRL在现实世界机器人应用中的当前状态和开放挑战。大多数现有的关于机器人强化学习的综述并未明确讨论这一主题,例如,Dulac-Arnold等(9)讨论了现实世界RL的一般挑战,但不针对机器人,Ibarz等(10)列出了基于他们自己研究的案例研究中现实世界机器人环境中特有的DRL开放挑战。相比之下,我们的讨论基于对DRL在机器人领域取得的现实世界成功的全面评估,其中一个方面是对现实世界部署水平的评价(见第3.4节)。

其次,我们提出了一个新颖且全面的分类法,从多个角度对DRL解决方案进行分类:通过DRL学习的机器人能力、问题的表述、解决方案的方法以及现实世界成功的水平。以往关于机器人强化学习和更广泛的机器人学习的综述通常集中在特定任务(11, 12)或特定技术(13, 14)上。相比之下,我们的分类法允许我们调查在机器人应用领域有效的DRL解决方案的完整图景,此外,还分别回顾了每个应用领域的文献。在此框架内,我们对解决方案进行比较和对比,识别共同模式、广泛适用的方法、未充分探索的领域以及实现成功机器人系统的开放挑战。

第三,尽管一些过去的综述分享了我们对该领域进行广泛分析的动机,但DRL快速而令人印象深刻的进展需要对该领域、其成功和局限性进行重新分析。Kober等(15)的开创性综述是在深度学习时代之前撰写的,而Sunderhauf等(16)关于机器人深度学习的一般综述撰写时,DRL的成就主要是在模拟中。我们通过专注于DRL提供了该领域的最新概述,DRL是机器人强化学习最显著的现实世界成功背后的驱动力,特别关注过去五年中发表的论文,因为大多数成功都发生在这段时间内。

分类法

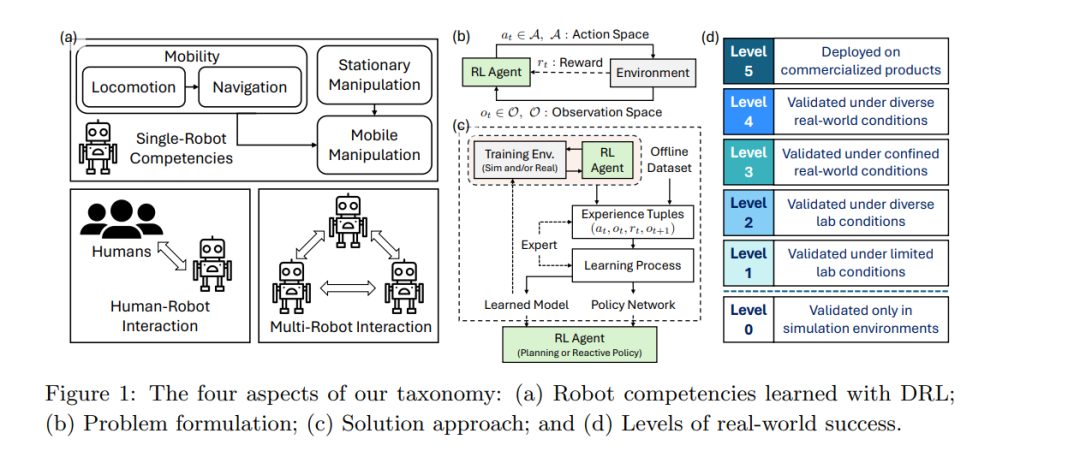

本节介绍我们用于分类深度强化学习(DRL)文献的新分类法。由于我们对DRL在机器人领域现实世界成功的独特关注,新的分类法可以对文献进行分类和分析,从而评估DRL解决方案在各种机器人应用中的成熟度,并从成功与失败中汲取宝贵的经验教训。具体而言,我们应识别每篇论文所解决的特定机器人问题,了解其如何抽象为强化学习问题,并总结为解决该问题所应用的DRL技术。更重要的是,我们应评估这些DRL解决方案在实验中展示的成熟度。因此,我们引入了跨四个轴的分类法:通过DRL学习的机器人能力、问题表述、解决方案方法以及现实世界成功的水平。

**通过DRL学习的机器人能力

我们的主要轴侧重于每篇论文研究的目标机器人任务。机器人任务,尤其是在开放的现实世界场景中,可能需要多种能力。可以应用DRL来综合一个端到端系统以实现所有能力,或者学习子模块来实现其中的一部分能力。由于我们专注于DRL,因此我们根据通过DRL学习和实现的具体机器人能力对论文进行分类。我们首先将这些能力分类为单机器人——机器人独立完成任务所需的能力,以及多智能体——与共享工作空间并影响其任务完成的其他智能体交互所需的能力。

当单个机器人在工作空间中完成任务时,它所需的任何能力都可以被视为实现与物理世界交互和影响的具体方式,进一步分为移动性——在环境中移动——和操作性——移动或重新安排(例如抓取、旋转)环境中的物体(17, 18, 19)。在机器人文献中,移动性通常分为两个问题:运动能力和导航能力(18, 20)。运动能力侧重于使各种形态的机器人(例如四足机器人、人形机器人、轮式机器人、无人机)能够穿越不同环境的运动技能,而导航能力侧重于引导机器人高效且无碰撞地到达目的地的策略。典型的导航策略生成高层次运动命令,例如质心(CoM)的期望状态,同时假设有效的运动控制来执行这些命令(18)。有些工作同时解决了运动和导航问题,这对于导航策略受到机器人穿越环境能力(由机器人动力学和运动控制决定)严重影响的任务特别有用,例如穿越困难地形(20)或竞速(21)。我们将这些论文与其他导航论文一起审查,因为它们的最终目标是导航。

在机器人文献中,操作性通常在桌面环境中研究,例如安装在固定底座上的机器人手臂或手,固定传感器观察场景。一些其他现实世界任务进一步要求机器人在移动底座的同时与环境交互(例如家用和仓库机器人),这需要操作性和移动能力的协同整合。我们在固定操作性类别下审查前一种情况,在移动操作性类别下审查后一种情况。

当任务完成受到工作空间内其他智能体影响时,机器人需要进一步具备与其他智能体交互的能力,我们将其归入多智能体能力类别。需要注意的是,在机器人与其他智能体交互时,仍可能需要某些单机器人能力,例如人群导航或协作操作。在此类别中,我们重点关注在智能体交互层面进行DRL的论文,即在给定某些单机器人能力的情况下学习交互策略,或学习联合优化交互和单机器人能力的策略。根据机器人交互的智能体类型,我们将这些工作进一步分为两个子类别:1)人机交互,关注机器人与人类一起操作的能力。人类的存在带来了额外的挑战,因为他们行为复杂且对机器人在其周围操作有严格的安全要求。2)多机器人交互,指机器人与一组机器人交互的能力。通常使用一类强化学习算法——多智能体强化学习(MARL)来解决此问题。在MARL中,每个机器人都是一个学习智能体,根据其与环境和其他机器人的交互来演变其策略,这使得学习机制更加复杂。根据机器人目标是否一致,它们的交互可能是合作的、对抗的或一般总和的。此外,实际场景通常需要在部分可观测性和有限通信带宽下进行分散决策。

**问题表述

分类法的第二个轴是强化学习问题的表述,这指定了针对目标机器人能力的最优控制策略。RL问题通常建模为单智能体RL的部分可观测马尔可夫决策过程(POMDP)和多智能体RL的分散POMDP(Dec-POMDP)。具体而言,我们根据以下问题表述元素对论文进行分类:1)动作空间:动作是低级别(即关节或电机命令)、中级别(即任务空间命令)还是高级别(即时间延伸的任务空间命令或子例程);2)观测空间:观测是高维传感器输入(例如图像和/或LiDAR扫描)还是估计的低维状态向量;3)奖励函数:奖励信号是稀疏的还是密集的。由于篇幅限制,这些术语的详细定义见补充材料。

**解决方案方法

另一个与前一个轴密切相关的轴是用于解决RL问题的解决方案方法,它由RL算法和相关技术组成,能够为目标机器人问题提供实际解决方案。具体而言,我们从以下角度对解决方案方法进行分类:1)模拟器使用:是否以及如何使用模拟器,分为零样本、少量样本模拟到现实转移,或直接在现实世界中离线或无模拟器学习;2)模型学习:是否从机器人数据中学习(部分)过渡动态模型;3)专家使用:是否使用专家(例如人类或预言策略)数据来促进学习;4)策略优化:采用的策略优化算法,包括计划或离线、离政策或在政策RL;5)策略/模型表示:用于表示策略或动态模型的神经网络架构类别,包括MLP、CNN、RNN和Transformer。详细术语定义见补充材料。

**现实世界成功水平

为了评估DRL在现实世界机器人任务中的实用性,我们根据其DRL方法的成熟度对论文进行分类。通过比较不同机器人任务中DRL的有效性,我们旨在识别研究原型与现实世界部署之间差距较大或较小的领域。这需要一个量化各任务现实世界成功水平的指标,据我们所知,这在DRL机器人文献中尚未尝试过。受自动驾驶等级(22)和机器学习技术成熟度等级(TRL)(23)的启发,我们引入了现实世界成功等级的概念。我们将论文分为六个等级,基于所验证方法的情境:1)等级0:仅在模拟中验证;2)等级1:在有限的实验室条件下验证;3)等级2:在多样的实验室条件下验证;4)等级3:在有限的现实世界操作条件下验证;5)等级4:在多样、具有代表性的现实世界操作条件下验证;6)等级5:在商业化产品中部署。我们认为等级1-5至少在某种程度上实现了现实世界的成功。我们可以用来评估现实世界成功等级的唯一信息是作者报告的实验。然而,许多论文仅描述了单次现实世界试验。虽然我们努力提供准确的估计,但由于信息有限,这种评估可能具有主观性。此外,我们使用现实世界成功等级来量化解决方案在其目标问题上的成熟度,而不考虑其复杂性。

结论

深度强化学习(Deep Reinforcement Learning)近年来在开发许多机器人能力方面发挥了重要作用,取得了许多现实世界的成功。在本文中,我们回顾并分类了这些成功案例,基于特定的机器人能力、问题表述和解决方案方法对其进行了描述。通过这些轴向的分析,我们揭示了普遍趋势和未来工作的重要方向,包括算法和程序的改进、现实世界学习的要素,以及整合本文所讨论的所有能力的整体方法。利用强化学习的力量来构建具有能力的现实世界机器人系统,需要解决其应用中的基本挑战和创新;尽管如此,我们预计强化学习将在开发普遍智能机器人方面继续发挥核心作用。