深度学习有望从数据中学习复杂的模式,特别是当输入或输出空间很大时。在机器人学习中,输入(如图像或其他传感器数据)和输出(如关节角度等动作)都可能很大,这暗示深度学习可能特别适合解决机器人学领域的挑战性问题。

然而,与大多数机器学习应用不同,机器人学习涉及物理约束,使得标准的学习方法面临挑战。机器人昂贵,通常需要人工介入以重置环境和修复硬件。这些约束使得大规模的数据收集和训练变得困难,为应用当前的数据密集型算法设置了一个主要的障碍。机器人学习在评估方面还有一个额外的障碍:每个物理空间都是不同的,这使得实验室之间的结果不一致。

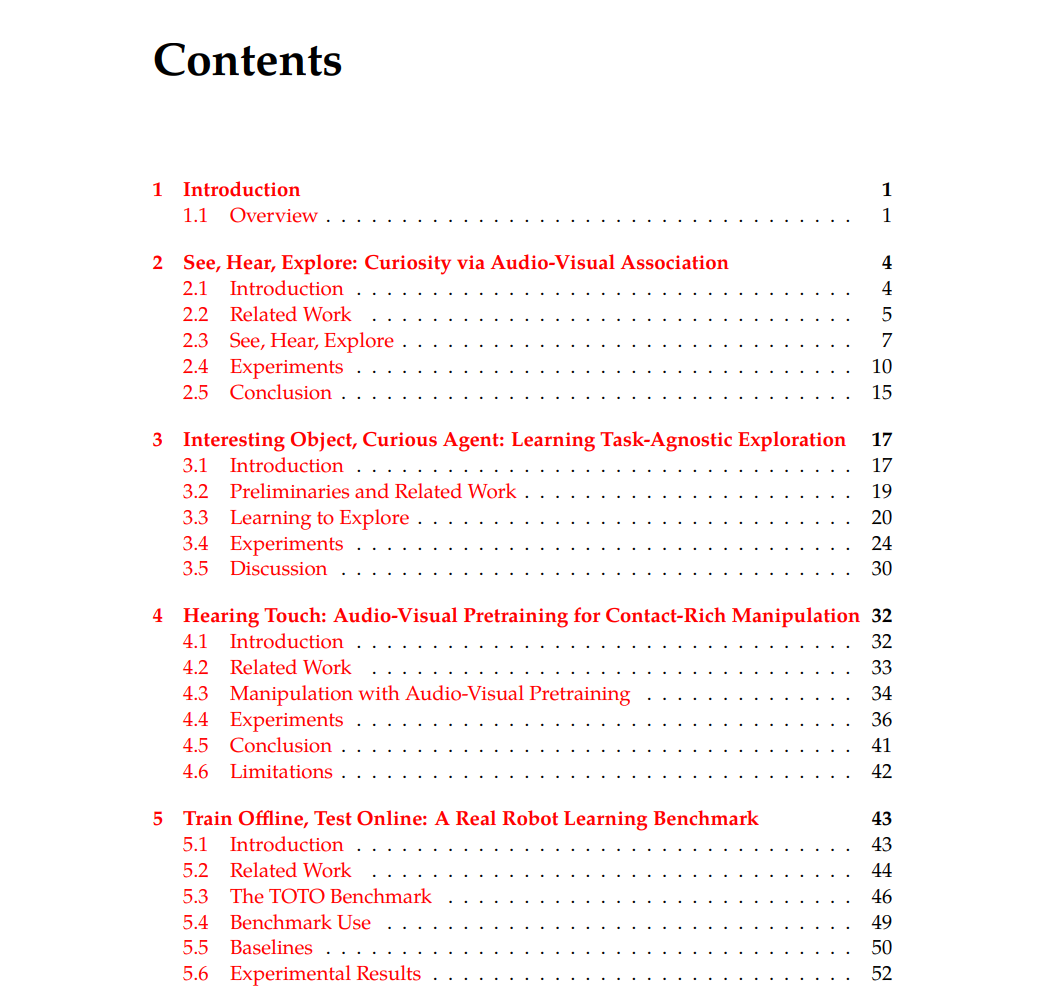

机器人学习范例的两个常见假设限制了数据效率。首先,一个代理通常假设独立的环境和没有先前的知识或经验 —— 学习是从零开始的。其次,代理通常只接收图像观察作为输入,仅依赖视觉来学习任务。但在现实世界中,人类在多个环境中通过多种感官学习,并在学习新任务时带有先前的经验。这种方法不仅是实际的,而且在实际的机器人技术中也是至关重要的,因为从部署的物理系统中收集大量样本在成本上是不切实际的。 在这篇论文中,我展示了一项工作,通过利用多模态和预训练来提高机器人学习的数据效率。首先,我展示了如何通过多模态感知,如视觉和听觉,提供丰富的自监督(第2章)。其次,我介绍了一个框架,用于预训练和评估通过环境转移的自监督探索(第3章)。在第4章中,我将这些想法应用于实际的操作,结合了大规模预训练和多模态的好处,通过音频-视频预训练来为接触式微型麦克风提供训练。最后,根据第3章的基准测试工作,我介绍了一个真实的机器人基准,用于通过共享数据和硬件评估视觉和策略学习方法的泛化能力(第5章)。

想象一个婴儿玩一个她从未见过的物体。她摇晃它并听那噪音。她观察她的父母来了解它是如何使用的。尽管这些行为对成年人来说可能看起来并不聪明,但婴儿的学习方式却充分利用了他们早期生活的丰富性。他们利用所有的感官;他们寻求创意的反馈;他们在周围的世界的多样性中茁壮成长 [133]。我认为这些行为是为了构建更好的智能体而得到的灵感。具体来说,我旨在通过利用自监督、多模态和先前的经验来提高机器人的学习能力。强化学习(RL)允许系统超越被动学习,并在与世界互动的同时从这些互动中学习。在标准的RL范式中,研究者手动指定一个奖励函数(得分),代理则学会最大化这一奖励。这在Atari或围棋这样的游戏中效果很好,但在机器人技术这样的应用中,奖励函数很难制定,而且从现实世界的数据中学习需要样本效率。RL的挑战可以分为两个领域:如何在一个环境中收集有趣的数据(探索)和如何从这样的数据中学习任务(策略学习)。在我的论文中,我探讨了如何改进探索和策略学习,使RL在真实世界的环境中变得可行。目前的RL探索框架是儿童探索世界方式的差劲代理。RL代理往往从零开始(在一个环境中从零开始初始化)并且只使用视觉或状态向量,而忽略了其他感觉模态。在这篇论文中,我旨在使探索更加符合真实世界:代理使用大规模数据(来自先前的环境和被动来源)有效地将知识转移到新的环境中,其中自监督和多模态引导快速适应。