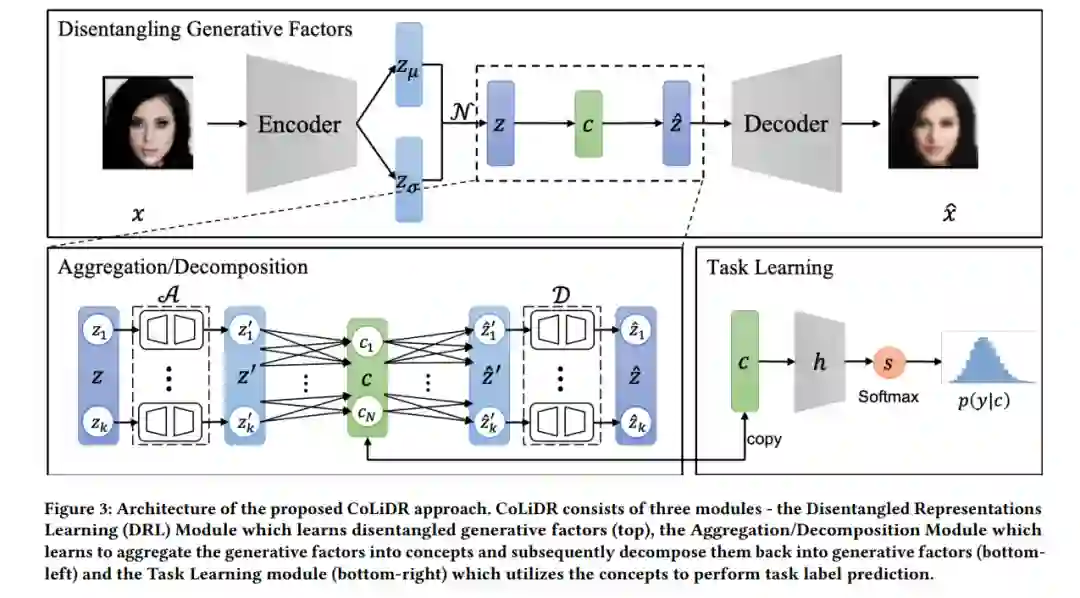

深度神经网络的可解释性通过基于概念的模型提供了一种有前景的方式来通过人类可理解的概念解释模型行为。一条平行的研究方向专注于将数据分布解缠为其潜在生成因素,从而解释数据生成过程。虽然这两个方向都得到了广泛关注,但很少有工作在解释概念方面着重于生成因素,以统一数学上解缠的表示和人类可理解的概念作为下游任务的解释。在本文中,我们提出了一种新方法CoLiDR - 它利用解缠表示学习框架来学习相互独立的生成因素,并随后学习通过一种新颖的聚合/分解模块将这些表示聚合成可理解的人类概念。在具有已知和未知潜在生成因素的数据集上进行了实验。我们的方法成功地将解缠的生成因素聚合成概念,同时保持了与基于概念的最新方法的对等性。对学习到的聚合过程进行的定量和视觉分析展示了我们的方法相比常用的基于概念的模型在四个具有挑战性的数据集上的优势。最后,我们的工作可以推广到任意数量的概念和生成因素,使其足够灵活,适用于各种类型的数据。

成为VIP会员查看完整内容

相关内容

Arxiv

225+阅读 · 2023年4月7日