Sora的到来标志着文本到视频扩散模型新时代的开始,为视频生成及其潜在应用带来了显著的进步。然而,Sora以及其他文本到视频扩散模型高度依赖于提示(prompt),而且目前没有公开可用的数据集专门研究文本到视频的提示。在本文中,我们介绍了VidProM,这是第一个大规模数据集,包含来自真实用户的167万个独特的文本到视频提示。此外,该数据集还包括由四种最先进的扩散模型生成的669万个视频和一些相关数据。我们首先展示了这个大规模数据集的策划过程,这是一个耗时且成本高昂的过程。随后,我们展示了所提出的VidProM与DiffusionDB(一个用于图像生成的大规模提示库数据集)的不同之处。基于这些提示的分析,我们认识到需要一个专门为文本到视频生成设计的新提示数据集,并获得了关于真实用户在创建视频时的偏好见解。我们的大规模和多样化的数据集也激发了许多令人兴奋的新研究领域。例如,为了开发更好、更高效、更安全的文本到视频扩散模型,我们建议探索文本到视频提示工程、高效视频生成和扩散模型的视频复制检测。我们在GitHub和Hugging Face上公开提供收集的数据集VidProM,并在CC-BY-NC 4.0许可下提供。

https://arxiv.org/pdf/2403.06098.pdf

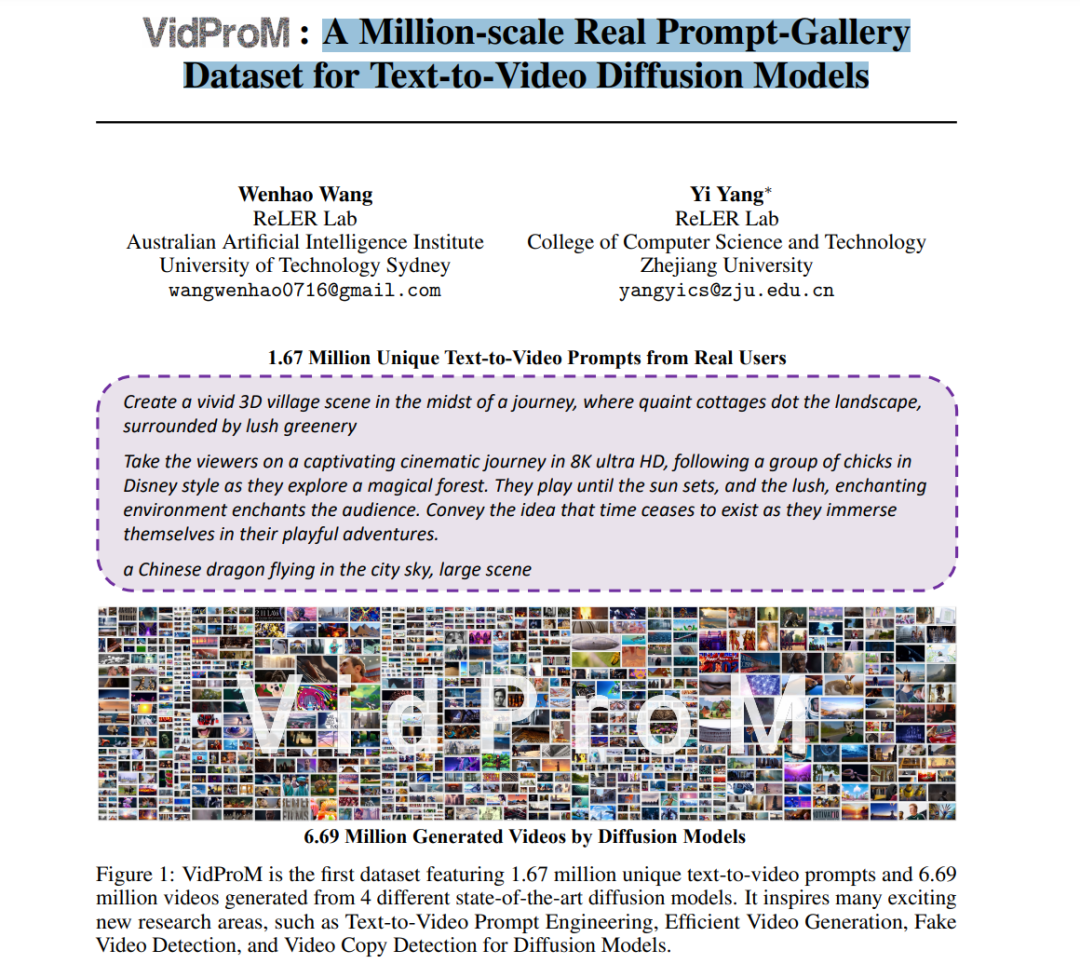

Sora [6] 的出现为文本到视频扩散模型开启了一个新时代,通过显著的进步彻底改变了视频生成。这一突破为讲故事、沉浸式体验和内容创造提供了新的可能性,因为 Sora [6] 能够轻松地将文本描述转换成高质量视频。然而,Sora [6] 和其他文本到视频扩散模型 [9, 1, 3, 5] 高度依赖于使用的提示。尽管这些提示非常重要,但目前没有专注于文本到视频提示的公开可用数据集,这限制了这些模型的开发和评估。 在本文中,我们呈现了对文本到视频提示的首次系统研究。具体而言,我们的工作主要集中在构建第一个文本到视频提示库数据集VidProM,与DiffusionDB [22] 进行深入比较,分析用户偏好的主题,并基于我们的VidProM引入新的研究方向。VidProM的展示如图 1 所示。 * 第一个文本到视频提示库数据集。我们的大规模VidProM包含来自真实用户的167万个独特文本到视频提示和由4种最先进扩散模型生成的669万个视频。这些提示来自官方Pika Discord频道,视频由Pika [9]、Text2Video-Zero [1]、VideoCraft2 [3]和ModelScope [5]生成。我们在配备了8个Nvidia V100 GPU的10台服务器上分配生成过程。每个提示使用OpenAI的强大text-embedding-3-large模型进行嵌入,并分配了六个不适宜工作场合(NSFW)的概率,包括毒性、淫秽、身份攻击、侮辱、威胁和性明示。我们还为VidProM中的每个数据点添加了一个通用唯一标识符(UUID)和时间戳。除主数据集外,我们还介绍了一个名为VidProS的子集,包含语义唯一的提示。在这个子集中,任意两个提示之间的余弦相似度小于0.8,确保了高水平的语义多样性。

与DiffusionDB的深入比较和人们偏好分析。我们注意到存在一个文本到图像提示库数据集DiffusionDB [22]。通过分析基本信息和提示,我们得出结论,我们的VidProM与DiffusionDB [22]的差异在于:(1)我们的VidProM包含更多语义唯一的提示,这些提示由更高级的模型嵌入并收集了更长的时间跨度。(2)我们通过网络抓取和本地生成收集视频,而DiffusionDB [22]只包含网络抓取的图像,导致我们的数据集更耗时和成本更高。(3)我们的提示语义与DiffusionDB中的显著不同,我们的文本到视频提示通常更加动态、更复杂且更长。这些差异凸显了收集专门为文本到视频扩散模型设计的新提示数据集的必要性。基于我们对新提示数据集的分析,我们得出结论:(1)频繁出现的词包括‘modern’、‘motion’、‘close’、‘forest’和‘sky’;(2)偏好的主题包括人类、科幻和动物。

激发新的研究方向。我们新的文本到视频提示库数据集VidProM的引入,开启了众多令人兴奋的研究方向。研究者专注于开发更好、更高效、更安全的文本到视频扩散模型:(1)为了更好的模型,研究者可以利用我们的VidProM作为一个全面的提示集来评估他们训练的模型,使用我们的提示-(生成的)-视频对新模型进行提炼,并参与提示工程。(2)为了更高效的模型,研究者可以在我们的VidProM中搜索相关的提示,并从相似的现有视频中重构新视频,从而避免从头开始生成视频的需要。(3)为了更安全的模型,研究者可以开发专门的模型来区分生成的视频和真实视频,以对抗错误信息,并训练视频复制检测模型来识别潜在的版权问题。除了扩散模型外,文本-视频对也在多模态学习任务中得到利用,如视频-文本检索和视频字幕。我们的提示和合成视频可以帮助缓解使用在线视频相关的版权问题,并减轻收集高质量视频-文本数据的困难。

总而言之,本文作出了以下贡献:(1)我们贡献了第一个文本到视频提示库数据集VidProM,包含来自真实用户的167万个独特提示和由4种最先进扩散模型生成的669万个视频。(2)我们提供了与文本到图像提示库数据集DiffusionDB的详细深入比较,并强调了VidProM以及真实用户偏好的必要性。(3)我们揭示了VidProM激发的几个令人兴奋的研究方向,并将其定位为未来研究的丰富数据库。