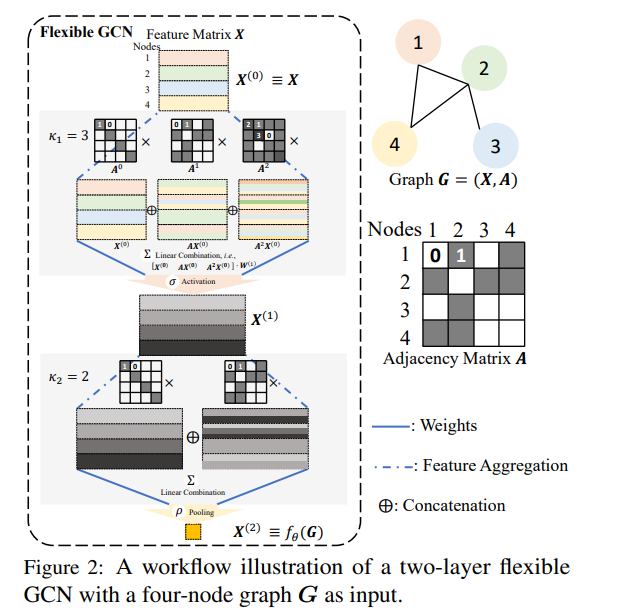

推断图结构数据的属性(例如分子溶解度)本质上涉及从图到其属性的隐式映射的学习过程。对于诸如图卷积网络(Graph Convolutional Networks,GCNs)等图属性学习器而言,这一学习过程通常代价高昂。为了解决这一问题,我们提出了一种称为图神经教学(Graph Neural Teaching,GraNT)的新范式,该范式通过一种新颖的非参数化教学视角重新诠释了学习过程。 具体而言,该非参数化教学方法为通过示例选择来教授隐式定义(即非参数化)映射提供了理论框架。GraNT 中的这种隐式映射是由密集的图-属性对构成的,教学者(teacher)从中选择一个子集,以促进 GCN 训练的更快收敛。 通过分析图结构在基于参数的梯度下降训练中的影响,并将 GCN 参数更新所驱动的演化过程重新表述为非参数化教学中的函数梯度下降(functional gradient descent),我们首次证明了教授图属性学习器(如 GCNs)在理论上等价于教授具备结构感知能力的非参数化学习器。 这一发现使 GraNT 能够自然地致力于提升图属性学习器的学习效率。实验证明,在保持泛化性能的同时,GraNT 显著减少了训练时间:图级回归任务减少了 36.62%,图级分类减少了 38.19%,节点级回归减少了 30.97%,节点级分类减少了 47.30%。

成为VIP会员查看完整内容

相关内容

Arxiv

40+阅读 · 2023年4月19日

Arxiv

210+阅读 · 2023年4月7日