作为图结构数据的基本元素,节点被认为是图表示学习的主要研究对象。单个节点直观上具有整个图的多个以节点为中心的子图(例如,社交网络中的一个人根据其不同的关系具有多个社交圈)。在图对比学习框架下研究了这种直觉,提出了一种多节点为中心的子图对比表示学习方法,以自监督的方式学习图上的节点表示。具体而言,我们仔细设计了一系列以中心节点为中心的区域子图。然后,通过对比损失最大化同一节点的不同子图之间的互信息。在各种真实数据集和不同下游任务上的实验表明,我们的模型取得了最先进的结果。

图表示学习最近受到越来越多的关注[5],其目的是将高维图结构化数据转换为低维稠密的向量表示。作为图结构化数据的基本元素,节点表示已成为图表示学习的主要对象。一个全面的节点表示可以很好地用于各种下游任务,如节点分类[14]和链接预测[3]。一种广泛使用的图表示学习方法是图神经网络(GNN)的应用[4, 14, 29, 32, 40]。但大多数此类方法都侧重于监督学习,依赖于图中的监督信号。对于现实世界的网络,这些监督信号的获取往往繁琐而昂贵。自监督学习[11]是近年来的一个热门研究领域,它为无标签数据设计代理任务,以挖掘数据本身的表征性质作为监督信息。

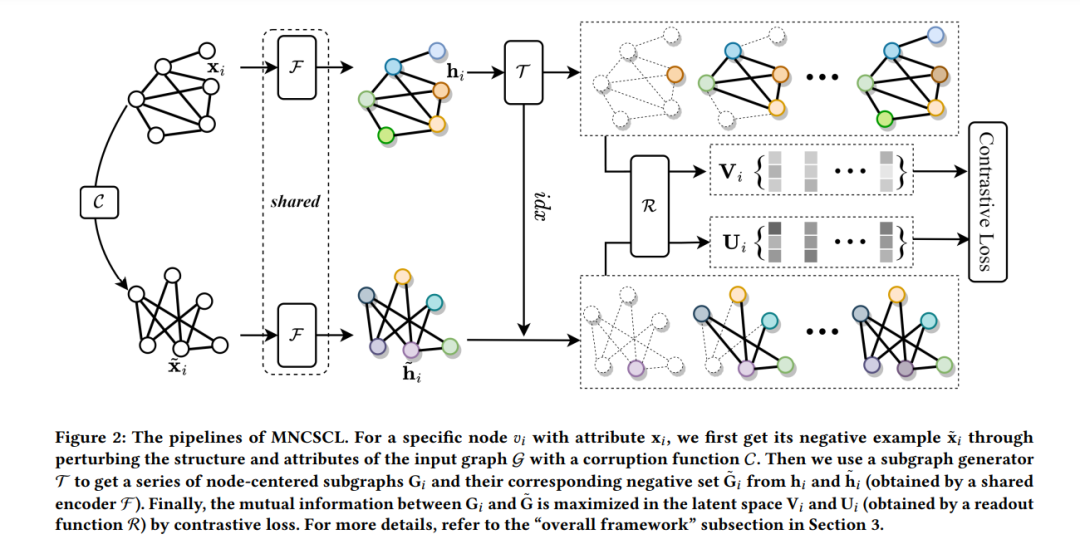

图互信息(GMI)[23]不使用损坏函数,而是最大化节点隐藏表示与其原始局部结构之间的MI。另一方面,图信息簇(GIC)[19]在DGI的基础上最大化节点表示与其对应的簇表示之间的MI。虽然这些方法取得了许多进展,但它们都专注于节点嵌入与仅一个相关图结构之间的MI,如图1所示。在现实中,我们可以从多个角度看待一个特定的事情。对于图数据,我们可以从多个角度观察图中的单个节点,但很少有文献关注这一点。直观地讲,对于社交网络中的个人来说,可能有一个基于血缘关系的亲戚社交圈,一个基于工作关系的同事社交圈,以及其他具有许多不同兴趣的朋友社交圈。如果我们从这些不同的社交圈中分析这个个人,实际上相当于从多个角度对该网络中的节点进行学习。基于此直觉,提出了多节点中心子图对比表示学习(MNCSCL).MNCSCL以网络中的每个节点为中心,在不同的语义下对其节点中心的区域子图进行采样,从而形成对应节点的几个不同视角,如图1所示.具体而言,首先通过corrupt函数生成一个负例,然后通过视图生成器生成原始图的一系列节点中心子图,并在负例上对对应子图进行采样.然后,将这些子图输入到图神经网络编码器中,在池化后获得中心节点及其子图的表示.最后,通过对比学习目标函数在潜空间中最大化同一节点的不同子图之间的互信息.在各种数据集上的实验结果表明,该设计具有优异的性能.论文的主要贡献如下:

• 提出了一种通过多个节点中心子图学习节点表示的新框架,从多个角度观察单个节点,是当前工作中的一个新思路。 • 我们仔细设计了五个节点中心子图,并通过大量实验分析了不同子图对节点表示学习质量的影响,具有参考意义。 • 我们在五个标准数据集和两个下游任务上评估了MNCSCL,以验证所提方法的有效性。我们的实验表明,多个子图的对比学习在结果上优于上述单个子图的对比学习。