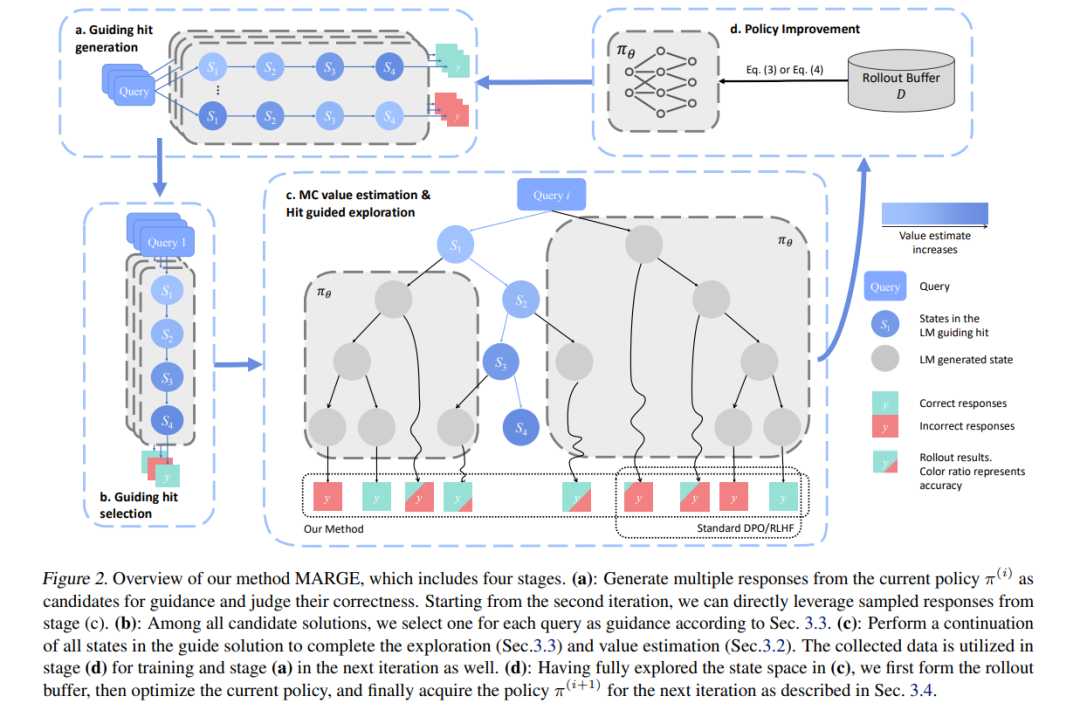

大型语言模型(LLMs)在数学推理方面展现出强大潜力,然而其效果常受限于高质量问题数量不足。为克服这一限制,研究者尝试通过自生成数据扩大计算响应规模,但现有方法在推理各阶段的探索效率较低,容易引入虚假的相关性数据,导致性能受限。为解决这一挑战,我们提出 MARGE(Improving Math Reasoning with Guided Exploration),这是一种通过命中引导探索(hit-guided exploration)提升数学推理能力的新方法。

MARGE系统性地探索由模型自生成解答中提取的中间推理状态,实现充分的推理空间探索,并在整个过程中改进归因机制。我们在多个主干模型与标准基准测试上的广泛实验表明,MARGE在不依赖外部标注或额外训练价值模型的前提下,显著提升了模型的推理能力。值得一提的是,MARGE同时提升了单轮推理准确率与探索多样性,有效缓解了现有对齐方法中常见的性能权衡问题。 实验结果表明,MARGE在增强数学推理能力、释放自生成训练数据的潜力方面具有显著效果。我们的代码与模型已开放获取,详见下方链接。

成为VIP会员查看完整内容

相关内容

Arxiv

40+阅读 · 2023年4月19日

Arxiv

210+阅读 · 2023年4月7日

Arxiv

79+阅读 · 2023年4月4日

Arxiv

142+阅读 · 2023年3月29日