基于Transformer的语言模型最近在许多自然语言任务中取得了显著的成果。然而,在排行榜上的表现通常是通过利用大量的训练数据和计算来实现的,而很少通过将显性语言知识编码到神经模型中来实现。这导致许多人质疑语言学与现代自然语言处理的相关性。在本论文中,我提出了几个案例研究,以说明如何理论语言学和深度神经语言模型仍然相互关联。首先,语言模型为语言学家提供了一个自动、客观的工具来测量语义距离,这是传统方法难以做到的。另一方面,语言学理论通过提供框架和数据来源,为语言理解的特定方面探索我们的语言模型,从而为语言建模研究做出贡献。

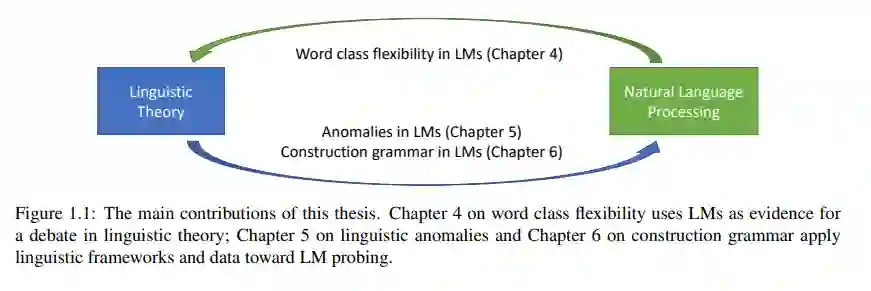

这篇论文贡献了三个研究,探讨了语言模型中语法-语义接口的不同方面。在论文的第一部分,我将语言模型应用于词类灵活性问题,这是理论语言学中一个长期争论的问题。使用mBERT作为跨多种语言的语义距离度量来源,我提出了支持将词类灵活性分析为定向过程的证据。在论文的第二部分,我提出了一种利用高斯模型进行密度估计的方法来测量语言模型中间层的惊讶度。我的实验表明,在语言模型中,包含形态句法异常的句子比语义和常识异常更早触发意外现象。最后,在我的论文的第三部分,我改编了几个心理语言学的研究,以表明语言模型包含论点结构结构的知识(从结构语法理论的动词配价分析)。总之,我的论文在自然语言处理、语言理论和心理语言学之间建立了新的联系,为语言模型的解释提供了新的视角。

成为VIP会员查看完整内容

相关内容

Transformer是谷歌发表的论文《Attention Is All You Need》提出一种完全基于Attention的翻译架构

Arxiv

16+阅读 · 2019年4月3日