人工智能(AI)系统正迅速成为美国日常生活的一部分。从客户服务、图像生成到生产制造,人工智能系统无处不在。

人工智能系统在带来变革潜力的同时,也带来了危害风险。这些风险包括不准确或错误的输出;非法的歧视性算法决策;破坏工作岗位和工作尊严;以及隐私、安全和安保受损。鉴于其影响力和普遍性,这些系统必须遵守安全和运行机制,以降低风险,并确保利益相关者相信它们不会造成伤害。

评论者强调了人工智能问责政策和机制如何在发挥这项技术的最佳效益方面发挥关键作用。人工智能生态系统的参与者--包括政策制定者、行业、民间社会、工人、研究人员和受影响的社区成员--应有权揭露问题和潜在风险,并追究责任实体的责任。

人工智能系统开发者和部署者应建立机制,优先考虑人类和环境的安全与福祉,并证明其人工智能系统按预期良性运行。问责政策的实施有助于建立一个稳健、创新和知情的人工智能市场,在这个市场中,人工智能系统的购买者知道他们在买什么,用户知道他们在消费什么,人工智能系统的主体--工人、社区和公众--知道系统是如何实施的。市场的透明度可以让公司在安全性和可信度方面展开竞争,并有助于确保人工智能不会以有害的方式部署。在信息的推动下,这种竞争不仅鼓励遵守最低基线,还鼓励随着时间的推移不断改进。

为了促进创新和采用值得信赖的人工智能,我们需要激励和支持对人工智能系统进行发布前和发布后评估,并酌情要求提供更多相关信息。对人工智能的能力、风险和适用性进行强有力的评估仍是一个新兴领域。为了实现真正的问责制并利用人工智能的所有益处,美国--乃至全世界--需要新的、更广泛可用的问责工具和信息,需要一个独立的人工智能系统评估生态系统,还需要那些未能兑现承诺或妥善管理风险的人承担后果。

正如联邦政府根据拜登总统 2023 年 10 月 30 日关于安全、可靠和可信的人工智能开发和使用的第 14110 号行政命令("人工智能行政命令")已经开展的工作所认识到的那样,在整个人工智能生命周期中,从模型的早期开发到部署和后续使用,通过适当的手段和各方获取信息非常重要。该信息流应包括有关人工智能系统模型、架构、数据、性能、限制、适当使用和测试的文件。人工智能系统信息应以适合相关受众的形式披露,包括以通俗易懂的语言披露。人工智能系统组件和流程应有适当的第三方访问权限,以促进对机器学习模型的充分可操作理解。

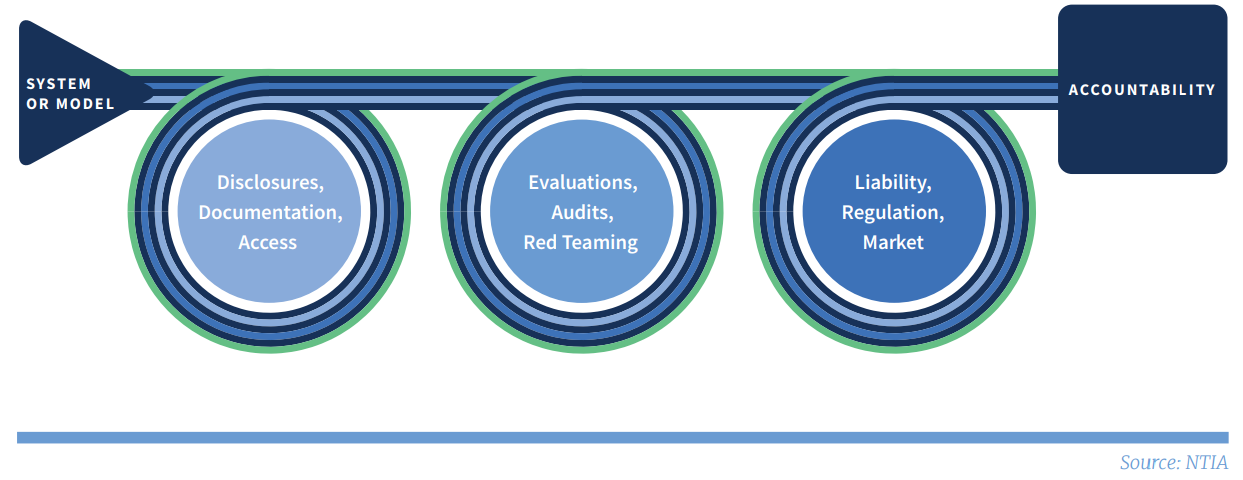

AI 问责链

对高风险人工智能系统进行独立评估,包括 "红队"、审计和性能评估,有助于核实这些系统的重要声明及其性能是否符合可信人工智能的标准。制定评估标准是审计工作的关键一环,审计方法和标准的透明度也同样重要。要制定这样的标准和做法,还需要做更多的工作;近期的工作,包括在《人工智能电子指令》下开展的工作,将有助于制定这些标准和方法。

在信息共享和独立评估的基础上,责任方的后果将需要应用和/或发展杠杆--如监管、市场压力和/或法律责任--以追究人工智能实体施加不可接受的风险或提出毫无根据的主张的责任。

本报告将问责制视为一个投入与后果相联系的链条。报告重点关注信息流(文件、披露和访问)如何支持独立评估(包括红队和审计),而独立评估又如何反过来影响后果(包括责任和监管),从而形成问责制。报告最后提出了联邦政府的行动建议,其中一些建议详细阐述了《人工智能行政 命令》中的主题,以鼓励并在可能的情况下要求问责投入。

2023 年 4 月,美国国家电信和信息管理局(NTIA)就围绕人工智能问责政策的一系列问题发布了一份征求意见稿(RFC)。RFC 征求了来自广泛利益相关者的 1,400 多条不同意见。此外,我们还会见了许多利益相关方,参与并审查了以 RFC 所提问题为重点的公开讨论。

根据这些意见,我们提出了八项主要政策建议,分为三类: 指导、支持和监管要求。其中一些建议结合并借鉴了美国国家标准与技术研究院(NIST)在人工智能风险管理方面的工作。我们还建议建设联邦政府的监管和监督能力,以便对人工智能系统进行严格评估,并帮助人工智能问责生态系统的发展。

虽然有些建议与其他建议密切相关,但决策者在独立考虑这些建议时不应犹豫。每项建议都将促进人工智能问责生态系统的发展,并降低人工智能系统加速部署所带来的风险。我们相信,提供有针对性的指导、支持和法规将促进形成一个生态系统,在这个生态系统中,人工智能开发者和部署者可以适当地承担责任,激励对风险进行适当的管理,并创建更值得信赖的人工智能系统。

对高风险人工智能系统进行独立评估,包括 "红队"、审计和性能评估,有助于核实这些系统的重要声明及其性能是否符合可信人工智能的标准。制定评估标准是审计工作的关键一环,审计方法和标准的透明度也同样重要。要制定这样的标准和做法,还需要做更多的工作;近期的工作,包括在《人工智能电子指令》下开展的工作,将有助于制定这些标准和方法。

在信息共享和独立评估的基础上,责任方的后果将需要应用和/或发展杠杆--如监管、市场压力和/或法律责任--以追究人工智能实体施加不可接受的风险或提出毫无根据的主张的责任。

本报告将问责制视为一个投入与后果相联系的链条。报告重点关注信息流(文件、披露和访问)如何支持独立评估(包括红队和审计),而独立评估又如何反过来影响后果(包括责任和监管),从而形成问责制。报告最后提出了联邦政府的行动建议,其中一些建议详细阐述了《人工智能行政 命令》中的主题,以鼓励并在可能的情况下要求问责投入。

2023 年 4 月,美国国家电信和信息管理局(NTIA)就围绕人工智能问责政策的一系列问题发布了一份征求意见稿(RFC)。RFC 征求了来自广泛利益相关者的 1,400 多条不同意见。此外,我们还会见了许多利益相关方,参与并审查了以 RFC 所提问题为重点的公开讨论。

根据这些意见,我们提出了八项主要政策建议,分为三类: 指导、支持和监管要求。其中一些建议结合并借鉴了美国国家标准与技术研究院(NIST)在人工智能风险管理方面的工作。我们还建议建设联邦政府的监管和监督能力,以便对人工智能系统进行严格评估,并帮助人工智能问责生态系统的发展。

虽然有些建议与其他建议密切相关,但决策者在独立考虑这些建议时不应犹豫。每项建议都将促进人工智能问责生态系统的发展,并降低人工智能系统加速部署所带来的风险。我们相信,提供有针对性的指导、支持和法规将促进形成一个生态系统,在这个生态系统中,人工智能开发者和部署者可以适当地承担责任,激励对风险进行适当的管理,并创建更值得信赖的人工智能系统。

指导

1.审计和审计师: 联邦政府机构应酌情与利益相关者合作,利用现有的和/或新的授权,为人工智能审计和审计人员制定指导方针。这包括 NIST 根据人工智能 EO 开展的有关人工智能测试和评估的任务,以及联邦政府为完善有关审计设计、审计主题、审计评估标准和审计人员认证标准等事项的指导而开展的其他工作。

2.信息披露和获取: 联邦政府机构应与利益相关方合作,利用现有的和/或新的授权,改进标准信息披露。例如,应向相关受众提供有关人工智能系统模型、架构、训练数据、输入和输出数据、性能、限制、适当使用和测试的更大透明度,包括在某些情况下通过模型或系统卡、数据表和/或人工智能 "营养标签 "向公众提供。无障碍格式的标准化和通俗语言的使用可提高披露信息的可比性和可读性。立法不是推进这项活动的必要条件,但可以加速这项活动。

3.责任规则和标准: 联邦政府机构应与利益相关方合作,就如何将现有的责任规则和标准应用于人工智能系统提出建议,并在必要时对其进行补充。这将有助于确定在整个价值链中,谁应对人工智能系统的伤害负责并承担责任。

支持

4.人员和工具: 联邦政府机构应支持并投资于技术基础设施、人工智能系统访问工具、人员和国际标准工作,以振兴问责制生态系统。这意味着通过现有的和新的能力建设必要的资源,以满足国家对人工智能系统进行独立评估的需求,包括

- 测试公平性、有效性及其他属性和目标的数据集;

- 进行严格评估所需的计算和云基础设施;

- 通过立法建立国家人工智能研究资源并为其提供资金;

- 研究人员、评估人员和监管人员可适当访问人工智能系统及其组件,但须遵守知识产权、数据隐私以及安全和安保方面的保护规定;

- 独立评估和红队支持,如通过奖金、赏金和研究支持;

- 劳动力发展;

- 具有相应社会技术专业知识的联邦人员,以设计、开展和审查评估;以及

- 制定国际标准(包括利益相关者的广泛参与)。

5.研究:联邦政府机构应通过现有的和新的能力,开展和支持更多与人工智能测试和评估相关的研究和开发、促进获取人工智能系统用于研究和评估的工具以及出处技术。这项投资将有助于创建可靠和广泛适用的工具,以评估人工智能系统的使用时间、培训材料以及其表现出的能力和局限性。2024 年 2 月在美国国家标准与技术研究院(NIST)成立的美国人工智能安全研究所就是朝着这个方向迈出的重要一步。

监管要求

6.审计和其他独立评估: 联邦机构应利用现有和/或新的授权,根据需要要求对高风险的人工智能模型类别和系统进行独立评估和监管检查。根据针对部署和使用情况的整体评估,被认为具有损害权利或安全的高风险的人工智能系统,在某些情况下应接受强制性独立评估和/或认证。对于某些模型和系统,这一过程应在发布或部署前进行(某些部门已经这样做了),并持续进行。为了进行这些评估,各机构可能需要要求其他问责投入,包括与系统和模型有关的文件和披露。一些政府机构已经有权确定风险类别,并要求进行独立评估和/或采取其他问责措施, 而其他机构则可能需要新的授权。

7.跨部门的政府能力: 联邦政府应加强其应对与人工智能相关的跨部门风险和做法的能力。无论是现有机构还是新机构,政府都应具备横向能力,以制定共同的基准要求和最佳做法,并以其他方式支持各机构的工作。这些跨部门任务可包括

- 对高风险人工智能部署、人工智能负面事件和人工智能系统审计进行登记;

- 在审计标准和/或审计师认证方面,倡导联邦机构的需求,并与联邦机构本身开展或要求的审计流程进行协调;以及

- 根据需要提供评估、认证、记录、协调和披露监督。

8.签订合同:联邦政府应要求政府供应商、承包商和受赠方对合同或赠款中使用的人工智能采用完善的人工智能治理和保证措施,包括酌情使用联邦机构认可的人工智能标准和风险管理措施。这将确保与联邦政府签订合同或接受联邦赠款的实体制定健全的内部人工智能系统保证。这一细分市场中的此类做法可加快更广泛的采用,并改善整个经济中的人工智能问责生态系统