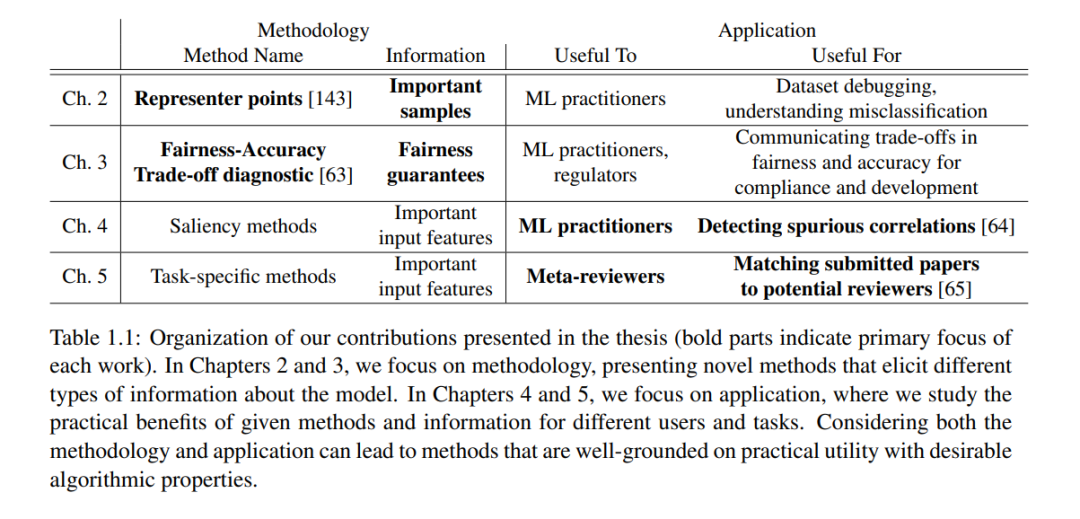

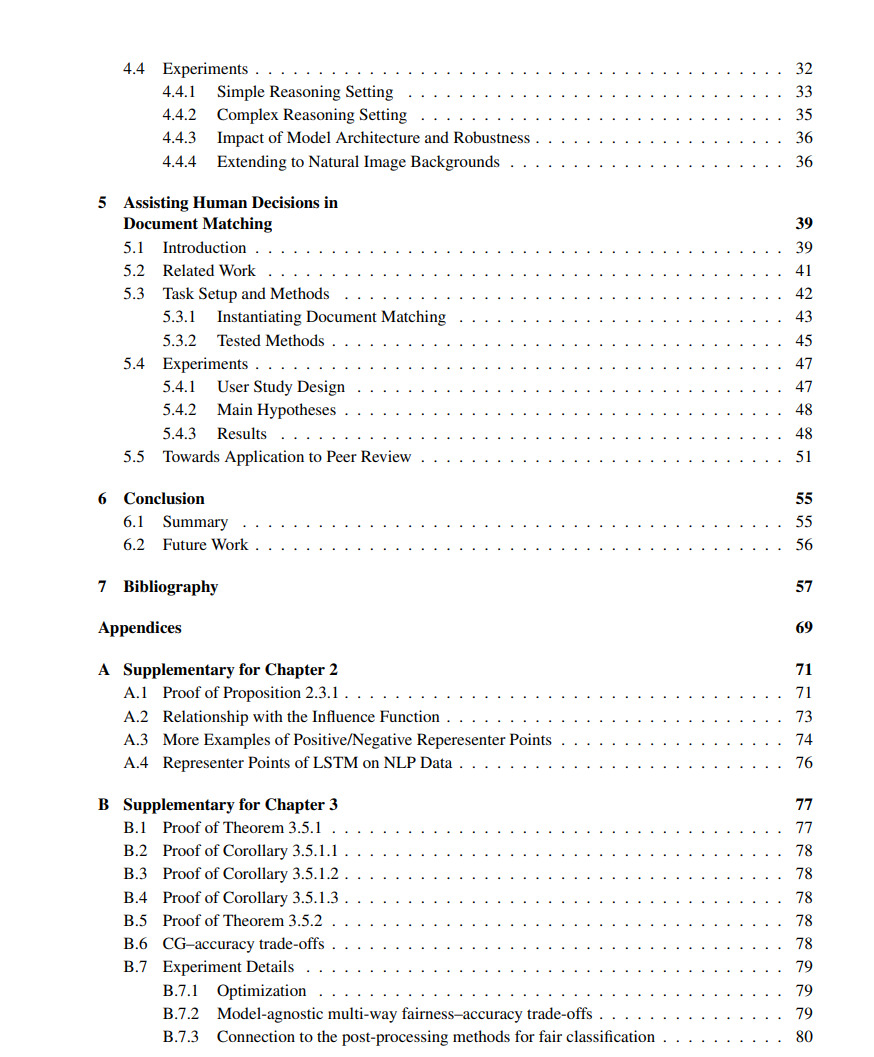

随着机器学习模型在各种应用中的部署越来越频繁,我们越来越需要更好地理解、交互和调节它们的行为。解释性机器学习是一个致力于这一需求的研究领域,其主要焦点最初在满足有利于揭示有关模型预测的可能有用信息的算法属性的方法论发展。然而,批评也强调了需要更为严谨地评估这些方法在不同用户的具体任务中的应用。在这篇论文中,我们对该领域的方法论和应用方面做出了我们个人的贡献。在方法论上,我们提出了一种有效的算法,通过影响力大的训练数据点提供关于模型行为的重要信息。然后,我们提出了一种理论框架,以理解模型在性能和公平性指标上的权衡。接下来,从应用驱动的角度,我们讨论了一个评估框架,测试现有的图像显著性方法是否适用于实际的假相关检测任务。最后,受到学术同行评审中实际问题的启发,我们展示了我们对新的和现有的方法在帮助人类用户进行文档匹配任务方面的效用的发现。

在计算机视觉和自然语言处理等实践领域表现出色的复杂机器学习模型,越来越多地被用来协助人类进行高风险的决策,如医疗、金融、法律和社会应用。这种加速的采用使得人类用户越来越需要更好地理解、调节和与这些模型交互。解释性机器学习是一个致力于这一需求的广泛研究领域。许多文献中的工作侧重于方法论的发展:开发新的满足各种技术目标的方法,可以有效地从一个黑盒机器学习模型中引出重要和有用的信息。然而,这些方法使用的各种技术目标与引出的信息的实际“重要性”或“有用性”没有明确的联系,这本质上依赖于用户使用信息进行某些下游任务。因此,基于具体应用对开发的方法进行评估,对于完全闭环开发具有实用价值的新方法至关重要。在这篇论文中,我们提出了对这个领域的方法论和应用重点方面的个人贡献。

成为VIP会员查看完整内容