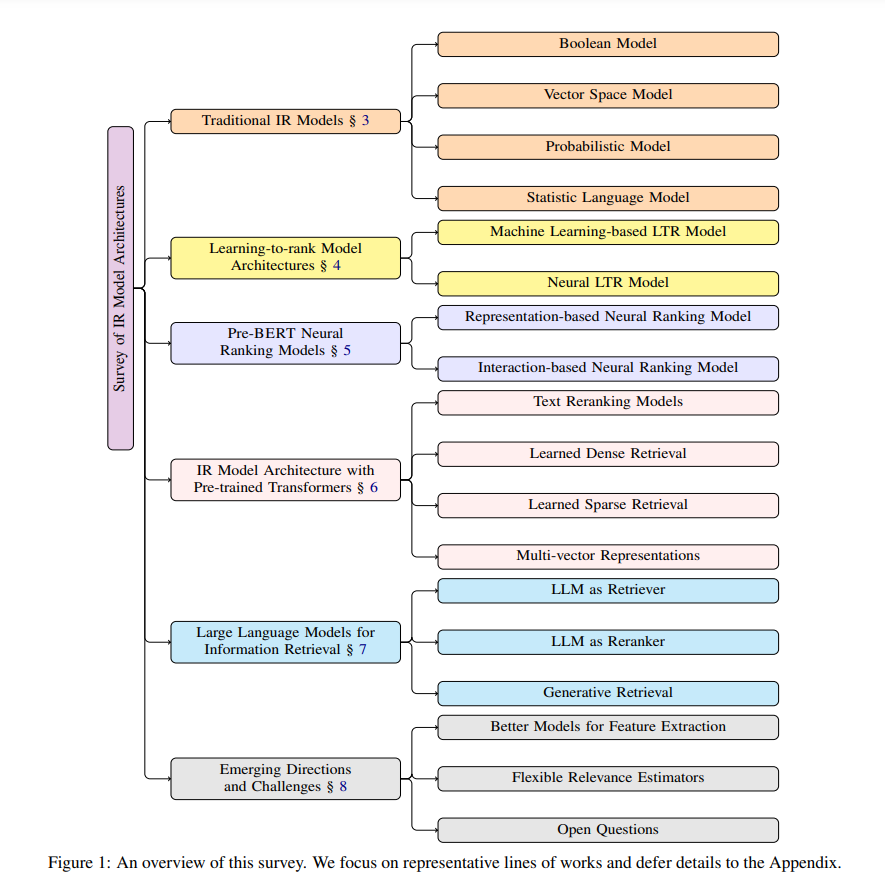

本综述研究了信息检索(IR)中模型架构的发展,重点关注两个关键方面:用于特征提取的骨干模型和用于相关性估计的端到端系统架构。本文有意将架构考虑与训练方法区分开,以便对IR系统中的结构性创新进行集中分析。我们追溯了从传统基于术语的方法到现代神经网络方法的发展,特别突出变换器(transformer)模型以及随后的大规模语言模型(LLM)所带来的影响。最后,我们讨论了新兴的挑战和未来的发展方向,包括性能和可扩展性的架构优化、多模态和多语言数据的处理,以及如何适应超越传统搜索范式的新应用领域。

1 引言

信息检索(IR)的目标是检索相关的信息源,以满足用户的信息需求。在过去几十年中,信息检索已经成为高效、有效地访问大量信息的重要工具,广泛应用于各类场景。除了其传统作用,信息检索如今还在协助大规模语言模型(LLM)生成有依据和事实性的响应方面发挥着至关重要的作用。信息检索的研究主要集中在两个关键方面:(1)提取更好的查询和文档特征表示;(2)开发更精确的相关性估计方法。查询和文档特征提取方法经历了从传统的基于术语的方法(如布尔逻辑和向量空间模型)到基于预训练语言模型的稠密检索等现代解决方案的演变(Lin et al., 2022)。相关性估计方法则随着特征表示的进展而发展。早期方法,包括概率性和统计性语言模型,使用基于术语特征的简单相似度函数计算相关性。之后,学习排序(LTR)技术应运而生,结合了机器学习模型和多层神经网络用于相关性估计(Li, 2011)。LTR方法的成功在很大程度上归功于其广泛使用手工设计的特征,这些特征源自文本术语的统计属性以及从网页浏览流量中收集的用户行为数据(Qin and Liu, 2013)。在2010年代,大量文献探讨了不同架构中的神经网络重排序模型,以捕捉查询与文档之间的语义相似度。随后,预训练的变换器模型,代表作BERT(Devlin et al., 2019),迅速革新了模型设计,进入了一个检索与排序模型采用更简化架构进行相关性估计的时代,例如基于学习到的神经表示的点积操作和多层感知机(MLP)层预测头(Karpukhin et al., 2020;Nogueira et al., 2020;Lin et al., 2022)。近年来,LLM的进展彻底改变了应用机器学习(ML)领域,包括信息检索。LLM的一个有趣特性是它们可以用于特征提取和相关性估计,并且在没有大量训练的情况下就能取得强大的性能(Ni et al., 2022a;Neelakantan et al., 2022;BehnamGhader et al., 2024;Sun et al., 2023;Qin et al., 2024a,等等)。LLM在信息检索中的崛起,建立在变换器(transformer)预训练语言模型的丰富基础上,这些模型已从早期的神经网络架构中发展而来,包括变换器(Vaswani et al., 2017)、递归神经网络(RNN,Elman, 1990)、注意力机制(Bahdanau, 2014)以及预训练的静态神经表示,如Word2Vec(Mikolov, 2013)和GloVe(Pennington et al., 2014)。本文回顾了信息检索中模型架构的演变(如图1所示)。在这里,模型架构的意义是双重的:它描述了(1)用于提取查询和文档特征表示的骨干模型;(2)处理原始输入、执行特征提取和估计相关性的端到端系统架构。与之前的研究和调查(Lin et al., 2022;Zhu et al., 2023)不同,我们有意将模型架构的讨论与训练方法和部署最佳实践分开,以提供一个更聚焦的架构分析。向神经架构的转变,特别是基于变换器的模型,已经从根本上改变了信息检索,使得更丰富、上下文化的表示成为可能,并改善了对复杂查询的处理。尽管这种演变提高了检索精度,但也带来了新的挑战,尤其是随着LLM的出现。这些挑战包括需要架构创新以优化性能和可扩展性,处理多模态和多语言数据,以及整合领域特定的知识。此外,随着信息检索系统越来越多地被集成到各类应用中——从机器人技术(Xie et al., 2024)、自主智能体(Wu et al., 2023)到蛋白质结构发现(Jumper et al., 2021)——该领域必须超越传统的搜索范式。我们在本文的最后将探讨这些挑战,并讨论它们对未来信息检索模型架构研究的影响。