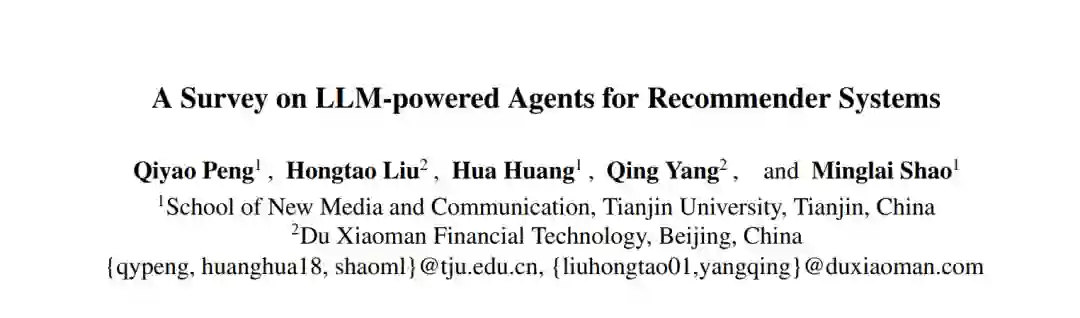

推荐系统是许多在线平台的核心组成部分,但传统方法在理解复杂用户偏好和提供可解释推荐方面仍然面临困难。大型语言模型(LLM)驱动的智能体的出现为此提供了一种有前景的方法,通过实现自然语言交互和可解释推理,可能会彻底改变推荐系统领域的研究。本文综述系统地回顾了LLM驱动的智能体在推荐系统中日益增长的应用。我们识别并分析了当前研究中的三种关键范式:(1)面向推荐的方式,利用智能体增强基础推荐机制;(2)面向交互的方式,通过自然对话和可解释建议促进动态用户参与;(3)面向仿真的方式,采用多智能体框架来模拟复杂的用户-物品交互和系统动态。除了范式分类之外,我们还分析了LLM驱动的推荐智能体的架构基础,研究其核心组成部分:个人资料构建、记忆管理、战略规划和行动执行。我们的研究还扩展到对该领域基准数据集和评估框架的全面分析。这一系统性研究不仅阐明了LLM驱动的推荐系统智能体的当前状态,还为该变革性领域中的关键挑战和有前景的研究方向提供了指引。

1 引言

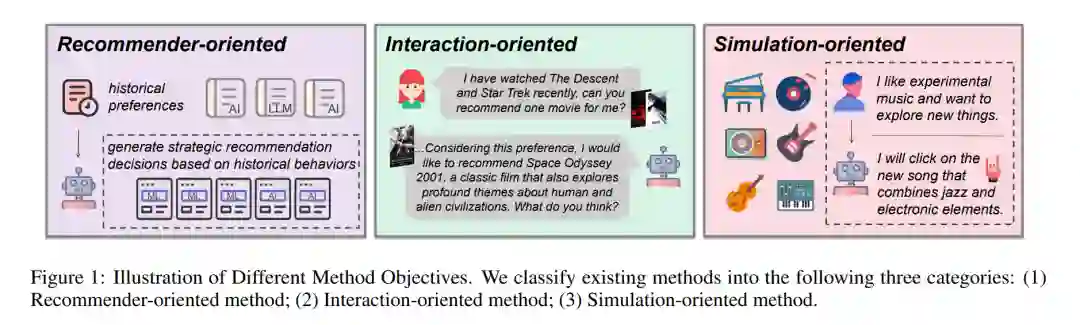

在信息爆炸的时代,推荐系统[Wu et al., 2022] 已成为数字平台中不可或缺的组成部分,帮助用户在电子商务、社交媒体和娱乐领域中浏览海量内容。尽管传统的推荐方法[He et al., 2017]通过分析用户偏好和历史行为,成功地提供了个性化建议,但在实际应用中仍面临诸多挑战,如对复杂用户意图的理解不足、交互能力有限以及无法提供可解释的推荐[Zhu et al., 2024b]。 近期,大型语言模型(LLM)的进展[Achiam et al., 2023]激发了越来越多的研究兴趣,旨在利用LLM驱动的智能体[Wang et al., 2024a]来解决推荐系统中的上述挑战。将LLM驱动的智能体融入推荐系统,相比传统方法,具有若干显著优势[Zhu et al., 2024b]。首先,LLM智能体能够理解复杂的用户偏好,并通过其精密的推理能力生成上下文推荐,从而使得决策过程更加细致,超越简单的特征匹配。其次,它们的自然语言交互能力促进了多轮对话,能够主动探索用户兴趣并提供可解释的解释,增强了推荐准确性和用户体验。第三,这些智能体通过生成更加真实的用户画像,结合情感状态和时间动态,彻底改变了用户行为模拟,从而提高了系统评估的有效性。此外,LLM的预训练知识和强大的泛化能力促进了跨领域的知识转移,能够以最少的额外训练应对冷启动等长期存在的挑战[Shu et al., 2024]。 在本综述中,我们全面回顾了LLM驱动的智能体在推荐系统中的应用。首先,我们介绍了传统推荐系统的背景,并讨论了它们在理解复杂用户意图、交互能力和可解释性方面的局限性。接着,我们系统地审视了LLM驱动的智能体如何通过三种主要范式解决这些挑战:面向推荐的(如[Wang et al., 2024b; Wang et al., 2024c])、面向交互的(如[Zeng et al., 2024; Friedman et al., 2023])和面向仿真的(如[Yoon et al., 2024; Guo et al., 2024])方法。然后,我们提出了一种统一的智能体架构,包含四个核心模块(个人资料[ Cai et al., 2024; Zhang et al., 2024c]、记忆[ Shi et al., 2024; Fang et al., 2024]、规划[ Wang et al., 2023b; Shi et al., 2024]、行动[ Zhu et al., 2024a; Zhao et al., 2024]),并分析了现有方法如何实现这些模块。进一步地,我们编制了现有基准数据集(包括Amazon系列、MovieLens、Steam等)和评估方法的全面比较,涵盖了传统推荐指标和新兴的评估方法。最后,我们探讨了该领域几个有前景的未来研究方向。

- 我们提出了一个系统的LLM驱动推荐智能体分类,识别出三种基本范式:面向推荐的、面向交互的和面向仿真的方法。这个分类框架为理解当前的研究提供了结构化的视角。

- 我们使用统一的架构框架分析LLM驱动的推荐智能体,将其分解为四个核心模块:个人资料构建、记忆管理、战略规划和行动执行。通过这一框架,我们系统地审视了现有方法如何集成和实现这些组件。

- 我们提供了现有方法、基准数据集和评估方法的全面比较分析,涵盖了传统推荐指标和专为LLM驱动推荐智能体设计的新兴评估方法。