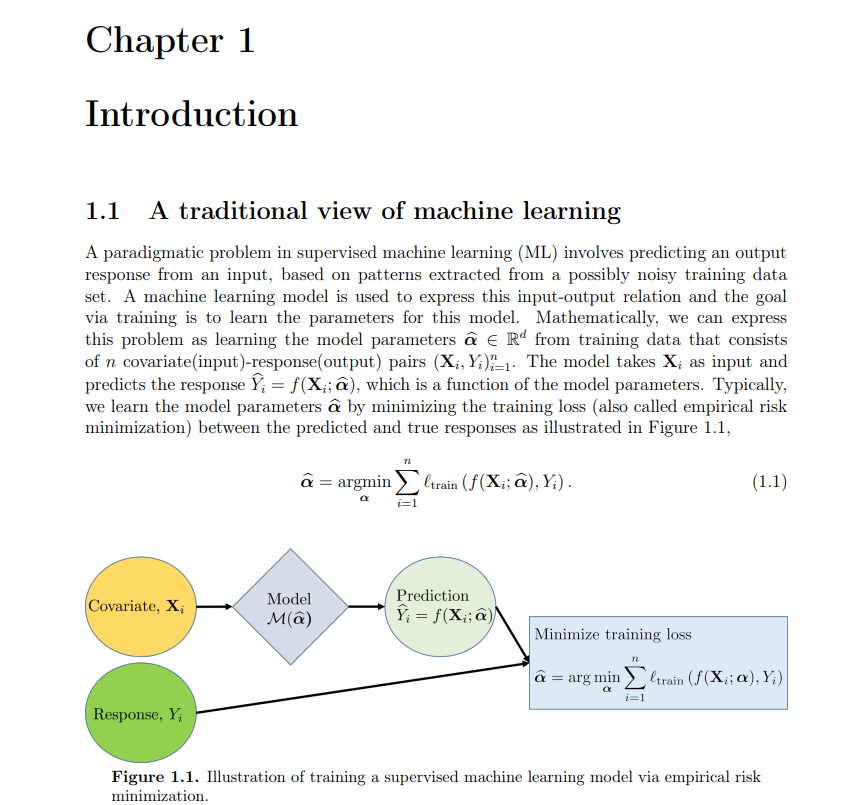

当代机器学习系统在各种任务上都取得了巨大的成功,包括图像分类、目标检测和跟踪以及推荐算法。这一成功是由计算能力的巨大进步推动的,它使我们能够利用大型训练数据集,具有大量的类和具有大量参数的训练模型。事实上,这些系统使用的模型具有足够的模型容量,可以在有噪声甚至完全随机的标签上训练到误差。然而,这些模型在实践中往往具有很好的泛化性,避免了有害的“过拟合”。良好泛化的关键在于模型体系结构和训练算法的隐性偏差,它们引导我们找到良好泛化的解决方案。本文通过分析过度参数化的线性模型,证明良好泛化的充要条件,从理论上更好地理解这一现象。此外,我们还实证研究了在训练模型来解决控制领域的实际问题时,是否可以利用我们关于问题领域的知识来设计正确的内隐偏差。

我们从分析过参数化线性回归的简单设置开始,当特征的数量超过训练点的数量时,对有噪声的数据拟合一个线性模型。通过采取傅立叶理论的角度,我们映射了由过度参数化带来的关键挑战,众所周知,由于欠采样导致真实信号混叠的现象。借用信号处理中的“信号出血”和“信号污染”的概念,我们为傅里叶特征设置导出了良好的泛化条件。

接下来,我们分析最小-ℓ2-范数插值器在高斯特征设定下的回归和二元分类问题的泛化误差。对于回归,我们插值实值标签,对于二元分类,我们插值二元标签。(事实证明,在充分的过参数化条件下,二值标签的最小范数插值与其他二值分类训练方法等价,如支持向量机或逻辑损失梯度下降法。)我们研究了一个渐近设置,其中特征的数量d与训练点的数量n成比例,且都是n, d→∞。在特征的双水平尖峰协方差模型下,证明了存在一种中间状态,在这种状态下,我们在分类任务上表现良好,但在相应的回归任务上表现不佳。然后,我们将分析扩展到多类分类设置,其中类的数量也与训练点的数量成比例,通过导出由一热编码标签的最小范数插值器引起的分类误差的渐近界。最后,为了理解我们如何学习在实践中很好地推广的模型,我们经验地研究了神经网络的应用,在硬控制问题中,最优解是未知的,线性解被证明是次优的非线性控制策略。通过智能设计神经网络架构和训练方法,利用我们对控制系统动力学的知识,我们能够更容易和鲁棒地学习性能良好的控制策略。