生成式人工智能工具,如大型语言模型(LLMs),提供了多种方法来提高效率,改进从需求生成和管理到设计分析和正式测试的系统工程流程。大型采购项目可能尤其适合利用大型语言模型来帮助管理复杂的系统和系统的采购。然而,生成式人工智能工具容易出现各种错误。

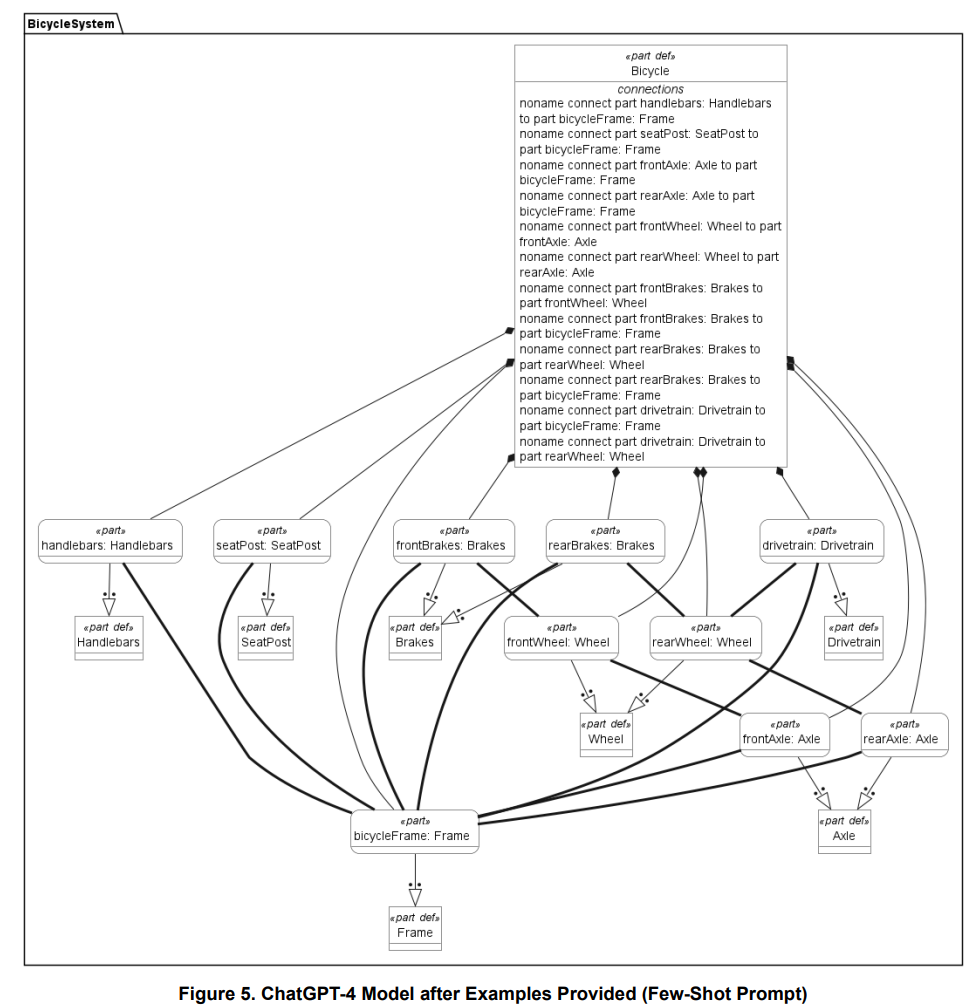

我们的研究探索了当前大型语言模型生成、修改和查询系统建模语言(SysML)v2 模型的能力。我们利用检索增强生成(RAG)等技术为大型语言模型添加特定领域的知识,提高模型的准确性。我们介绍了一个初步案例研究,在该案例研究中,生成模型的提示次数降到了最低。还讨论了大型语言模型的局限性以及未来与大型语言模型相关的系统工程研究。

基于模型的系统工程

国际系统工程理事会(INCOSE)将 MBSE 定义为 "正式应用建模来支持系统需求、设计、分析、验证和确认活动,从概念设计阶段开始,贯穿整个开发和后期生命周期阶段"(INCOSE,2007 年)。传统上,系统工程采用基于文档的方法。然而,随着系统和系统之系统的复杂性不断增加,需要 "捕获、分析、共享和管理与产品完整规范相关的信息"(Friedenthal 等人,2009 年)。在模型中捕获这些信息可以让多个利益相关者从各自的视角来看待系统,简化系统工程师和特定领域工程师之间的协作,通过设计和验证/确认活动来跟踪需求,并在解决方案开发过程中提供一种正式的方法来识别、分析和跟踪系统变化/缺陷(Carroll & Malins,2016)。

系统建模语言(SysML)

为实施 MBSE 方法,2006 年开发并采用了系统建模语言(SysML)v1.0 版,2007 年由对象管理集团(OMG)正式发布。SysML v1.6 于 2019 年正式发布,是 SysML v1.x 标准的最新版本。SysML v1.x是统一建模语言(UML)2标准的扩展,包含UML 2的部分(但不是全部)元素和一些新的SysML特定元素(OMG,n.d.)。SysML v1.x 是一种图形语言,由九种图表类型组成,其中每种图表都代表了底层模型元素的一种视图。

提高大型语言模型的响应速度

大型语言模型的好坏取决于它们所训练的数据集。为了改进对特定领域请求的响应,通常需要通过以下方法之一为模型提供额外的背景:

-

RAG 利用外部数据来增强大型语言模型的知识,而不改变基础大型语言模型的参数(权重;Nucci,2024 年)。对于经常产生新知识的领域,或者当信息属于专有/私有信息,用户不希望将其作为大型语言模型训练集的永久组成部分时,RAG 尤其有用(Nucci,2024 年)。

-

微调通过传授大型语言模型的专业知识,对其内部参数进行微调(Nucci,2024 年)。Nucci 强调,只需调整少量参数,就能大大节省微调时间,而无需重新训练整个模型。

-

快速工程

-

零镜头提示是要求大型语言模型在第一次尝试时就正确执行任务,即使该模型尚未针对特定任务接受过直接训练(Oleszak,2024 年)。它们通常用于只需要一般知识的简单任务,或者当特定领域的知识已包含在训练集中或通过 RAG 或微调提供时。

-

对于需要多步骤推理的更复杂任务,或者大型语言模型不了解特定领域知识时,可使用少量提示通过实例来教授大型语言模型(Oleszak,2024 年)。通过提供代码语法示例,少量提示学习可用于正确格式化代码。

-

还可以将上述方法结合起来。OpenAI 允许用户创建自定义 GPT,在其中可以提供具体的说明,并提供一个上传包含特定领域知识的文件的区域(OpenAI,2023)。这种将 RAG 与提示工程相结合的方法可使用户减少完成复杂任务所需的提示次数,而这些任务模型并未经过专门训练。