在现实中,数据往往与多个标签相关联,这使得多标签学习(Multi-Label Learning, MLL)成为一个突出的研究课题。过去的二十年见证了MLL的成功,这离不开完整和准确的监督信息。然而,在实践中获得这些信息总是费力的,有时甚至是不可能的。为了规避这一困境,不完整多标签学习(Incomplete Multi-Label Learning, InMLL)应运而生,旨在从不完整标记的数据中学习。迄今为止,大量的InMLL研究工作已被提出,以缩小与完整MLL的性能差距,然而,针对InMLL的系统性综述仍然缺乏。在本文中,我们不仅尝试填补这一空白,还努力为创新研究铺平道路。具体而言,我们回顾了InMLL的起源,分析了InMLL的挑战,并分别从数据导向和算法导向的角度对InMLL进行了分类。此外,我们还展示了InMLL在各个领域的实际应用。更重要的是,我们强调了几个潜在的未来趋势,包括四个更符合实际的开放问题和三个在解决InMLL挑战方面尚未充分探索或未探索的技术,这可能为InMLL领域的研究提供新的思路。

多对象的共现特性或单个对象的层次结构特性使现实世界以多标签形式展现。例如,对于前者,一张图像可能同时包含山、树、太阳和云的对象;一篇文档可能同时涵盖人工智能、机器学习和深度学习的主题。对于后者,一件衣服可能被标记为男士、上衣和T恤;一棵苹果树可以同时属于植物、被子植物和家苹果属的分类。将多个相关标签分配给相应样本引发了多标签学习(Multi-Label Learning, MLL)的出现。过去的二十年见证了其在各种应用中的成功,包括图像分类、文本分类、视频分析和医学科学等。 MLL的成功离不开完整和准确的监督信息。然而,获得这些信息不仅耗时且费力,在实践中由于固有的复杂性和有限的知识,有时甚至是不可能的。为缓解这一困境,不完整多标签学习(Incomplete Multi-Label Learning, InMLL)应运而生,其中只需为数据集提供部分标签,目标是从不完整或缺失的标签数据中学习。图1描绘了不完整多标签数据的示意图。

不完整多标签学习的出现主要有两个原因。首先,数据集本身的低质量可能导致不完整性。例如,在图像中,不足的照明或低分辨率可能使一些模糊或微小的目标无法辨别;在音频中,嘈杂的背景声音与多个目标声音的交织可能相互干扰,难以区分。其次,标注者的有限知识也会产生不完整的标签数据。例如,缺乏专业医学知识的标注者在医学图像标注中容易出现遗漏或误标问题,因为他们的知识与被标注的数据集不匹配。 需要注意的是,获得不完整标签的数据相对简单且可行,符合环保和节约资源的需求。因此,许多研究人员致力于InMLL,旨在降低标注成本的同时实现令人满意的性能。

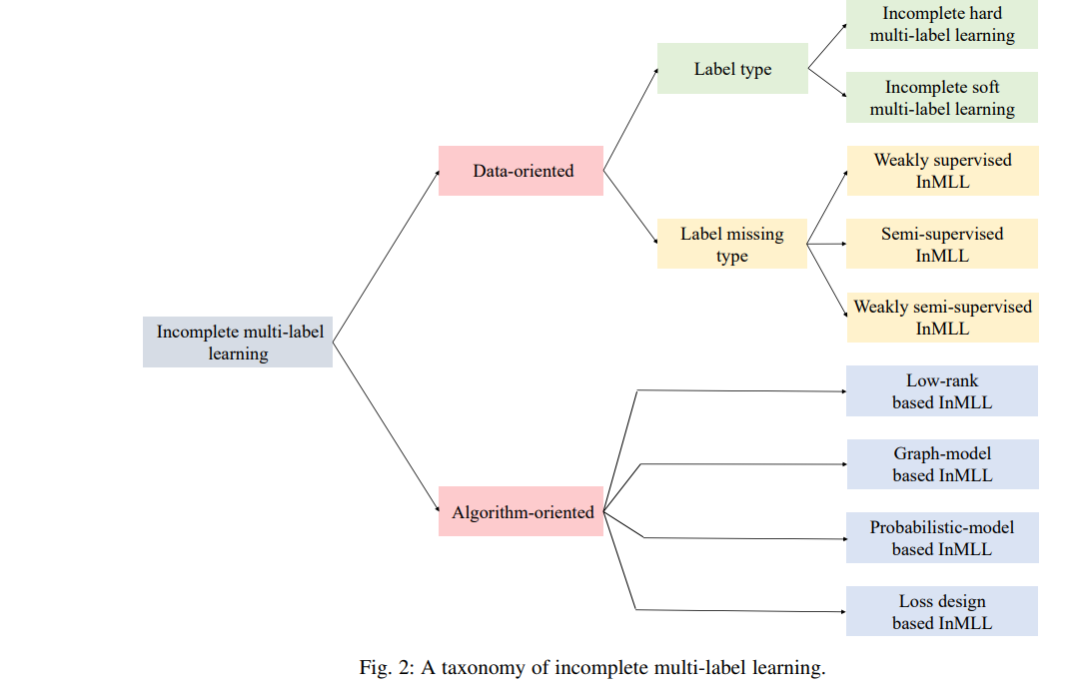

InMLL的起源可以追溯到2006年,当时的开创性工作研究了半监督MLL。随后,在2010年,文献提出了第一个弱监督MLL的工作。这种学习范式的吸引力在于其显著降低标注成本的能力,提高了其适用性,从而在过去几年吸引了大量关注和广泛研究。认识到由于监督信息不足,InMLL的性能通常不如完整MLL,许多InMLL的研究工作提出了缩小这两种范式之间性能差距的方法。尽管这些工作取得了一定的进展,但仍缺乏系统总结当前进展和确定未解决挑战的综述。即使是最新的MLL综述也仅将InMLL视为一个开放的挑战,忽视了过去十年这一领域的进展。因此,InMLL领域迫切需要一篇综合性的综述。本文通过全面回顾现有方法并分析其优缺点,我们不仅尝试填补这一空白,还努力为创新研究铺平道路。具体而言,我们在第二节中给出了InMLL的正式定义。此外,我们在第三节列出了InMLL的六个挑战。随后,我们在第四节从数据导向和算法导向的角度对InMLL进行了分类。此外,我们在第五节展示了InMLL的几个实际应用。最后,在第六节中,我们从问题设定和技术路线的角度分别指出了四个和三个潜在的未来方向。