人工智能(AI)和统计机器学习(ML)与复杂系统的集成,给传统的测试与评估(T&E)实践带来了各种挑战。随着更多不同级别的决策由人工智能系统(AIES)处理,我们需要测试与评估流程为确保系统的有效性、适用性和生存性奠定基础。这涉及到评估 ML 模型和人工智能算法组件的方法,包括展示它们如何产生可重复和可解释的决策的能力,以及对任何故障模式和故障缓解技术的了解。此外,还需要人工智能保证,以证明人工智能算法按预期运行,不存在因设计缺陷或恶意插入数据或算法代码而产生的漏洞。T&E 需要新的流程来鉴定 ML 模型的训练数据是否充足、算法和模型性能、系统性能以及运行能力。弗里曼(Freeman,2020 年)概述了当前复杂软件支持系统的测试与评价方法所面临的挑战、嵌入式人工智能所加剧的关键挑战,以及针对 AIES 的测试与评价需要如何改变的 10 个主题[1]。

为了充分测试 AIES,测试与评估界需要应对以下挑战:

- 当状态空间的大小导致测试所有情况不可行,或开放世界问题导致无法枚举所有情况时,确定测试要求;

- 解决这些突发系统可以分解这一可能无效的假设;以及

- 处理动态变化的系统,这些系统在部署过程中可能永远不会处于 "最终 "状态[1]。

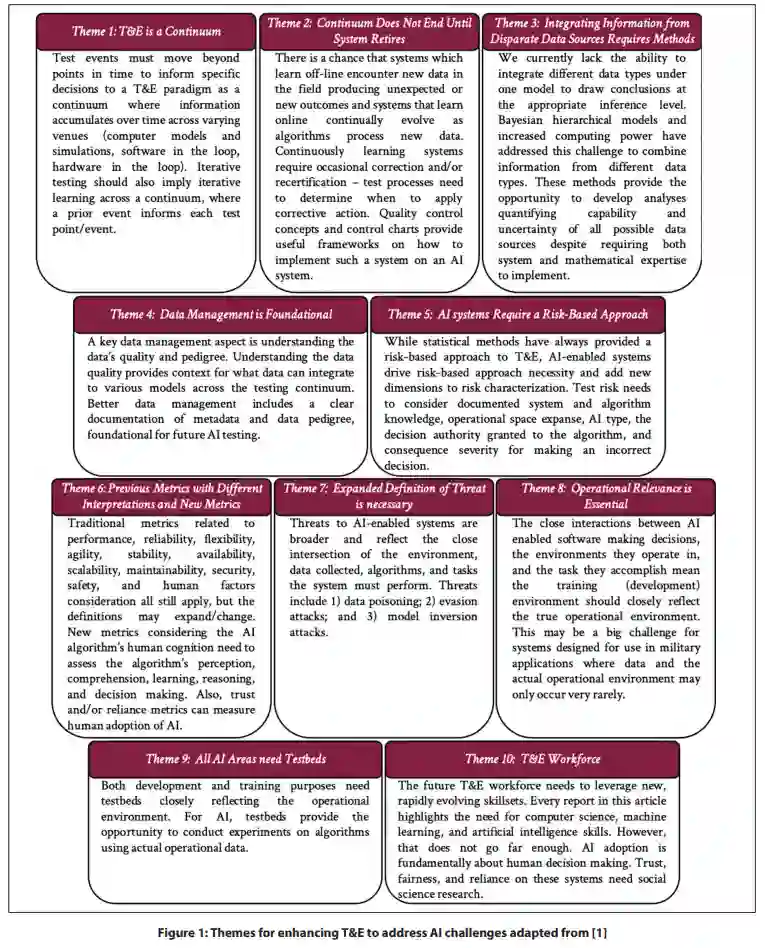

图 1 总结了加强测试与评估的 10 个不同主题,以应对充分测试和评估 AIES 所面临的挑战。在过去的一年中,弗吉尼亚理工大学致力于测试和评估各种 AIES。本最佳实践指南对图 1 中的主题进行了进一步的完善和补充。本文所包含的最佳实践将这些主题转化为可执行的测试与评估实践。在编写本指南的过程中,我们充分利用了我们在人工智能系统开发和与更广泛的人工智能社区合作方面的 T&E 工作经验。这里所包含的最佳实践反映了我们为使人工智能系统的测试与评估具有可操作性所做的初步尝试。这些实践需要在各种人工智能系统中进行测试,以确保它们是真正的最佳实践。贯穿许多最佳实践的一个亮点是数据的重要作用。数据不再仅仅是 T&E 的产物。现在,它已成为人工智能系统开发本身的输入。这一显著变化推动了对人工智能系统的技术与评估提出新的要求和实践。此外,这份清单还远远不够完整,应被视为一份活生生的实践文档。随着越来越多的人工智能系统可供测试,新的实践将不断发展,本清单也需要不断更新。不过,本文件中的每种做法都已证明在美国防部 AIES 测试中非常有用。