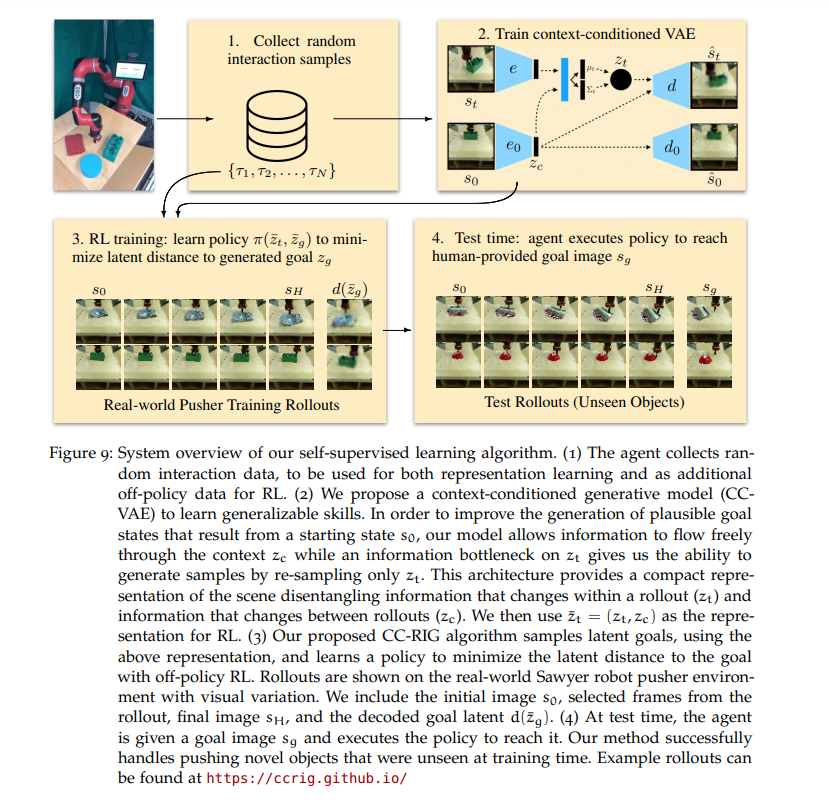

对于机器人来说,要在现实世界的非结构化环境中执行任务,他们必须能够以一般的方式被赋予一个期望的目标,并且在机器人还不知道如何完成的情况下,学会快速地执行期望的任务。在这篇论文中,我们探索了深度强化学习作为一种解决方案,通过两个主要主题来实现可扩展的基于学习的真实世界机器人的愿景:从先验数据加速强化学习和自监督RL。从先验数据或先验知识加速RL对于使强化学习算法具有足够的样本效率来直接运行在现实世界中是非常重要的。我们讨论了利用人类演示来加速强化学习,使用人类设计的剩余控制器与工业插入任务的强化学习相结合,以及离线强化学习的算法,也可以受益于少量的在线微调。同时,虽然强化学习算法的样本效率是一个备受赞赏的问题,但围绕可以从丰富的观察(如图像)中学习的智能体产生了额外的问题:特别是奖励监督和自主收集数据。我们通过一个生成模型来讨论自监督的RL,通过目标达成,让智能体评估他们自己在达成目标方面的成功,并自主提出和练习技能。在最后一部分,我们考虑将线下政策学习与自我监督练习相结合,让机器人在新的环境中练习和完善技能。这些指示使机器人能够监督自己的数据收集,从交互中学习复杂和一般的操作技能。

机器人在制造业和其他行业变得无处不在,用于各种任务,如拣货、组装、焊接、油漆等。然而,现代机器人系统的自主能力仍然相当有限。机器人操作的设置被仔细控制;它们通常需要非常具体的末端执行器工具(Zhongkui Wang et al., 2020)结合高精度运动和运动规划(Ang et al., 2005;LaValle, 2006; Karaman and Frazzoli, 2011; Zucker et al., 2013)来完成一项特定的任务。实际上,机器人依靠人类的智慧和工程学来完成他们的工作。但是这样的系统是脆弱的,并且硬件和软件必须经常为任务的微小变化而重新设计。柔性机器人控制器可以实现一定的适应性或自主性(Mason, 1981;Hogan, 1985),以及与抽象任务规划(Sacerdoti, 1974;莱斯利·帕克·凯尔布林(Sacerdoti, 1974; Leslie Pack Kaelbling and Lozano-Perez, 2011)结合了感知。但是,如果一项制造任务实际上需要对基于感知输入的各种环境条件具有显著的适应性或稳健性,那么设计一个工作系统就会变得困难得多——这一点从今天数百万从事这些工作的人类劳动者身上就可以看出。除了相对可控的制造环境之外,我们还希望未来的机器人能做更多的事情:做饭、帮助家中的老人和其他以人类为中心的环境、导航未绘制的地形、操作机械和电器、操作物体,以及在人类在场时安全互动。这种开放世界的能力需要适应性、通用性,这是当今大多数机器人所无法企及的。

相比之下,人类可以如此轻松地进行高度熟练的灵巧操作,以至于有时很难想象在机器人身上复制这种能力的难度。大多数人在生命的前五年内已经发展出复杂的精细运动技能,成功地对各种不熟悉的动态物体进行双手灵巧操作,并使用带有紧密感觉运动回路的工具,其中包括感知、功能性抓取和控制(Adolph和franak, 2017)。为机器人开发同样鲁棒的反馈控制器仍然是一个挑战,它可以适应各种各样的情况来完成目标。如果机器人也有同样的技术,那么它将具有难以置信的经济价值——它们可以用来自动化许多人类今天必须做的任务。我们怎样才能开发出具有类似技术的通用机器人呢?

过去十年的深度学习表明,从大型数据集学习模型是这种开放世界泛化的关键,这是通用机器人的先决条件。在广泛的数据集上训练的表达函数逼近推动了一系列领域的人工智能研究的最新进展:在语音识别(Graves等人,2014年)、图像分类(Krizhevsky等人,2012年)和分割(Ren等人,2015年)、自然语言处理(Devlin等人,2019年),甚至蛋白质结构预测(Jumper等人,2021年)等领域,结合适当的深度学习架构的大数据集recipe已经推动了前沿领域的发展。这些模型是在足够广泛的数据集上训练的,因此模型可以从广泛的训练分布中一般化,并在测试时捕获拐角用例,这对于手动设计的解决方案来说是一个挑战。如果我们能够实现控制的普遍性——选择行动以最大化奖励函数的问题——它就能够在野外实现真正的通用机器人。但是控制引入了监督学习中没有的两个新问题。第一个问题是信用分配:过去采取的行动会影响未来。第二是探索:所采取的行动改变了访问数据的分布。为了解决这些问题,深度强化学习(RL)是一种很有前途的方法,它将强化学习与深度函数逼近相结合。深度强化学习已成功应用于许多连续决策问题:在竞争游戏如雅达利(Mnih等人,2015),围棋(D. Silver等人,2016a), Dota 2 (OpenAI等人,2019)和星际争霸II (Vinyals等人,2019),机器人(MMarc Peter Deisenroth and Rasmussen, 2011; Kober et al., 2013; Levine et al., 2017; J. ; Lee et al., 2020),平流层气球导航Marc G. belleare等人,2020,甚至控制核聚变反应堆中的等离子体,Degrave等人,2022。然而,虽然RL的算法一直在稳步发展(Schulman et al., 2015; Lillicrap et al., 2016; Schulman et al., 2017; Haarnoja et al., 2018a),变得更高效和稳定的样本,仍然有重大的障碍,以RL机器人的通用解决方案。在赋予机器人人类水平的操作技能方面还存在哪些挑战?