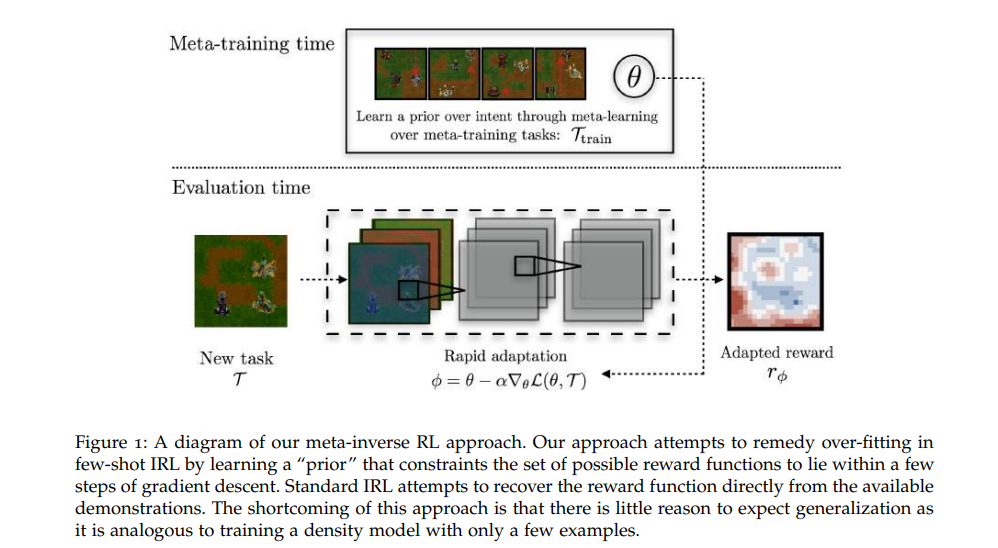

近年来,人工学习系统在计算机视觉、自然语言处理和语音识别等许多具有挑战性的领域取得了巨大的进展。这些最新进展的一个显著特点是,将灵活的深度函数逼近器与为特定问题收集的大型数据集结合起来,这似乎是一个简单的公式。然而,这些系统在泛化新输入以获取新功能时,很难利用其学习能力,通常需要在类似的大型数据集上从头开始重新训练。这与人类形成了鲜明的对比,人类有一种非凡的能力,可以在之前的经验基础上,从少数几个例子中学习新概念。在本论文的第一部分,我们将研究如何构建系统来模拟这种快速适应新任务的能力。本文这一部分的核心原则之一是,利用大量以前的经验/任务中的结构来实现快速适应和不确定性。首先,我们将研究奖励规范的设置,这是强化学习中的一个常见挑战,接下来,我们将研究元学习设置的概率框架如何能够在不确定性下进行推理。

在本文的第二部分中,鉴于先前的任务数据集在加速学习方面发挥的潜在作用,我们将提出一个自然的问题:如何让智能体完全自主地收集数据。这将消除人类为人工智能“管理”任务数据集的需要,并实现完全可扩展的、永无止境的具身学习。我们所采取的方法的中心主题将是考虑智能体必须解决的在线现实世界“任务”的本质,并通过它重新审视偶发性RL的基本假设。最后,我们将在现实世界灵巧操作领域展示这些想法,并为今后在这种更“自主”的强化学习设置方面的工作提供一些提示。

成为VIP会员查看完整内容

相关内容

加州大学伯克利分校(University of California, Berkeley),是美国最负盛名且是最顶尖的一所公立研究型大学,位于旧金山东湾伯克利市的山丘上。创建于1868年,是加州大学十个分校中历史最悠久的一所。加州大学伯克利分校在世界范围内拥有崇高的学术声誉,拥有丰富的教学资源,研究水平非常坚厚,与斯坦福大学、麻省理工学院等一同被誉为美国工程科技界的学术领袖。

Arxiv

0+阅读 · 2022年10月17日

Arxiv

0+阅读 · 2022年10月17日

Arxiv

0+阅读 · 2022年10月17日

Arxiv

0+阅读 · 2022年10月14日

Arxiv

0+阅读 · 2022年10月13日