微型机器学习(TinyML)领域由于其在资源受限设备上实现智能应用的潜力而获得了显著关注。这篇综述提供了对高效神经网络的进步及在超低功耗微控制器(MCUs)上部署深度学习模型进行TinyML应用的深入分析。它首先介绍了神经网络及其架构和资源需求,并探讨了在超低功耗MCUs上基于微机电系统(MEMS)的应用,强调了它们在资源受限设备上实现TinyML的潜力。综述的核心是针对TinyML的高效神经网络。它涵盖了诸如模型压缩、量化和低秩因子分解等技术,这些技术优化了神经网络架构,以便在MCUs上最小化资源利用。然后,论文深入探讨了在超低功耗MCUs上部署深度学习模型,解决了有限的计算能力和内存资源等挑战。模型修剪、硬件加速和算法-架构协同设计等技术作为实现高效部署的策略被讨论。最后,综述提供了该领域当前局限性的概览,包括模型复杂性与资源限制之间的权衡。总体而言,这篇综述文章对高效神经网络及在超低功耗MCUs上的TinyML部署策略进行了全面分析。它确定了未来研究方向,以解锁在资源受限设备上TinyML应用的全部潜力。

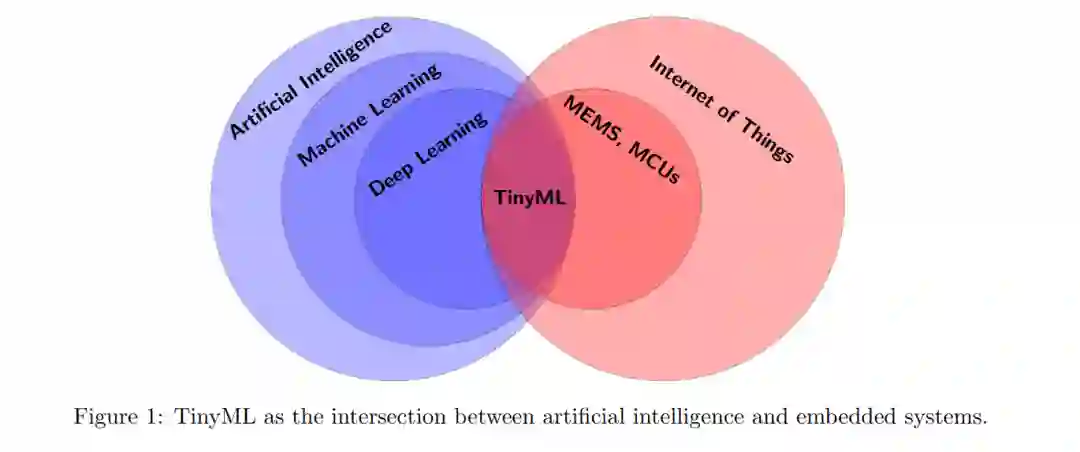

在过去的十年里,人工智能(AI)已经彻底改变了我们的日常生活体验和技术进步,使机器能够执行传统上需要类似人类智能的任务,如识别物体或语音或玩高级游戏如围棋。 机器学习(ML)是最突出的AI方法,它训练计算机通过数据学习模式和表征,而无需显式编程。深度学习(DL)是机器学习的一个高级子集,受大脑组织的启发,使用人工神经网络(NNs)来模拟和解决各种领域的复杂问题,包括语言处理、蛋白质生成或自动化。

传感器和微控制器。与此同时,物联网(IoT)的采用和发展也有所增加,为我们的日常生活带来了新的设备和应用。微电机械系统(MEMS)和微控制器单元(MCUs)是IoT的重要硬件组件,它们使硬件设备能够直接在其本地环境中收集和处理信息(运动、声音、温度、压力等),无需额外资源或外部通信。本地和自主的数据处理优化了信息流,但本质上带来了功率限制。某些应用还需要连续数据处理,这给功率带来了额外的限制。MEMS和MCUs作为模拟和数字世界之间感知信息的接口。这些设备应用范围广泛,包括手机、汽车、可穿戴设备、环境监控和医疗保健系统。它们的消费市场规模达到每年数十亿的销售额,因此功率限制的微小偏差可能导致巨大成本。

TinyML。机器学习和IoT的融合在研究和工业界引起了重大关注,因为它使嵌入式硬件能够处理本地数据,并以自动和智能的方式与环境互动。这一交汇点导致了TinyML这一新兴领域的诞生,该术语首次由Han和Siebert在2019年提出(见图1)。TinyML专注于为低功耗、资源受限设备开发高效的神经网络模型和部署技术。TinyML应用的一些例子包括检测或计数事件、手势识别、预测性维护或关键词识别,这些通常在家用电器、遥控设备、智能手机、智能手表或增强现实眼镜中找到。

然而,深度学习的指数增长与强大硬件的发展密切相关,如图形处理单元(GPUs),能够支持其大量计算需求。因此,深度学习尚未在低功耗设备上实现相同的增长和支持,如微控制器,以使深度学习能够在边缘运行。事实上,深度学习的能耗印记以及嵌入式设备的广阔领域,为研究人员和工业界带来了新的挑战,但也带来了令人兴奋的机遇。

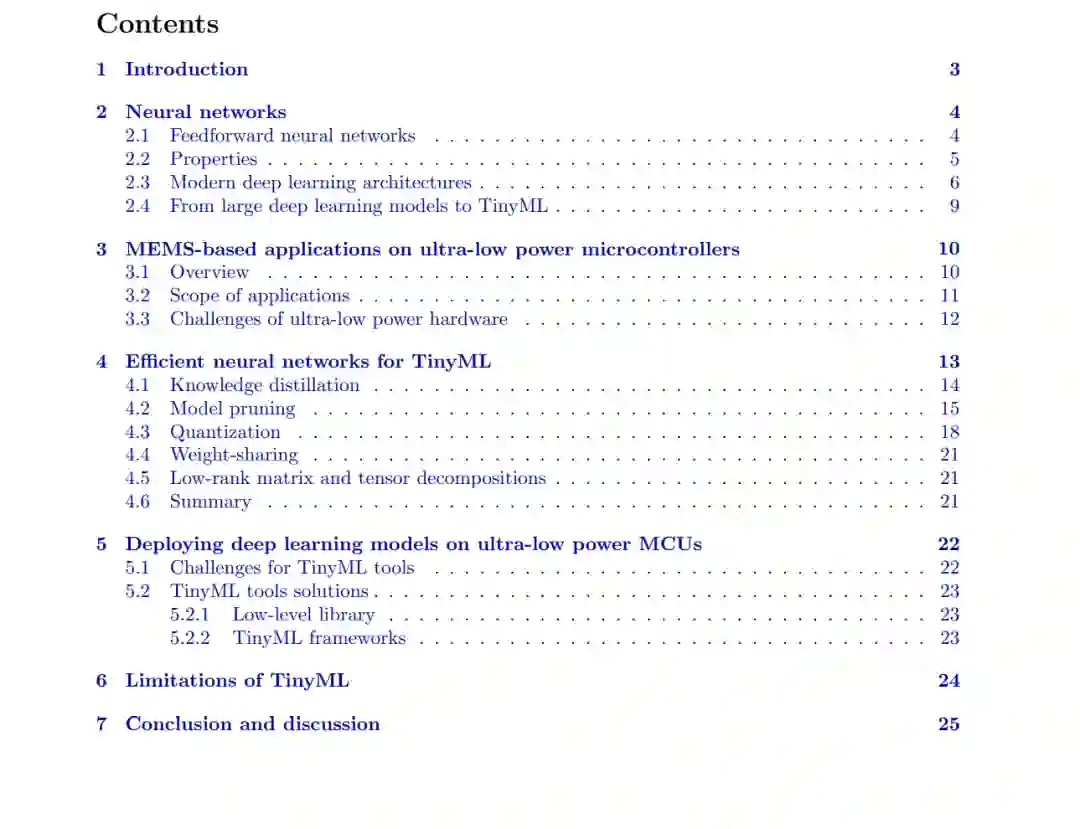

概述。综述从第2节对神经网络的一般介绍开始,概述了它们的基本原理和架构。它探讨了神经网络及其在各个领域的应用的演变,强调了它们的计算需求和对资源有限设备所带来的挑战。 然后,第3节提供了在超低功耗微控制器单元(MCUs)上基于MEMS的应用的全面概述。它讨论了微电机械系统(MEMS)技术的进步及其与MCUs的集成,使得开发高效的感测和执行系统成为可能。强调了基于MEMS的应用在使资源受限设备上实现TinyML的潜力。

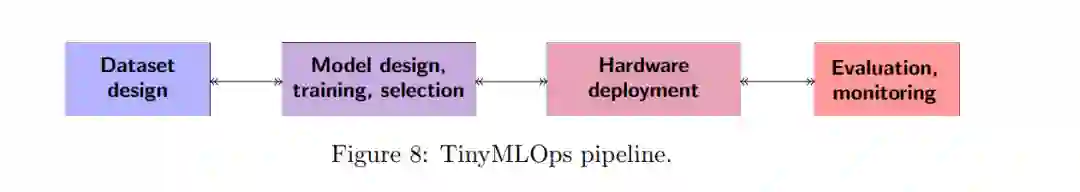

综述的核心,第4节,聚焦于TinyML的高效神经网络。这一节检查了旨在优化神经网络架构并减少其计算和内存需求的各种技术和方法。它探讨了模型压缩、量化和低秩因子分解技术等,展示了它们在实现MCUs上的高性能推理的同时保持最小资源利用的有效性。 在讨论高效神经网络之后,第5节深入探讨了在超低功耗MCUs上部署深度学习模型。它调查了将复杂模型移植到计算能力和内存资源有限的MCUs上的挑战。该部分探讨了模型修剪、硬件加速和算法与架构共同设计等技术,阐明了为TinyML应用高效部署深度学习模型的策略。 第6节提出了TinyML领域当前的局限性概述。这一部分讨论了研究人员和从业者面临的挑战,包括模型复杂性和资源限制之间的权衡、针对TinyML的基准数据集和评估指标的需求,以及为TinyML工作负载优化的新硬件架构的探索。 最后,第7节总结并提供了开放的挑战以及对可能影响TinyML领域的新兴趋势和技术的洞见。 总的来说,这篇综述文章提供了对超低功耗MCUs上TinyML的高效神经网络和部署策略的全面分析。它突出了该领域的当前状态,并确定了解锁资源受限设备上TinyML应用全部潜力所需的未来研究方向。

本章介绍了设计和训练高效TinyML模型的关键方法,以及它们相关的理论概念和实际意义。这些方法已经引起了越来越多的兴趣,因为它们弥合了深度学习理论与高效神经网络部署之间的差距。 具体来说,模型修剪、知识蒸馏和量化已经展示了非常有前景的压缩比率,尤其是在更大规模的网络(移动或云大小)中,这些网络对模型调整更为鲁棒。此外,一些模型压缩方法也是正则化的形式,甚至可以帮助模型更好地泛化。因此,这些方法显示出满足超低功耗MCUs要求的高潜力。 实际上,由于TinyML处于初期阶段,工具和流程尚未成熟,还不足以评估和真正利用现有方法对超低功耗MCUs的高压缩率,因此我们将在下一节回顾TinyML的实用工具和压缩神经网络部署的各个方面。

总结

在第2节中,我们介绍了神经网络的现状,并阐述了我们对它们在应用中的兴趣,然后我们概述了基于MEMS的应用,强调了我们极低功耗限制的机会和挑战,这增强了对TinyML研究努力的需求。在第3节中。接着在第4节,我们介绍了在超低功耗MCUs上设计高效神经网络的现有方法,并在第5节提供了部署神经网络以实现TinyML应用的现有工具的概览。最后,我们在第6节中审视了TinyML领域的当前局限性。

开放性挑战。TinyML面临许多开放性挑战。确保TinyML模型对抗性攻击的鲁棒性仍是一个重大挑战。对抗性攻击可以操纵输入数据误导模型,给关键应用带来安全风险。需要研究开发能够抵御各种形式对抗性攻击的鲁棒TinyML模型。这包括探索对抗性训练、输入扰动防御技术,以及理解模型复杂性和鲁棒性之间的权衡。此外,许多TinyML应用中的边缘设备在动态环境中运行,资源可用性波动。动态管理功率、内存和带宽等资源以适应变化条件是一个复杂的挑战。未来将需要对TinyML模型的自适应资源管理策略进行进一步的调查,考虑资源可用性的实时变化。这包括探索动态模型适应、即时优化和资源感知调度技术,以确保在不同条件下的最优性能。解决这些挑战不仅会增强TinyML模型的鲁棒性和适应性,还将有助于更广泛的领域发展。

新兴趋势和技术。未来几年,几种趋势和技术可能影响TinyML领域。边缘AI和边缘计算:TinyML与边缘计算的集成是一个显著趋势,使得机器学习模型的处理更接近数据源。这种方法降低了延迟,解决了带宽限制,并为资源受限的边缘设备优化了TinyML模型。量子计算:量子计算有潜力彻底改变TinyML领域,加速模型训练和优化过程。随着量子计算技术的成熟,研究人员可能探索其应用以提高TinyML模型的效率和性能。定制硬件加速器:为边缘设备上高效执行TinyML模型而设计的定制硬件加速器的发展是一个关键趋势。专门的硬件架构旨在提高性能和能源效率,有助于在多样化应用中广泛部署TinyML。

这些趋势共同标志着向更高效、去中心化和专业化的计算方法的转变,为在边缘的资源受限设备上部署和优化TinyML模型的进步铺平了道路。它们暗示了TinyML未来的动态景观,硬件、通信和算法方法的创新将有助于这一领域的持续发展。TinyML的研究人员和从业者应该了解这些趋势,以利用它们的潜在优势并应对新的挑战。