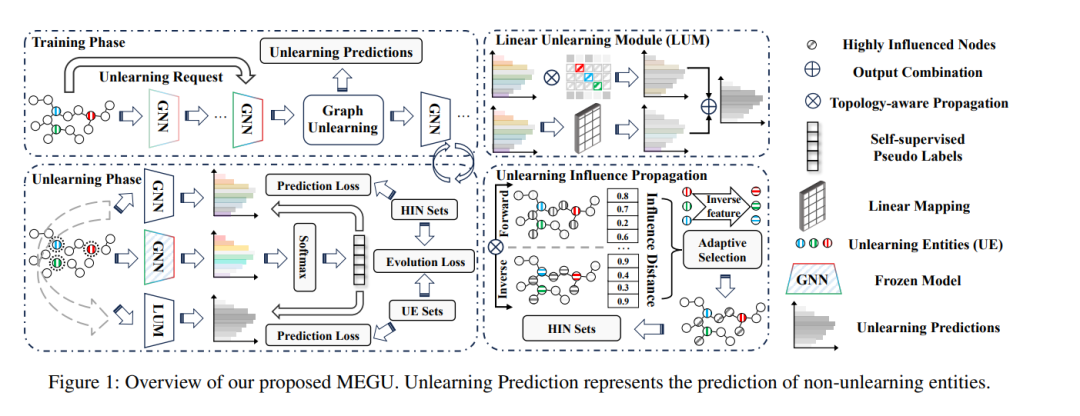

随着人工智能应用的迅速发展,对数据隐私和模型鲁棒性的日益需求突显了机器取消学习的重要性,特别是在充满活力的基于图的情景中。然而,大多数现有的图取消学习策略主要依赖于精心设计的架构或手动过程,使它们不太用户友好,同时在部署效率方面面临挑战。此外,在取消学习性能和框架通用性之间取得平衡也是一个重要关注点。为了解决上述问题,我们提出了一种新的相互演化图取消学习(MEGU)方法,它是一种同时演化图取消学习的预测和学习能力的新范式。通过结合上述两个组件,MEGU 确保在一个统一的训练框架中进行互补优化,以满足预测和取消学习的需求。在9个图形基准数据集上进行的大量实验表明,MEGU 在解决特征、节点和边级别的取消学习任务方面表现出卓越性能。具体而言,与最先进的基线方法相比,MEGU 在这三个取消学习任务的平均性能改善分别为2.7%、2.5%和3.2%。此外,MEGU 表现出令人满意的训练效率,将时间和空间开销平均分别降低了159.8倍和9.6倍,与从头开始重新训练的 GNN 相比。

成为VIP会员查看完整内容

相关内容

Arxiv

42+阅读 · 2023年4月19日

Arxiv

223+阅读 · 2023年4月7日

Arxiv

86+阅读 · 2023年4月4日

Arxiv

85+阅读 · 2023年3月21日