虽然海量的现实需求为人工智能提供了广阔的应用场景,但要求人工智能系统适应复杂的计算环境.然 而,传统人工智能算法的研究都假设其应用环境是安全可控的.大量研究和实践工作表明当前的人工智能技术普 遍对外在风险考虑不足,相关数据和模型算法存在隐私与安全风险.由于人工智能安全的现实需求以及图学习的 巨大影响,图学习的隐私与安全问题成为当前图学习领域面临的重要挑战.为此,研究人员近年来从图学习系统的 各个环节出发对图学习隐私与安全问题进行了研究,提出了相关的攻击和防御方法.本综述首先阐述研究图学习 隐私与安全的重要意义,然后介绍图学习系统的基本过程、图学习面临的主要隐私与安全威胁以及图学习的隐私 与安全特性;在上述基础上,分别从图数据隐私、图数据安全、图模型隐私和图模型安全四个方面对现有研究工作 进行系统的归纳总结,讨论主要成果和不足;最后,介绍相关的开放资源,并从数据特征、解释性、研究体系和实际 应用等方面探讨面临的挑战和未来的研究方向.1. 引言通过观察从各个领域的复杂系统中收集到的数 据资源可以发现,数据内部或数据之间往往存在潜 在的关联关系,分析和挖掘这些关联关系可以帮助 人们发现对象之间的依赖程度、理解群体的行为模 式以及揭示系统的组织结构.近年来,大量研究实践 表明图是建模这些不同来源、不同性质数据的强大 工具,它可以通过对象集合以及它们之间的关系非 常自然地对数据中的关联对象进行抽象表示[13] .例 如,在信号处理领域,可以利用图对时序数据进行表 示,从而基于图挖掘实现信号的分类和异常检测[4];在互联网领域,基于图可以表达用户与用户、用户与 商品的关系,从而通过图挖掘实现个性化推荐、风险 控制以及欺诈检测[5];在知识服务领域,基于图构建知识图谱可以描述知识和建模世界万物之间的关联 关系,从而利用图算法进行知识推理、提供自动问答 等智能服务[6];在计算机视觉领域,通过属性关系图 可以表示图像中局部视觉特征以及它们之间的空间 关系,从而基于图挖掘来实现对视觉数据的学习[7] . 因此,图刻画着对象之间的复杂关联关系、形成了海 量的图数据,并通过异常检测、信息推送、智能导购、 征信分析等服务深刻改变着人们的工作和生活.

1.1 图学习隐私与安全

面对图数据资源开发利用的现实需求,数据的 开放共享成为数据产业发展的重要基础.然而,图数 据中往往存在不愿意被公开的敏感信息,直接开放 共享会增加敏感信息的泄露风险.例如,在社交网络 领域,服务提供商在为用户提供个性化信息推送服 务的同时,可能基于图挖掘推理用户的生活习惯、政 治偏好等[89];在电子商务领域,电商平台在为用户 准确推荐商品的同时,可能通过图挖掘推理用户的 收入水平、人口属性等[10];在城市交通领域,地图应 用提供商在提供位置服务的同时可以通过图挖掘轻 易获取个人的居住和工作地点[11-12] .为了推动数据 的开放共享,传统研究领域提出了k匿名、l多样性、t贴近性(等数据隐私保 护技术.然而,与传统关系型数据相比,图数据 存在内部关联性,并且其中的任何关于节点、链路、 子图的信息都可以被恶意攻击者用作背景知识,极 大地增加了图数据的隐私泄露风险,从而以上 传统隐私保护方法难以应对图数据开放共享面临的挑战.面对图数据的建模学习需求,研究领域已经提 出了各种图模型算法.例如,为了根据拓扑结构进行 图数据的分析计算,网页排名(PageRank)、标记传 播(LabelPropagation)、随机行走(Random Walk) 等融合传播和迭代更新机制的图模型被提出 . 为了对图数据进行建模推理,基于最大似然估计的 图结构预测方法被提出[19] .假设图数据中存在块状 结构,随机分块模型(StochasticBlock Model)被提 出[20] .另外,非负矩阵分解、鲁棒性主成分分析、低 秩稀疏等矩阵分解模型被应用于图数据的建模与预 测[2122] .为了进一步实现图数据的建模学习,近年来 以图神经网络(GraphNeuralNetworks,GNNs)[23] 为代表的大量新型图模型算法被提出,图学习(Graph Learning)领域应运而生,各个图模型的详细介绍见 文献[2425].基于丰富的数据资源和广泛的智能设备,各行各业为图学习系统提供了丰富的应用场景,同时也 要求图模型算法能够适应现实场景中复杂的计算环 境.然而,近年来的研究表明图学习模型具有极高的 脆弱性,恶意攻击者可以通过改变图结构或节点属 性影响图学习模型的性能[2627]或者通过查询窃取图 学习模型及其训练数据[28] .从而,当前的图模型算 法普遍缺乏与复杂计算环境相对应的理论基础和计 算机制、鲁棒可信性不足,其现实应用的安全挑战十 分突出.例如,在金融领域,攻击者可以通过攻击图 模型使金融风险控制系统难以发现高风险的金融交 易;在电子商务领域,攻击者可以通过伪造与高信用 客户的链接关系攻击图模型算法从而提高信用评分 系统对欺诈者的信用评分;在社交网络领域,攻击者 可以通过创建假粉丝和假关注欺骗图模型算法以降 低在线社交网络中垃圾信息发送者的可疑性.因此, 面对图学习的广泛影响以及安全可信的迫切需求,图 学习隐私与安全问题研究有着十分重要的现实意义. 图学习以图数据为对象,图数据具有非欧氏性、 离散性、关联性等特征.同时,与图像处理和自然语 言处理等 领 域 不 同,在 图 数 据 中 的 任 何 操 作 只 能 以节点和链路为单位.另外,与传统机器学习领域学 习任务以归纳式学习(InductiveLearning)范式为 主不同,图学习中典型学习任务主要以直推式学习 (TransductiveLearning)为主.因此,现有的针对图 像处理、自然语言处理相关方法的攻击与防御技术 无法直接适用于图学习模型,图学习系统面临的隐 私与安全问题与传统机器学习领域的隐私与安全问 题不同,具有其自身的独特性.

1.2 本文贡献与章节组织

随着大数据、人工智能隐私与安全问题的逐渐 暴露,公众的防护意识日益增强.尽管近年来图学习 的隐私与安全问题受到了研究领域的逐渐关注,但 仍然面临诸多不足.例如,虽然人工智能领域对学习 模型的安全问题进行了研究,但当前存在的攻击与 防御方法主要集中在图像处理领域,关于图学习的 研究工作相对较少;图数据的隐私保护与图模型的 隐私与安全紧密相关,然而相关研究工作对它们缺 乏深入的整体性思考;图数据的非欧式性导致传统 文本、图像等领域的理论方法无法直接适用于图模 型,图学习的隐私与安全问题仍然缺乏系统性的研 究体系.本文的主要贡献可总结如下: (1)搜集整理了国内外期刊和会议上发表的相 关文献,系统分析了最新的、特别是近5年关于图学 习隐私与安全的研究成果; (2)整体考虑数据与模型的隐私、安全风险,提 出了基于图学习系统基本过程的系统化图学习隐私与安全研究框架; (3)将已有的研究工作按照图学习系统面临的 隐私与安全风险分为四类:面向图数据隐私的攻击 与防护方法、面向图数据安全的攻击与防御方法、面 向图模型隐私的攻击与防御方法以及面向图模型安 全的攻击与防御方法,详细分析了各类方法的机理 和执行过程,对典型算法的机制、优缺点、复杂度和 适用场景进行了讨论.(4)总结了开源社区贡献的图学习隐私与安全 的相关代码资源,分析了面临的研究难点和未来挑 战,有助于后续研究人员更好地进行安全可信图模 型算法的设计和验证. 本文第2节概述图学习隐私与安全基础框架;第3节至第6节分别阐述各类图学习隐私与安全方 法,介绍代表性算法和相关研究进展;第7节梳理相 关开放资源;第8节讨论图学习隐私与安全研究面 临的难点及未来挑战;第9节总结全文.

2 图学习隐私与安全基础框架

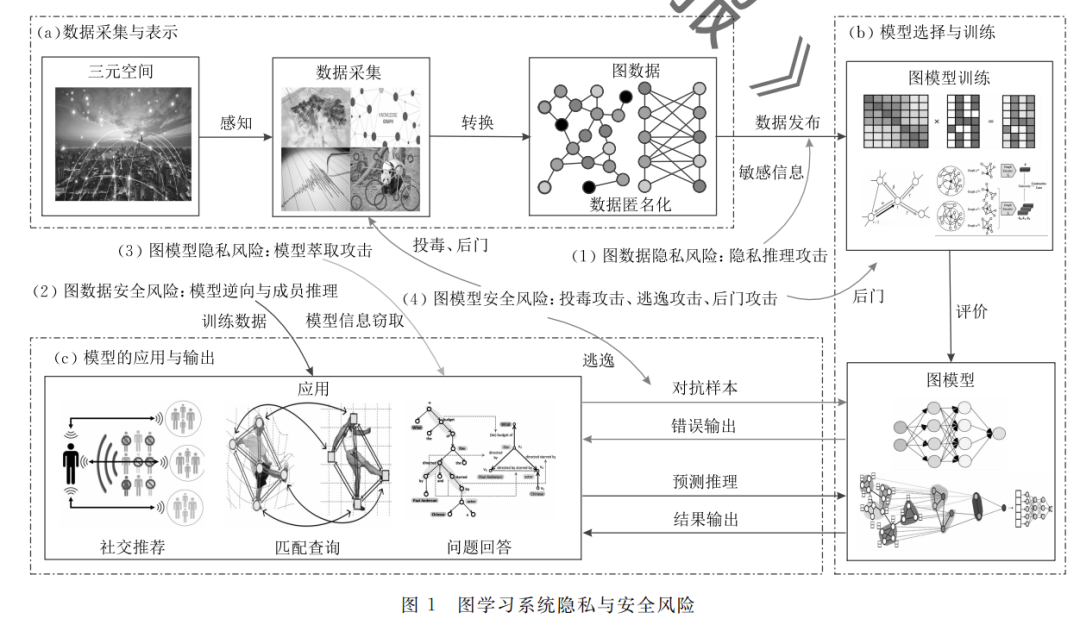

图学习系统的基本过程 图学习隐私和安全问题与图学习系统的基本过 程紧密相关.为了清晰地进行图学习隐私与安全的 分析研究,需要对图学习系统进行介绍,图学习系统 的基本框架如图1所示.一般而言,图学习系统主要 包含以下过程:

(1)数据采集与表示

根据目标对象的不同,图学习系统通过传感器、 爬虫、实验设备、日志记录等方式获得原始数据.然 后,分析采集到的数据中对象以及对象之间的潜在 关联关系,并通过图进行表示.例如,文献[37]对新 闻报道数据进行图表示,将报道国和被报道国定义 为节点,将报道关系定义为有向边.文献[38]计算脑 电图中电极序列之间的功能连接关系,从而获得脑 网络的图表示.

(2)模型选择与训练 此阶段基于可用图数据对图模型进行训练以获 得隐含的模式规律,从而实现图分类、节点标记、链 路预测等任务.根据图模型的特点可以将其分为归 纳式学习和直推式学习两大类.其中,归纳式学习是 指训练数据与测试数据完全独立的学习过程,将学 习好的模型应用于测试数据,常见于图分类等任务. 直推式学习是指在训练阶段模型对训练数据和测试 数据全部可见,将可用数据全部用于学习过程,常见 于节点标记、链路预测、社团检测等任务.

(3)模型应用与输出

经过训练、测试的图模型即可被用于分类、预测 等任务,从而通过开放服务接口对外提供推荐、查 询、问答等智能服务.需要注意的是,对于直推式学 习范式,模型的应用输出和学习训练是紧密融合的, 不存在独立的模型应用与输出过程.例如,对基于矩 阵分解模型的链路预测方法[21],在学习数据模式规 律的同时进行潜在链路的推理预测.

3 面向图数据隐私的攻击与防御方法

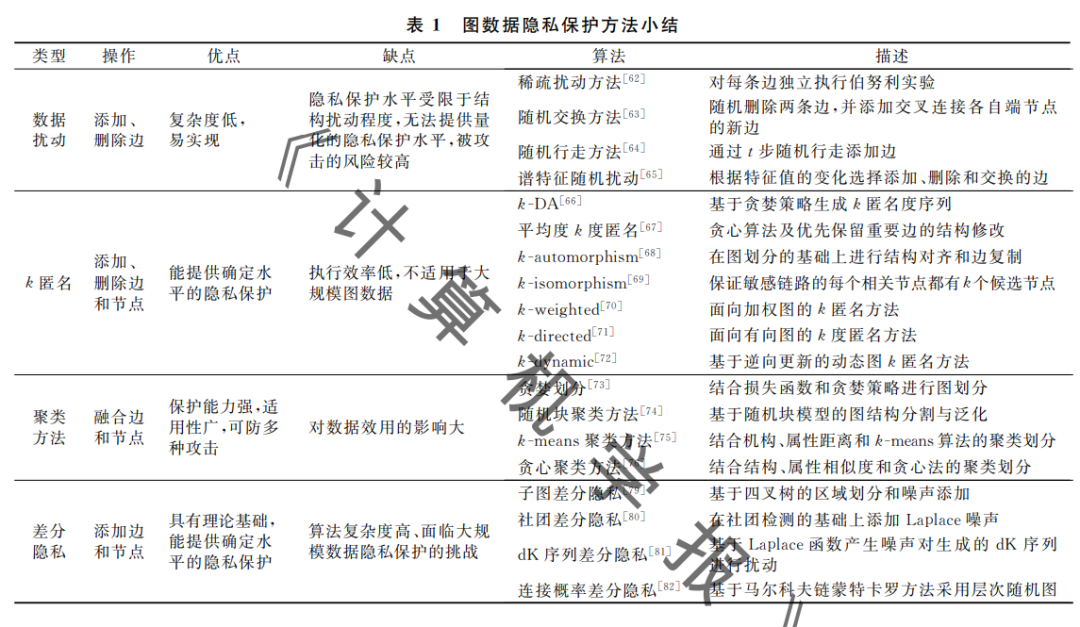

隐私保护的基本思想是在尽可能保持原始数据 不变的条件下对敏感信息进行隐藏,使得攻击者无 法通过背景知识对被隐藏的敏感信息进行重识别攻击.图数据隐私保护与节 点、属性和结构紧密相关,本节主要介绍代表性的图 数据隐私攻击行为和近年来提出的经典的图数据隐 私保护方法.表1是对图数据隐私保护方法的一个小结.数 据隐私保护问题近二十年来得到了研究领域较为充 分的探索,图数据隐私保护也得到了较多的关注,其 中数据扰动方法简单易实现,但发生隐私泄露的风 险较高.犽匿名、聚类方法以及差分隐私方法能够提 供更高水平的隐私保护,但聚类方法对数据效用的 影响较大,犽 匿名和差分隐私方法能够提供确定水 平的隐私保护,但它们复杂度较高.总体上,由于图 数据隐私保护场景的复杂性、背景知识的不可控性 以及要求保持数据效用等原因,仍然还有待提出效 率更高、适用性更好的图数据隐私保护方法.

4 面向图数据安全的攻击与防御方法

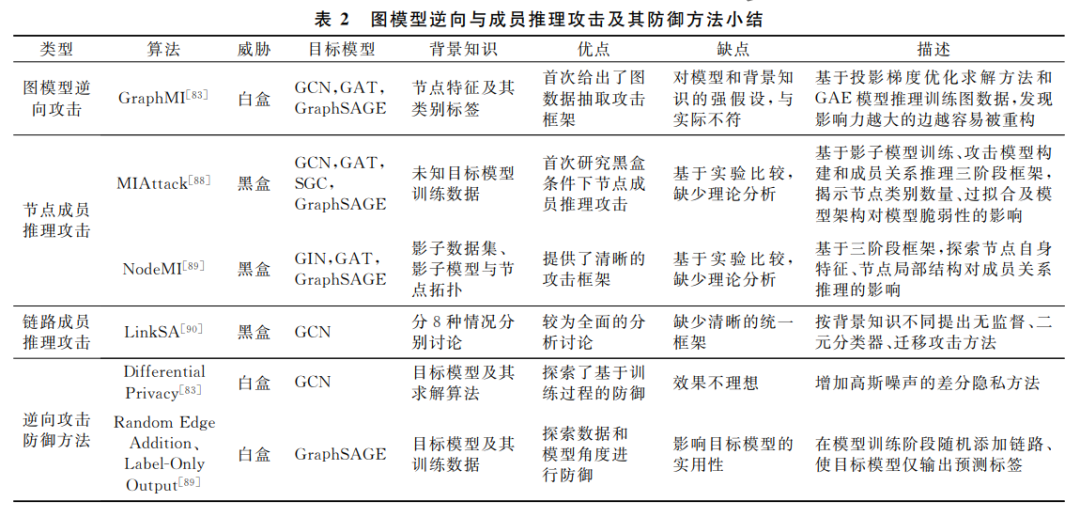

图数据安全关注图模型训练数据的窃取与泄露 风险.特别是对于提供开放服务的图学习系统,恶意 攻击者可能基于系统的输出结果窃取模型的训练数 据或者确定训练数据集中的成员信息,从而暴露敏 感信息、侵害服务提供商的合法权益.

5 面向图模型隐私的攻击与防御方法

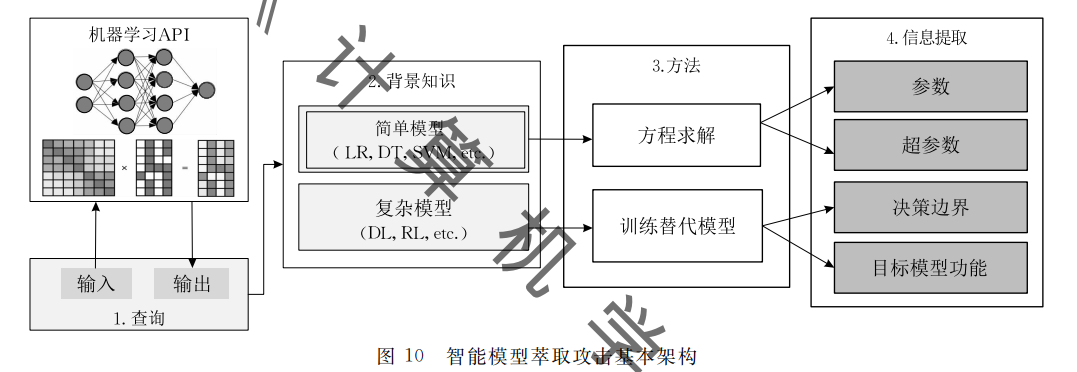

在智能服务系统中尽管智能服务接口是开放的, 但其后台学习模型是私有和保密的.然而,研究表明 攻击者可以通过开放的服务接口 API(获取模型的参数、架构、功 能等信息,从而造成模型机密信息的泄露.研究领域 将以上无 需 训 练 数 据 和 模 型 背 景 知 识,通 过 开 放 API获得模型架构、参数的过程定义为模型萃取攻 击.此攻击通过构建查询 输入并获得相应的模型输出形成输入、输出数据集. 这样的数据集能够反映目标模型的 内在特征.在理想情况下,只要构建了充分覆盖目标 模型输入空间的样本数据并获得相应的输出结果, 就可以复制目标模型. 根据目标模型的复杂度不同,模型萃取攻击可以 分为“简单模型精确提取”以及“复杂模型近似提取” 两大类.对于决策树、逻辑回归、支持向量机等简单模 型,其数学定义清晰,模型萃取攻击只需要获得充分的 输入、输出对,即可通过方程求解的形式推理模型参数 和超参取值,获得较准确的目标模型 .相对的,对 于深度学习、强化学习、集成学习等复杂模型,无法通 过明确的数学公式进行形式化定义,模型萃取攻击 需要通过输入、输出数据集间接刻画目标模型的内 在特征,然后基于此数据集训练替代模型以近似目标模型的功能 . 模型萃取攻击的基本架构如图10所示.

6 面向图模型安全的攻击与防御方法

在传统机器学习领域,模型算法主要应用于企 业内部,训练数据和模型输入都是安全可控的.然 而,越来越开放的智能应用使模型算法面临不可信、 甚至恶意对抗的计算环境.例如,攻击者可以通过改 变训练数据以形成不准确、有缺陷的模型算法.攻击 者可以蓄意构造输入数据从而欺骗目标模型.因此, 各种各样的对抗攻击行为使 得图模型面临严重的安全风险。

7 总结

当前,万物智能互联的应用场景使人工智能面 临严重的安全威胁,直接影响智能系统的实际应用.要促进人工智能产业的蓬勃发展,就必须解决好复 杂条件下数据与模型算法的安全防护问题.图学习 作为人工智能的重要领域之一,由于图数据以及图 学习模型的泛在性,进行图学习的隐私与安全问题 研究具有十分重要的意义.然而,当前研究领域对图 学习隐私与安全的研究存在理论框架和评价体系缺 乏、对图模型攻击与防御机理认识不足等问题.为 此,本文对近年来图学习隐私与安全的相关研究工 作进行梳理归纳,从数据隐私、数据安全、模型隐私 和模型安全四个方面分析讨论了存在的研究成果, 理清了主要方法及其优势与不足.同时,介绍了相关 的开放资源和实验平台.最后,指出当前研究面临的 主要困难并展望了图学习隐私与安全问题未来可能的研究方向.