近年来,图表示学习在遭遇低质量数据问题的同时取得了显著的成功。数据增强作为计算机视觉中提高数据质量的成熟技术,在图领域也受到了越来越多的关注。为了促进这一新兴研究方向的发展,全面回顾和总结了现有的图数据增强(GDAug)技术。

首先总结了各种可行的分类法,然后基于细粒度图元素对现有的GDAug研究进行了分类。此外,针对每类GDAug技术,给出了形式化的一般定义,讨论了技术细节,并给出了示意图。此外,本文还总结了通用的性能指标和具体的设计指标,以构建GDAug评价体系。最后,从数据和模型两个层面总结了GDAug的应用以及未来的发展方向。

https://www.zhuanzhi.ai/paper/ce65107cb76d8844ae0bb20f066c2127

1. 引言

图或网络是一种重要的数据结构,广泛用于建模现实世界中各种复杂的交互系统。例如,用户在Facebook上的交互可以建模为一个社交网络,其中节点代表账户,边代表两个用户之间存在的朋友关系;化合物的结构可以建模为分子图,其中节点表示原子,边表示连接原子的化学键;文献数据库可以建模为异质引文网络,其中节点表示作者和论文,边表示作者之间的协作关系、作者和文献之间的归因关系以及论文之间的引用关系。目前,图已经成为支持关系数据挖掘的基本技术之一。在此基础上,各种图表示学习(graph representation learning, GRL)方法[10,12,28]不断被提出和优化,并在各种图分析任务上取得了优异的性能。

作为一种数据驱动的研究,GRL依赖于足够的高质量数据来表征图的底层信息。然而,对现实世界的交互系统进行建模往往会遭遇一些数据级的挑战,这些挑战会对图模型的学习和下游任务的性能产生负面影响:1)获取数据标签是昂贵和耗时的,这限制了基于监督或半监督设置的图学习方法的有效性。例如,区块链的匿名性使得加密货币交易网络中的账户身份标签信息稀缺,从而导致账户识别模型陷入过拟合和泛化能力低的风险较高[94]。此外,交易网络中的异常账户和交易行为远远少于正常账户,这种标签不平衡问题[45,72,90]将限制图模型在下游任务上的性能。2)现实世界中的复杂交互系统通常会遇到信息丢失、冗余和错误等问题[37,91,93]。例如,由于交易数据的隐私限制,我们通常无法访问某些隐私敏感属性信息;社交网络中恶意关联bot账户会干扰推荐系统准确表征用户特征;恶意数据篡改引入对抗性噪声。这些现象导致次优、不可信和脆弱的图表示学习。

受计算机视觉和自然语言处理中数据增强的显著成功启发,图领域中由低质量数据引起的一系列问题也可以通过在图上进行数据增强来缓解。数据增强可以通过略微修改现有数据或合成新数据来增加有限的训练数据量,帮助机器学习模型降低训练阶段[50]中过度拟合的风险。与图像和文本数据不同,图结构数据是非欧氏的、离散的,其语义和拓扑结构具有依赖性,这使得迁移现有的数据增强技术或设计新的数据增强技术具有挑战性。尽管最近在图增强技术方面取得了进展,但这个新兴的研究领域仍然不健全,缺乏:1)系统的分类;2)广义定义;3)科学的评价体系;4)清晰的应用总结。这使得研究者难以对图数据增强(graph data augmentation, GDAug)有一个清晰归纳的理解,无法在图学习中很好地使用或设计GDAug技术。最近有一些关于GDAug的调研,如表1所示。这些调研根据不同的分类对现有的GDAug技术进行了回顾,如[39,88]中的图任务(节点级、边级、图级),[7,36,71,74,99]中的图元素(面向结构、面向特征、面向标签),以及[81]中的尺度(微观、中观、宏观)。然而,这些与GDAug相关的调查很少概括出GDAug的一般定义,描述设计细节,总结GDAug的评价体系。同时,这些与图自监督学习相关的调查[36,71,74,99]仅将GDAug作为图对比学习中的一个模块进行研究,缺乏对评价体系、应用和技术前景的全面总结。因此,本文对GDAug的相关内容进行了较为全面的总结,主要贡献可归纳为以下几点:总结了现有的多种GDAug分类方法,并使用基于细粒度图元素(即特征、节点、边、子图、图和标签)的分类方法综述了代表性方法,便于研究人员从不同的设计角度理解GDAug。

概括了一般定义,讨论了技术细节,并为每个具体的GDAug方法提供了清晰的示意图。据我们所知,这是从技术角度对GDAug进行的最详尽的总结。

总结了现有的多种GDAug分类方法,并使用基于细粒度图元素(即特征、节点、边、子图、图和标签)的分类方法综述了代表性方法,便于研究人员从不同的设计角度理解GDAug。

概括了一般定义,讨论了技术细节,并为每个具体的GDAug方法提供了清晰的示意图。据我们所知,这是从技术角度对GDAug进行的最详尽的总结。

总结了GDAug可用的评估指标,包括常见的性能指标和特定的设计指标。

文中总结了GDAug在图学习中的应用,并讨论了其面临的挑战和未来的方向。

2. 图数据增强技术针对给定的图数据和相关任务,希望能够帮助研究人员快速找到或设计合适的图增强策略。根据上述分类,我们将根据图元素(或图规模)回顾具有代表性的图数据增强算法,以下原因如下:1)增强策略的设计自由度受到图元素多样性的限制,例如,没有属性的图通常无法应用特征级增强;2)基于不同图元素的扩展通常适用于不同的图任务,例如,节点级扩展通常适用于多种规模的图任务(节点、边、图),而子图级扩展通常只适用于图级任务;3)基于图元素(或图尺度)的分类法比其他分类法更容易、更清晰地组织。综上所述,首先将这些算法分为特征级、节点级、边级、子图级、图级和标签级,然后针对每个类别进一步划分不同的策略。

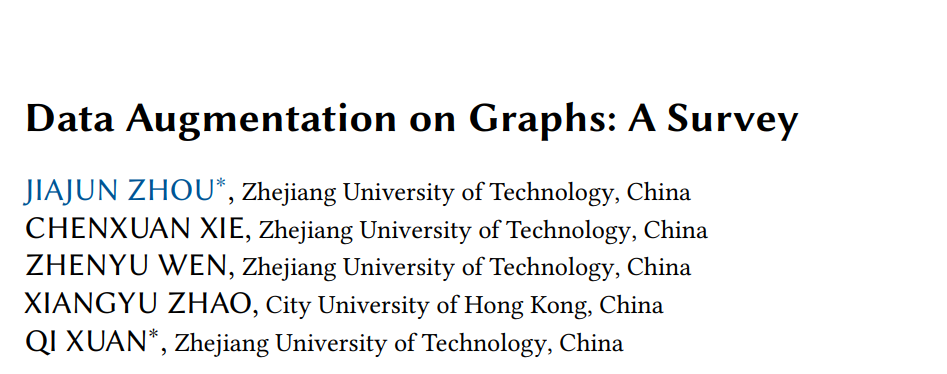

特征级增强

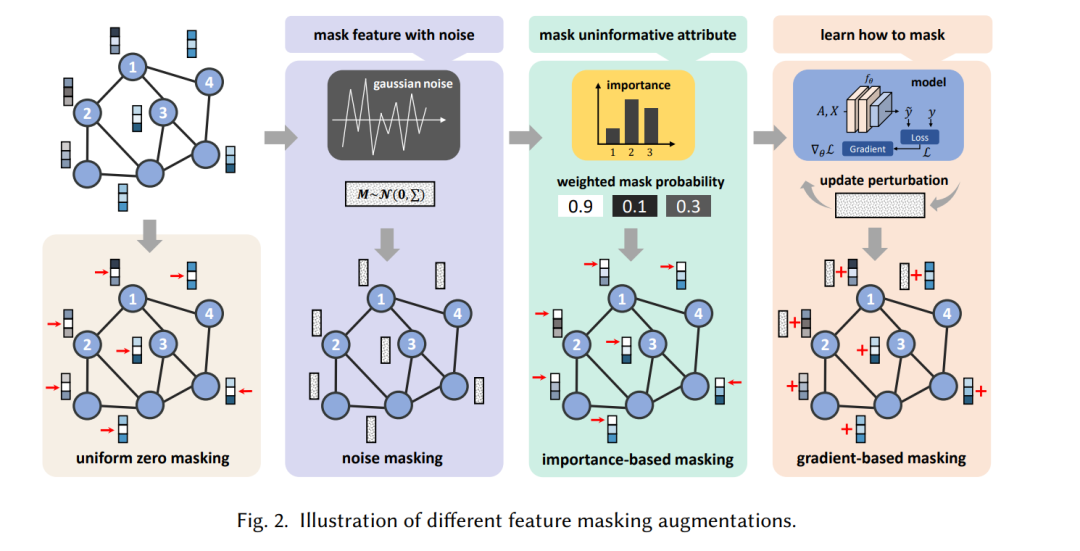

节点级增强

节点级增强主要关注操纵图节点以产生数据多样性,通常适用于节点级任务(节点插值、节点屏蔽)和图级任务(节点删除)。

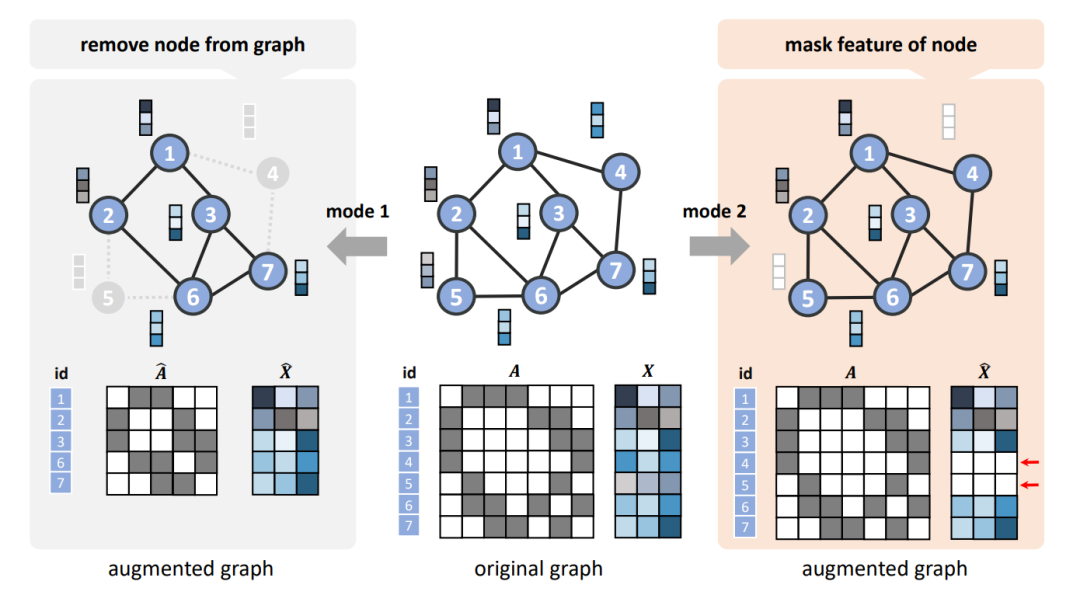

边级增强

边级增强主要关注操纵图的连接结构以产生数据多样性,通常适用于节点级任务和图级任务。现有的边缘级增强包括边缘删除、边缘添加及其混合,我们将其统一为边重连。

子图增强

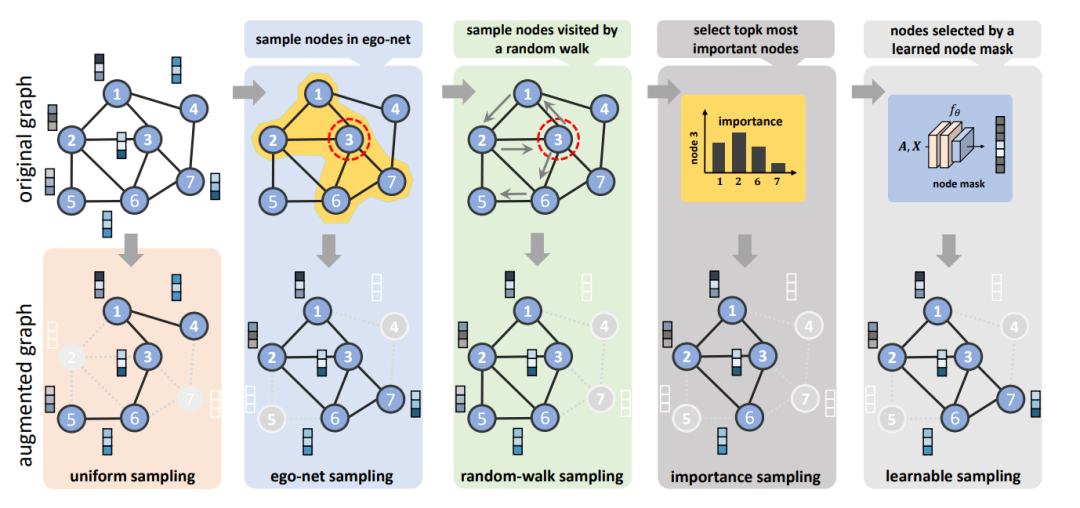

子图级扩充增强通常是一种混合方法,因为它的操作对象子图由多个图元素组成。现有方法主要包括子图采样和子图替换。

图级增强

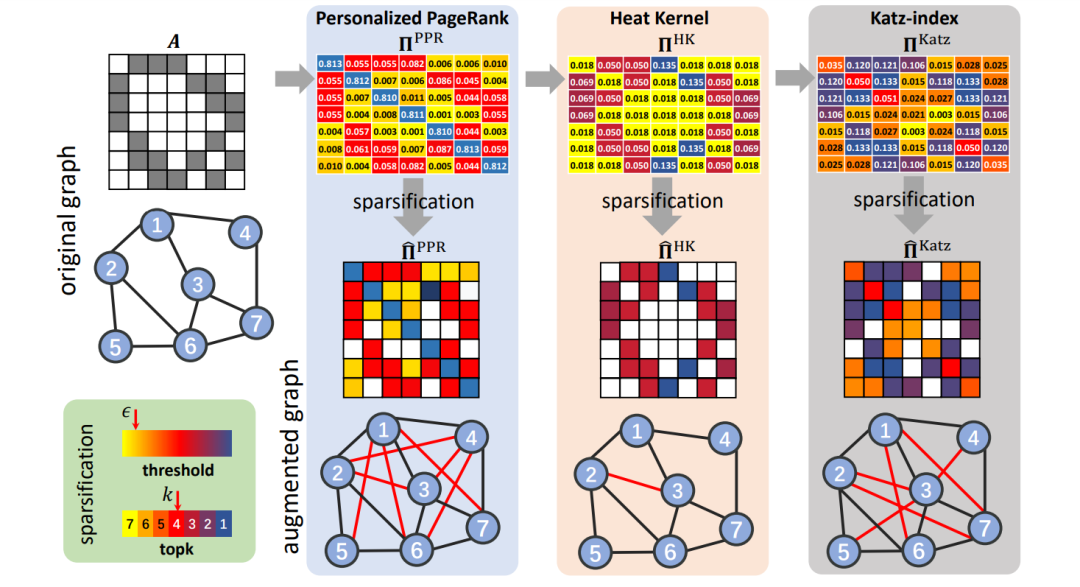

图级增强主要从全局层面对图进行操作以产生数据多样性,现有方法主要集中在图传播和图插值两方面。

标签级增强

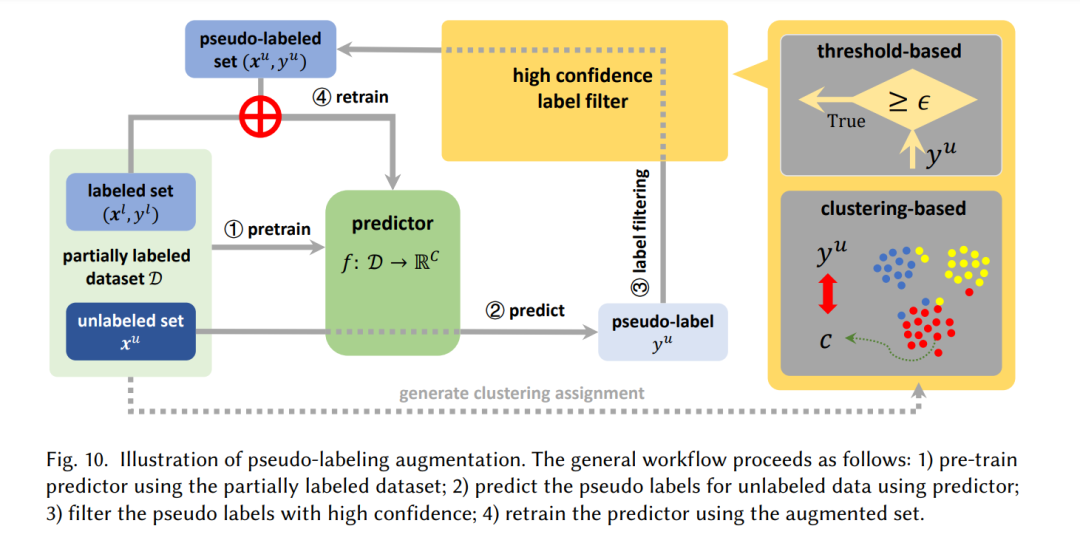

上述大多数GDAug策略主要通过操纵已有图的特征和结构来实现增广,对标签没有特定的约束。而标签级增强是另一种重要的技术,用于使用未标记的数据来增强有限的标记数据。将现有的标签级增强分为伪标签和锐化标签。