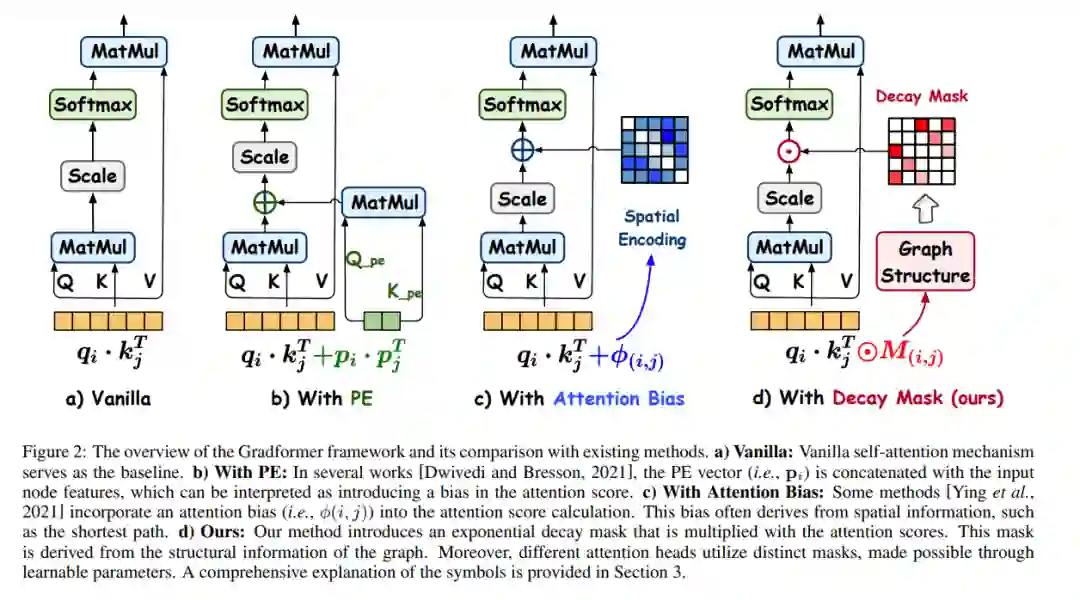

图变换器(GTs)已在广泛的任务中展示了其优势。然而,GTs中的自注意力机制忽略了图的归纳偏见,尤其是与结构相关的偏见,这些对图任务至关重要。尽管一些方法利用位置编码和注意力偏差来模拟归纳偏见,但从分析角度来看,它们的效果仍然不是最佳的。因此,本文提出了Gradformer,这是一种创新性地将GT与内在归纳偏见整合的方法,通过在注意力矩阵上应用指数衰减掩码来实现。具体来说,衰减掩码矩阵中的值呈指数级减小,与图结构内减小的节点邻近度相关联。这种设计使Gradformer能够在关注图的局部细节的同时,保持从远处节点捕获信息的能力。此外,Gradformer引入了一个可学习的约束到衰减掩码中,允许不同的注意力头学习不同的衰减掩码。这样的设计使注意力头多样化,使得能够更有效地同化图中的多样化结构信息。在各种基准测试上的广泛实验表明,Gradformer在各种图分类和回归任务中始终优于图神经网络和GT基线模型。此外,Gradformer已被证明是训练深层GT模型的有效方法,在网络加深的情况下,与其他GT模型观察到的显著准确率下降相比,它保持甚至提高了准确率。代码可在 https://github.com/LiuChuang0059/Gradformer 获取。

成为VIP会员查看完整内容

相关内容

Arxiv

42+阅读 · 2023年4月19日