智能需要记忆。没有记忆,人类就无法完成各种重要的任务,比如读小说、玩游戏或解决数学问题。机器学习的最终目标是开发出像人类一样自动学习和行动的智能系统,因此机器的记忆构建是必然的。人工神经网络通过权值将计算单元连接起来,对大脑中的神经元和突触进行建模,这是一种典型的类似于记忆结构的机器学习算法。他们的后代拥有更复杂的建模技术(即深度学习),已经成功地应用于许多实际问题,并证明了记忆在机器系统学习过程中的重要性。近年来,深度学习中记忆建模的研究主要围绕外部记忆结构展开,受到计算图灵模型和生物神经元系统的启发。注意力机制的产生是为了支持外部记忆的获取和保留操作。尽管缺乏理论基础,这些方法已经显示出帮助机器系统达到更高智能水平的希望。本文的目的是提高对深度学习中记忆和注意力的认识。它的贡献包括: (i) 呈现记忆分类的集合,(ii)构建支持多个控制和记忆单元的新的记忆增强神经网络(MANN), (iii)通过序列生成模型中的记忆引入可变性,(iv)在基于槽的记忆网络中寻找最佳的写操作以最大限度地提高记忆能力;(v)通过神经网络的一种新型外部存储器——神经存储程序存储器来模拟通用图灵机。

目录内容: 1 Introduction 2 Taxonomy for Memory in RNNs 3 Memory-augmented Neural Networks 4 Memory Models for Multiple Processes 5 Variational Memory in Generative Models 6 Optimal Writing Memory 7 Neural Stored-Program Memory 8 Conclusions

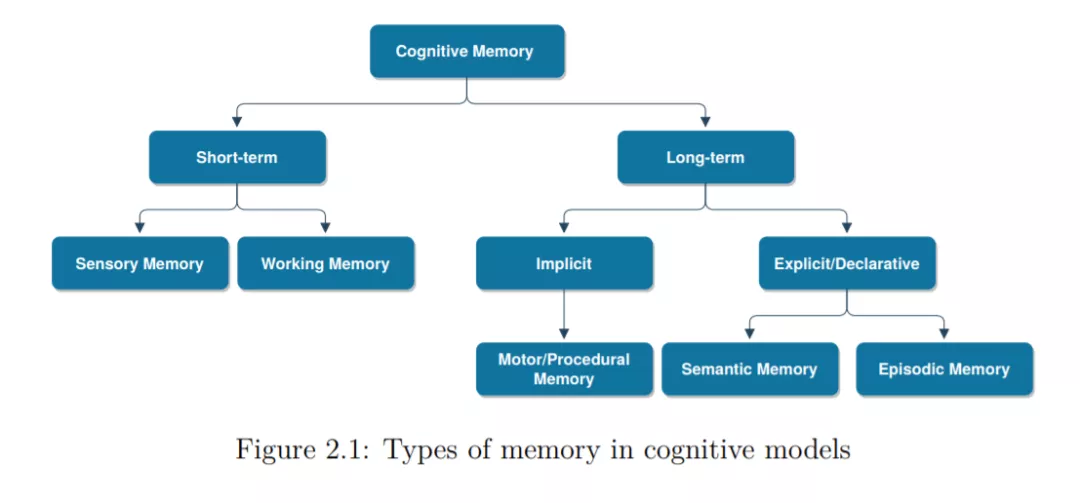

在这篇论文中,我们介绍了神经网络的几种记忆类型,特别是递归神经网络(RNNs)。我们强调记忆作为RNN的外部存储的概念,其中rnn可以学习读写外部记忆,以支持其工作记忆(第2章)。我们回顾了解决训练RNN困难的进展,如门控和注意机制,特别是基于槽的MANN,这是本文第三章提出的新模型的主要内容。我们的主要贡献有四方面。首先, 我们MANN作为一个多进程多视点模型来处理复杂的问题,如sequence-to-sequence映射和多视角序列学习(第四章)。我们进一步扩展MANNs作为离散序列的模型生成会话数据可变性和一致性要求(第5章)。我们也解释到内存中最后,我们介绍了一类新的MANN,它遵循存储程序存储原理,可以通过切换控制器的程序来执行不同的功能。