题目

BERT到底如何work的?A Primer in BERTology: What we know about how BERT works

关键字

BERT,Transformer,NLP,预训练模型,综述,人工智能

简介

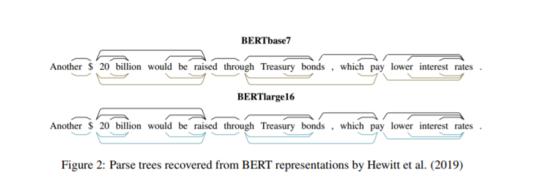

基于Transformer的模型现在已在NLP中广泛使用,但我们对其内部运作仍然知之甚少。 本文描述了迄今为止已知的著名BERT模型(Devlin等人,2019),它综合了40多项分析研究。 我们还提供了对模型及其训练方案的拟议修改的概述。 然后,我们概述了进一步研究的方向。

作者

Anna Rogers, olga Kovaleva, Anna Rumshisky

成为VIP会员查看完整内容

相关内容

专知会员服务

84+阅读 · 2019年10月18日

Arxiv

4+阅读 · 2019年9月11日