硬件和人工智能(AI)解决方案的不断进步,使一系列软件系统的部署更加贴近用户,从而增加了边缘软件系统范例的应用。边缘系统支持将计算部署在更靠近数据生成和需要的地方,并提供减少延迟、优化带宽、提高弹性和可用性等优势。在高度不确定和资源有限的环境中工作的用户,如急救人员、执法人员和士兵,可以从边缘系统中大大受益,从而支持更及时的决策。遗憾的是,工业界和研究人员在很大程度上忽视了了解边缘系统的不同架构方法如何影响优先质量问题,但这对国家和地方安全、资源优化利用和及时决策至关重要。工业界大多关注边缘系统的硬件和网络方面,而很少关注实现边缘功能的软件。本文介绍了我们为填补这一空白所做的工作,定义了高度不确定环境中边缘系统的参考架构,并展示了在实践中如何实施该架构的实例。

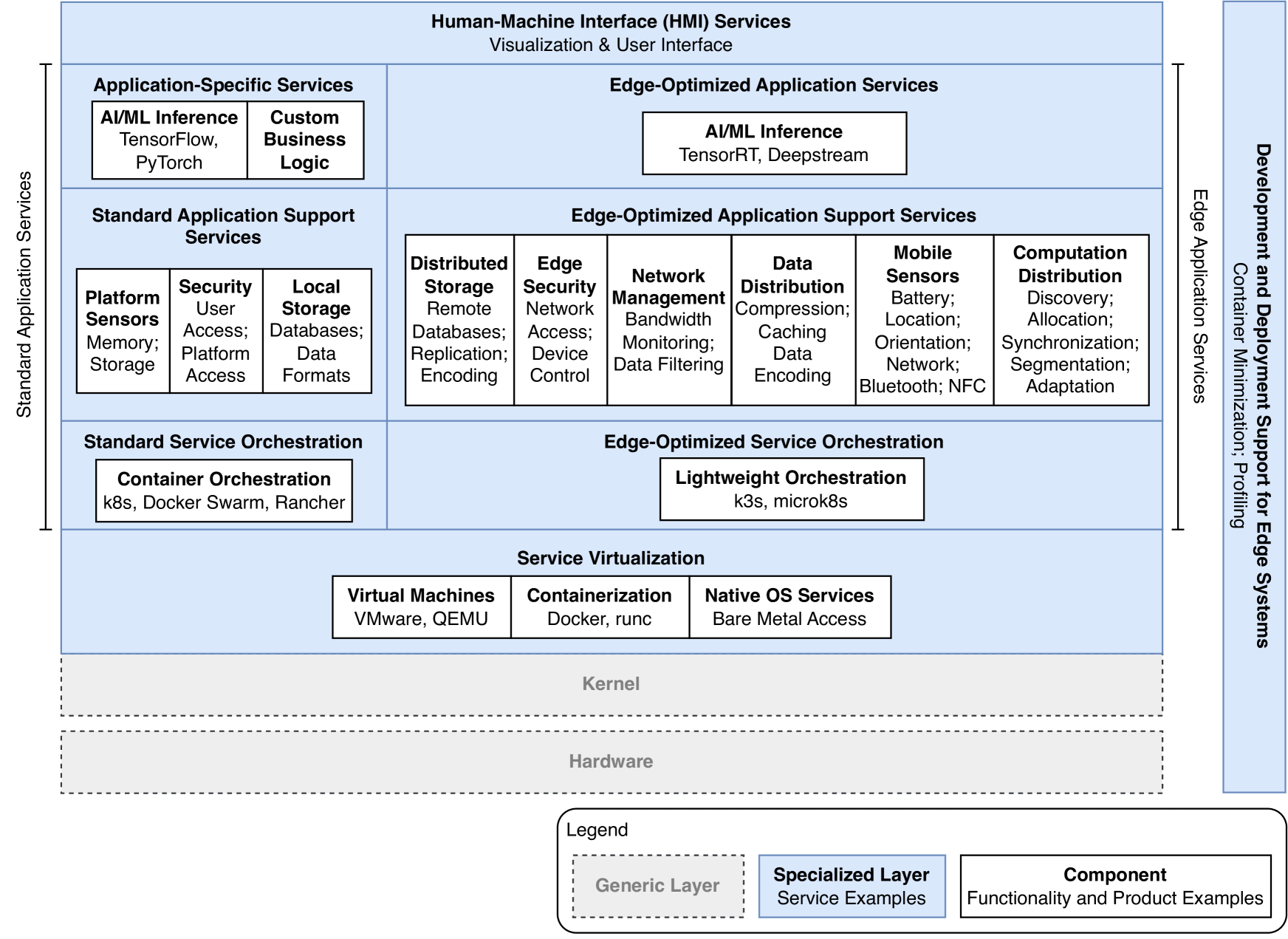

图 1:高度不确定环境中边缘系统的拟议参考架构--分层视图

高度不确定环境中的边缘系统参考架构

边缘软件系统通常是更大分布式系统的一部分,云节点和边缘节点之间存在交互,边缘节点充当近端用户和云之间的中介。云到边缘连续体(或边缘到云连续体)是用来描述云和边缘节点之间交互的术语,其中数据和计算根据需要在两者之间移动。

如何满足在高度不确定环境中运行的边缘系统的要求,其主要驱动因素是不确定性的大小。为了支持云到边缘的连续性,同时管理和适应这种不确定性,边缘系统需要具备以下能力:

- 网络感知: 对网络状况(如可用性和带宽)的感知将推动有关何时发送信息以及发送何种信息的决策。

- 位置感知: 对位置以及其他近距离设备和系统的感知将驱动计算分配或委托的决策。

- 资源感知: 对内存和存储等可用资源状态的感知,将驱动计算分配和数据存储决策。

- 环境感知: 通过机载传感器感知环境,驱动与计算分配或锁定相关的决策,并在正常运行和降级运行之间进行切换。

- 结构安全(主动监控):无需依赖访问集中式身份验证和授权服务,即使断开连接也能访问本地资源,并在运行时调整安全态势以应对感知到的威胁。

- 高度模块化: 高度模块化可实现精细的计算分配。

图 1 显示了高度不确定环境中边缘系统的拟议参考架构,该架构源于我们在边缘软件系统方面的现有研究,并通过在实际系统中的应用(包括第四节中描述的系统)得到了完善。该架构特别提出了人工智能/移动语言功能,因为这些功能在边缘的部署越来越多,主要用于数据处理和快速决策。由于边缘设备对数据的依赖和昂贵的计算需求,人工智能/移动语言功能尤其会受到边缘设备计算资源限制的挑战[4]。现在,我们将从上到下逐层介绍该架构。

人机界面 (HMI) 服务。这些服务是支持现场决策的所有可视化和用户界面(UI)组件。人机界面服务必须简单明了,并利用先进的输入方法、上下文感知和自动化来应对操作环境条件造成的高认知负荷。

图 1 中间层的左侧--标为标准应用服务--对应的是适用于任何边缘软件系统的更传统的服务。在许多情况下,由于并非所有边缘设备都极其有限,而且功能越来越强大,因此它们通常甚至无需进行边缘优化:

- 特定应用服务。这些服务包括定制业务逻辑以及边缘 AI/ML 应用程序的 ML 推断代码,由 TensorFlow和 PyTorch等传统框架提供支持。

- 标准应用支持服务。这些服务包括用于有限资源(如内存和存储)的平台传感器服务;本地存储;以及用户和平台访问的安全性。

- 标准服务协调。协调服务是计算和数据在云服务器和边缘设备间移动的关键,可由 Kubernetes (k8s) 、Docker Swarm和 Rancher等商业和开源产品提供。 图 1 中层的右侧(标记为边缘应用服务)对应边缘优化服务,以应对不确定性和资源限制。

边缘优化应用服务。资源受限设备上的边缘 AI/ML 应用程序需要包括传统模型的更快版本,利用 TensorRT [10] 和 DeepStream等加速和优化框架。这些框架具有 "硬件感知 "能力,能够针对目标设备做出最佳加速决策。在某些情况下,加速可能会降低精度,从而产生初始结果,有时甚至是粗粒度结果。即使在这种情况下,这些结果也能让用户更快地做出反应,而不是等待不可靠的云资源提供结果,即使它们能提供更详细、更准确、更细粒度的答案。

边缘优化应用支持服务。这些是收集环境信息、优化资源使用和适应运行条件的主要服务。

- 分布式存储服务支持跨云和边缘节点的分布式数据存储解决方案,包括支持远程数据库、减少延迟的复制和断开操作支持,以及减少存储的优化编码。

- 边缘安全服务用于网络访问和设备控制,包括分散式身份验证和授权方法,以确保在 DDIL 环境中运行。

- 网络管理服务用于管理可用的网络带宽,包括用于适应触发器的连续带宽监控和数据过滤,以优化带宽使用。

- 数据分发服务用于在云和边缘之间优化数据分发,包括压缩、缓存和数据编码,如协议缓冲区、DTN 捆绑和 XML 的 EXI 编码。

- 移动传感器服务可管理任何可用的车载传感器,这些传感器会根据不断变化的条件或可用资源(如电池、位置、方向、网络、蓝牙和 NFC(近场通信))触发相应的调整。传感器输出还可用于触发用户界面变化,以适应运行条件。

- 计算分配服务用于根据不断变化的条件和可用资源调整和分配计算,包括发现、分配、同步、分割和调整。

边缘优化服务协调。这是由 k3s和 MicroK8s等商业和开源产品为受限边缘设备提供的协调服务。

服务虚拟化。考虑到云到边缘的连续性和边缘设备的异构性,服务虚拟化是云到边缘以及边缘设备之间计算分配的关键。这一层的服务包括对虚拟机、容器和本地操作系统服务的支持。

边缘系统的开发和部署支持。在高度不确定的环境中开发和部署边缘系统的服务贯穿所有层,例如,最小化容器以解决带宽和计算资源有限的问题(如 SlimToolkit),以及剖析以了解应用程序是否能在边缘设备上有效运行(如 htop)。