在需要做出重大决策的关键系统中,通常无法实现或不希望实现完全自动化。相反,人类-人工智能团队可以取得更好的效果。为了研究、开发、评估和验证适合这种团队合作的算法,有必要建立轻量级实验平台,实现人类与多个智能体之间的互动。然而,此类平台在国防环境中的应用实例非常有限。为了填补这一空白,我们提出了 Cogment 人机协同实验平台,该平台实现了以异构多智能体系统为特征的人机协同(HMT)用例,可涉及学习型人工智能智能体、静态人工智能智能体和人类。它建立在 Cogment 平台上,已被用于学术研究,包括在今年的 AAMAS 的 ALA 研讨会上展示的工作。希望通过这个平台,进一步促进关键系统和国防环境中的人机协作研究。

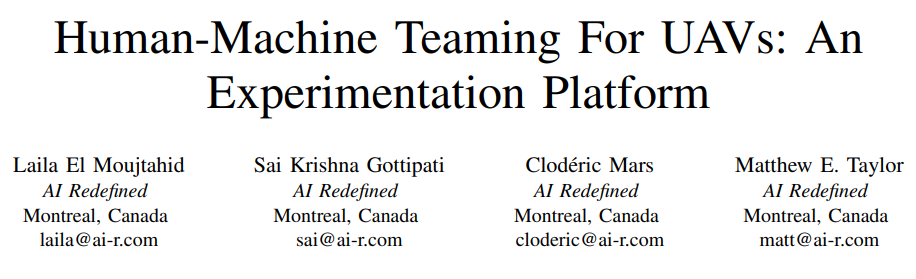

图 1:该图显示了 Cogment HMT 实验平台的主用户界面。左侧带帽的圆圈是由五个蓝色智能体组成的团队防守的禁区。右侧的单个红点是无人机攻击者。

嵌入式人工智能体,如无人驾驶飞行器(UAV,或无人机),有可能彻底改变各行各业,包括交通、农业和安防。然而,这些智能体在物理世界中发展,因此可能会产生危险影响,尤其是在无人监管的情况下。例如,无人机可能会出现故障或无法识别潜在危险,从而造成财产损失甚至人员伤亡。此外,智能体可以根据算法做出决策,而算法可能不会考虑伦理、道德或法律方面的影响。因此,人类必须有能力对这些智能体进行有意义的控制[2]和监督,以确保它们的安全和负责任的使用。人类操作员可以监控和干预系统故障,评估潜在风险,并在需要其判断的复杂情况下做出道德或法律决定。

除了监督,人类还可以通过协作在帮助智能体实现任务方面发挥关键作用。例如,对于无人机,控制中心的人类操作员可以提供实时指导和支持,确保无人机准确、高效地执行所需的功能。此外,人类还可以在现场充当队友,与具身的人工智能体并肩作战,实现既需要人类判断又需要机器精确度的复杂目标。

此外,必须认识到,人机协作(HMT),即人类与具身智能体建立双向协作的能力,是安全有效使用人工智能的一个关键方面。这类人工智能体的设计、训练、验证和操作不能孤立地进行,必须考虑它们如何融入包括它们在内的更大系统中。人类,尤其是作为操作员或队友的人类,从一开始就应被视为该系统不可分割的一部分。

除了这种双向协作之外,具身人工智能系统在运行过程中往往没有考虑到 “道德责任 ”和 “社会技术 ”因素[2]。有意义人类控制(MHC)的概念是由 Santoni de Sio 和 van den Hoven 提出的,目的是让人类能够影响具身人工智能体的行为[3]。然而,MHC 的原始定义并不一致,因为人类可能缺乏专业技能或知识,无法完全有效地控制人工智能系统。Cavalcante Siebert 等人[2]提出了四个附加属性来改进 MHC 的原始定义:“明确的道德操作设计领域”、“适当且相互兼容的表征”、“控制能力和权限 ”以及 “人工智能与人类行动之间的明确联系”。因此,至关重要的是设计一个协调平台,将有意义的人类控制和人类在环相结合,以确保人工智能系统的训练和操作方式符合人类价值观、社会规范和道德行为。

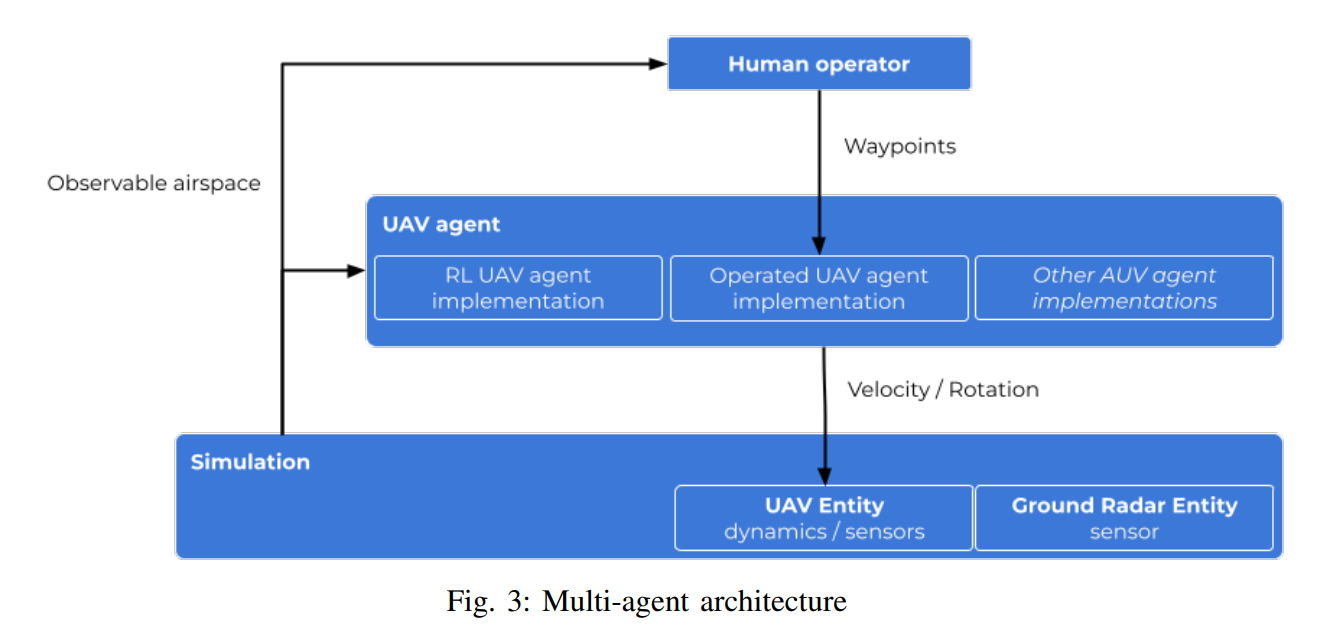

Cogment HMT 提供了一个设计和实验人机团队的平台,尤其是涉及无人机的人机团队。它以我们的 Cogment [4] 平台为基础,解决了协调自动决策系统(包括人工智能体)、人类之间的协作及其对数据的访问和对环境的影响等难题。Cogment HMT 实验平台目前使用一个模拟环境,可以很容易地进行调整,以适应更真实的模拟和现实世界的部署。我们将在第三节介绍该平台及其特性。

利用 Cogment HMT 实验平台,人工智能从业者可以开发出能够与人类协同工作的智能体,并从人类的知识和期望中学习,同时考虑有意义的人类控制、信任和认知负荷管理等因素,实现有效的双向人机协作。我们将在第四部分介绍早期成果。