随着人工智能的发展,很多人开始担心深度伪造图像和视频的潜在危险,例如传播有影响力人物的虚假视频。针对这一问题,人们提出了多种解决方案,其中最有效的是用于人脸检测的卷积神经网络,以区分真实图像和生成式对抗网络生成的深度伪造图像。目前最流行的模型之一是 VGGFace,本报告将对其进行进一步分析。该项目探讨了不同的超参数如何影响现有卷积神经网络的有效性以及模型的鲁棒性。对准确性影响最大的超参数是网络每一步的卷积层数量。结果表明,虽然深度假货检测模型在测试集上表现出很高的准确性,但在鲁棒性方面却乏善可陈。模型对测试图像的分辨率有明显的敏感性。这是一个可以通过调整大小来解决的问题,但本报告显示了一个更令人担忧的问题,即在不同的数据集上进行测试时,模型的准确率降低了 47 个百分点,而该数据集上的假图像是用不同的生成式对抗网络生成的。该项目的主要启示是,目前的深度防伪检测模型必须在泛化方面下功夫,才能有效地对图像进行分类。

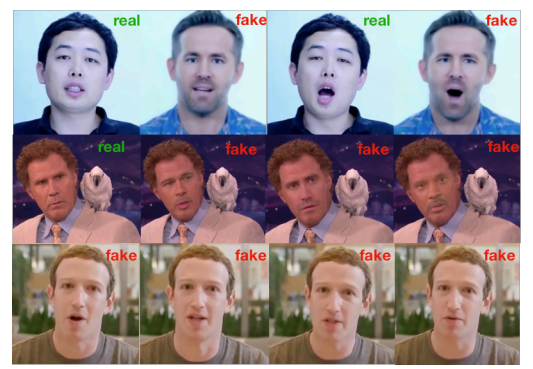

图 1.1.1: 头像(第 1 行)、换脸(第 2 行)和唇语同步(第 3 行)示例。图片来自 Deepfake 检测: 当前挑战与下一步行动[14]

难点

机器学习模型很难检测到某些深度伪造图像,而对于包含大量特征作为预测基础的图像,很难确定哪些特征真正有助于提高预测准确率。John 等人 [12] 将特征分为三类: 从未对预测准确性做出贡献的无关特征、有时会对预测准确性做出贡献的弱相关特征以及强相关特征,这意味着无法在不损失准确性的情况下删除该特征。有几种不同的方法可以减少数据中无关特征的数量,根据源数据的不同,效率也不同。一些比较常见的通用方法包括:作为启发式搜索的特征选择、特征选择的过滤器方法和特征选择的包装方法[3]。

现代深度防伪检测技术已经变得相当准确,许多技术的准确率达到 90% 或更高。但仍有一些情况下,最先进的 CNN 无法对图像进行正确分类。随着深度伪造技术的不断发展,了解检测模型的优缺点对于有效打击虚假信息的传播至关重要。因此,我们提出了一个问题: 是什么让现代卷积神经网络如此有效?

目的

本文旨在利用卷积神经网络(CNN)研究深度伪造图像检测模型的有效性和鲁棒性。随着深度伪造技术的激增,人们越来越需要可靠、准确的方法来检测被篡改的图像和视频。本项目旨在评估基于 CNN 的深度伪造检测模型的性能,比较其在修改模型时的准确性以及与各种类型的深度伪造图像的对比。

具体来说,本项目将研究以下研究问题:

- 基于 CNN 的模型在检测深度伪造图像时表现如何,哪些因素对其准确性影响最大?

- 当前基于 CNN 的深度伪造检测模型有哪些局限性,它们对不同类型图像的鲁棒性如何?

为了解决这些研究问题,本项目将回顾和分析有关深度伪造检测和基于 CNN 的模型的现有文献,并使用深度伪造图像数据集进行实验。该项目的目标是为不断增长的深度伪造检测知识库做出贡献,并深入了解当前检测模型的优势和局限性。

利益、伦理和可持续发展

任何希望利用 CNN 进行深度伪造图像或视频检测的人都将从本学位项目中受益。通过伪造警察施暴的视频、通过私下讨论伪造法官腐败的视频或使用种族主义语言伪造边防警卫的视频[10],深度伪造可能会导致人们对机构的信任度下降。这些机构可以从该项目中获益,学习如何改进自己的检测模型,或者在实施深度伪造检测模型时要格外注意哪些类型的源数据。安德鲁-雷还指出了政治深度伪造的潜在问题,即深度伪造视频可能被用于影响选举[16]。因此,所有类型的选举及其参与者都能从中受益。

考虑到本项目探讨的是如何改进深度伪造检测模型,因此并不涉及很多伦理难题。不过,整个深度伪造检测可能会出现一些伦理问题。一项荟萃分析表明,新闻媒体中存在政治偏见[6]。虽然偏向一种意识形态的偏见通常会被偏向另一种意识形态的偏见所抵消,但仍然存在个别消息来源的偏见问题。偏见很少会影响到已经明显处于政治光谱某一边的选民,但中间派倾向于投票反对他们所听到的负面新闻[2]。不同的媒体可以使用深度伪造检测模型来揭穿损害其偏好的政治观点或候选人的视频,同时避免揭穿其他候选人的欺诈性媒体,甚至避免传播深度伪造视频。

要正确利用深度伪造检测模型的所有潜在优势,就必须使用其中一种可用模型对所有媒体文章进行自动测试。然而,这样做会带来一些可持续性问题,因为每秒钟大约有 3,400,000 封邮件被发送[21],740,000 条 WhatsApp 消息[7],55,000 条 facebook 帖子[20]和 6,000 条微博[9]。在这样的容量下运行模型时,这些媒体帖子的数量在计算限制、资源分配和能源消耗方面显然是不可持续的。