旨在对不同时间跨度的视频帧之间的时间关系和相关性进行建模,表现SOTA!性能优于50Salads、MSTCN++等网络,代码即将开源!

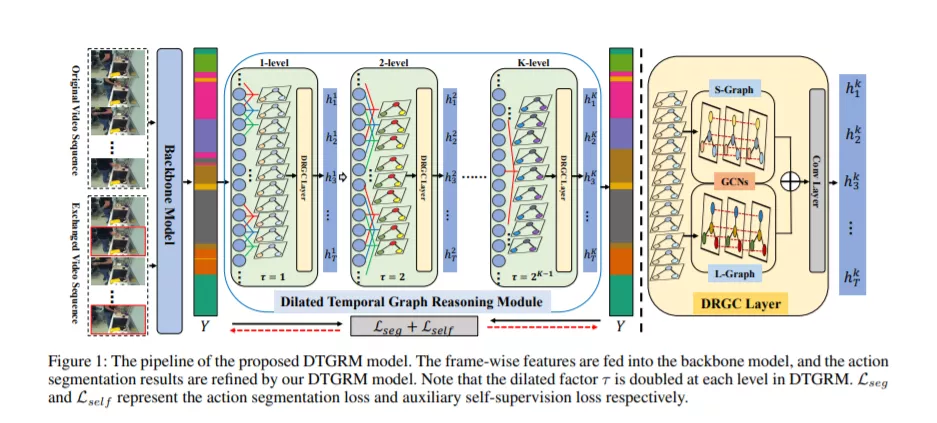

视频中的时间关系建模对于人类动作理解(例如行为识别和动作分割)至关重要。尽管图卷积网络(GCN)在许多任务的关系推理中显示出了令人鼓舞的优势,但在长视频序列上有效地应用图卷积网络仍然是一个挑战。主要原因是大量节点(即视频帧)使GCN难以捕获和建模视频中的时间关系。为了解决这个问题,在本文中,我们引入了一个有效的GCN模块,即膨胀时间图推理模块(DTGRM),该模块旨在对不同时间跨度的视频帧之间的时间关系和相关性进行建模。特别是,我们通过构造多级扩张的时间图来捕获和建模时间关系,其中节点表示视频中不同时刻的帧。此外,为了增强所提出模型的时间推理能力,提出了一种辅助的我监督任务,以鼓励膨胀的时间图推理模块找到并纠正视频中错误的时间关系。在三个具有挑战性的数据集上,我们的DTGRM模型优于最新的动作分割模型:50Salads,在GTEA和Breakfast数据集上。

成为VIP会员查看完整内容

相关内容

Arxiv

13+阅读 · 2020年12月14日

Arxiv

6+阅读 · 2020年10月12日

Arxiv

3+阅读 · 2019年11月27日

Arxiv

3+阅读 · 2019年6月11日

Arxiv

3+阅读 · 2019年3月6日

Arxiv

5+阅读 · 2018年12月6日