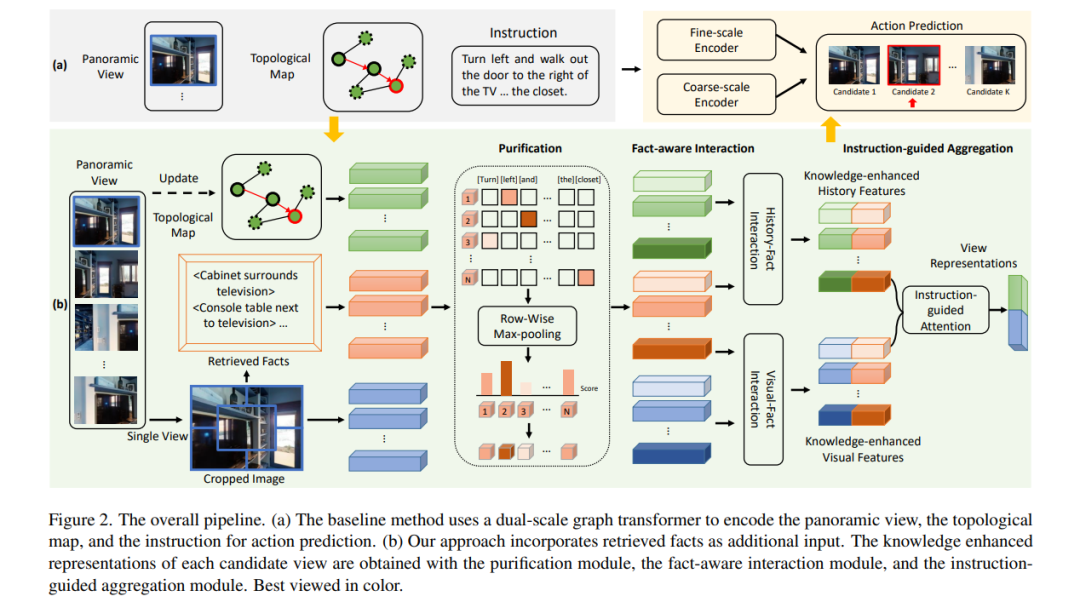

视觉-语言导航(VLN)是使具身智能体在真实场景中按照自然语言指令导航到远程位置的任务。以往的方法大多利用整个特征或以对象为中心的特征来表示可导航的候选特征。然而,这些表示不足以使智能体执行动作以到达目标位置。**由于知识提供了与可见内容相补充的重要信息,本文提出了一种知识增强的推理模型(knowledge Enhanced Reasoning Model, KERM)来利用知识来提高智能体的导航能力。**具体来说,首先从构建的知识库中检索基于局部区域的导航视图的事实(即语言描述的知识);检索到的事实范围从单个对象的属性(如颜色、形状)到对象之间的关系(如动作、空间位置),为VLN提供了重要信息。进一步提出了KERM,包含净化、事实感知交互和指令引导的聚合模块,以集成视觉、历史、指令和事实特征。所提出的KERM可以自动选择和收集关键和相关的线索,获得更准确的动作预测。在REVERIE、R2R和SOON数据集上的实验结果验证了所提方法的有效性。源代码可以在https://github.com/XiangyangLi20/KERM上找到。

成为VIP会员查看完整内容

相关内容

CVPR 2023大会将于 6 月 18 日至 22 日在温哥华会议中心举行。CVPR是IEEE Conference on Computer Vision and Pattern Recognition的缩写,即IEEE国际计算机视觉与模式识别会议。该会议是由IEEE举办的计算机视觉和模式识别领域的顶级会议,会议的主要内容是计算机视觉与模式识别技术。

CVPR 2023 共收到 9155 份提交,比去年增加了 12%,创下新纪录,今年接收了 2360 篇论文,接收率为 25.78%。作为对比,去年有 8100 多篇有效投稿,大会接收了 2067 篇,接收率为 25%。

Arxiv

0+阅读 · 2023年5月17日