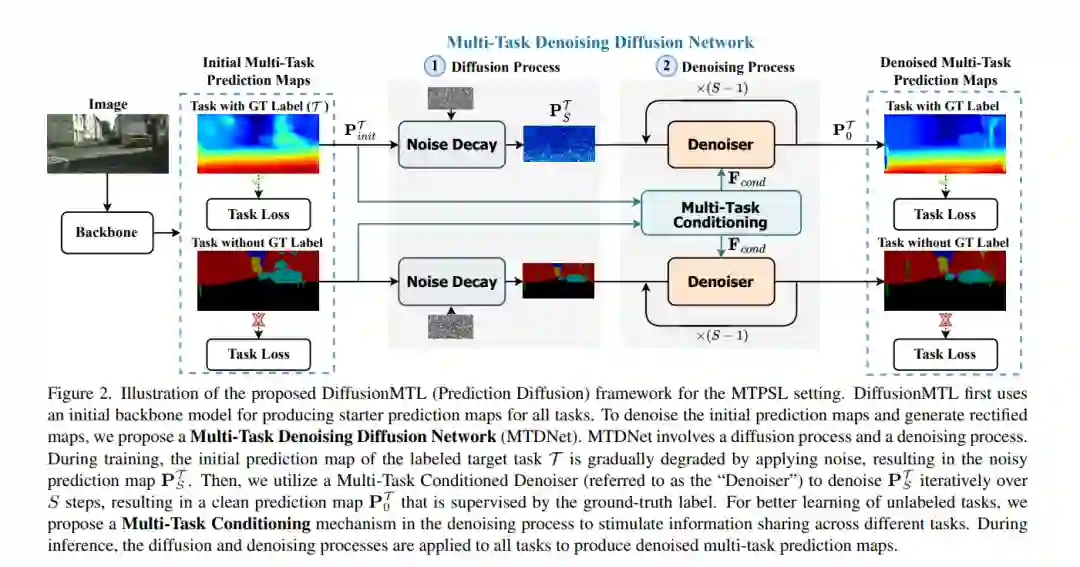

最近,从部分标注数据学习多个密集场景理解任务的实际问题越来越受到关注,其中每个训练样本只为任务子集标注了标签。在训练中缺失任务标签会导致低质量和噪声预测,这一点可以从最新方法中观察到。为了解决这个问题,我们将部分标注的多任务密集预测重新表述为像素级去噪问题,并提出了一种新颖的多任务去噪扩散框架,命名为DiffusionMTL。它设计了一个联合扩散和去噪范式来模拟任务预测或特征图中潜在的噪声分布,并为不同的任务生成校正输出。为了在去噪中利用多任务一致性,我们进一步引入了一种多任务条件策略,该策略可以隐式地利用任务的互补性质来帮助学习未标注的任务,从而提高不同任务的去噪性能。大量的定量和定性实验表明,所提出的多任务去噪扩散模型能显著改善多任务预测图,并在三个具有挑战性的多任务基准测试中,在两种不同的部分标注评估设置下超越最新方法。代码可在 https://prismformore.github.io/diffusionmtl 获取。

成为VIP会员查看完整内容

相关内容

Arxiv

42+阅读 · 2023年4月19日

Arxiv

224+阅读 · 2023年4月7日