本文最近研究了预训练和微调图神经网络(GNN)的范式,并将其广泛应用于各种图挖掘任务中。其成功通常归因于预训练和下游数据集之间的结构一致性,但在许多实际场景中并不成立。现有工作表明,预训练和下游图之间的结构差异显著限制了使用传统微调策略的可转移性。这种差异导致模型在预训练图上过拟合,并且在捕获下游图的结构属性时遇到困难。

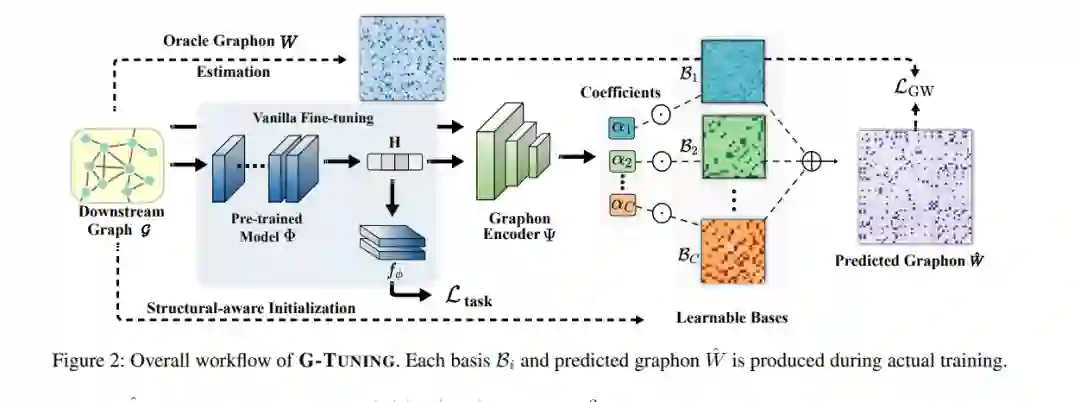

在本文中,我们确定了结构差异的根本原因为预训练和下游图之间生成模式的差异。进一步地,我们提出了G-TUNING方法来保留下游图的生成模式。给定一个下游图G,核心思想是调整预训练的GNN,使其能够重建G的生成模式,即图论W。然而,精确重建图论是众所周知的计算成本高昂。为了克服这个挑战,我们提供了一个理论分析,建立了任何给定图论存在一组替代图论基的概念,称为图论基。通过利用这些图论基的线性组合,我们可以有效地近似W。这一理论发现构成了我们提出模型的基础,因为它使得有效地学习图论基及其相关系数成为可能。与现有算法相比,G-TUNING在域内和域外迁移学习实验中分别平均提高了0.5%和2.6%。

成为VIP会员查看完整内容

相关内容

Arxiv

42+阅读 · 2023年4月19日