美国国家科学、工程和数学研究院(National Academies of Sciences, Engineering, and Mathematics)为空军研究实验室(Air Force Research Laboratory,AFRL)撰写的一份共识报告记录了各军种对支持人类-人工智能(AI)团队合作的普遍和日益增长的渴望。Sonalysts 已经开始了一项探索人类-人工智能团队培训的内部计划。这项工作的第一步是开发能够促进人类-人工智能团队研究的合成任务环境(STE)。我们的目标是创建一个能提供任务环境的 STE,以支持利益相关者计划在该领域开展的广泛研究。因此,我们希望对相关研究团体的优先事项进行广泛的抽样调查,本报告中记录的工作就是我们的初步尝试。我们制作了一份包含两类问题的调查问卷。第一类问题要求受访者报告他们是否同意我们预计可能很重要的科技教育特征。第二种是开放式问题,要求受访者明确他们在预期科技教育的几个方面中的优先考虑事项。研究小组邀请了 19 名来自学术实验室和政府实验室的研究人员参与调查,其中 11 人完成了调查。研究小组对他们的回答进行了分析,以确定出现的主题和需要进一步分析的课题。调查中最重要的发现是,许多研究人员认为已经存在能满足我们需求的各种开源 STE。研究人员还强调了对自动转录和编码工具的需求,以减轻评估团队间交流的负担;强大的数据采集和导出功能的重要性;以及在工具的许多方面具有广泛灵活性的可取性。

调查发展与分析

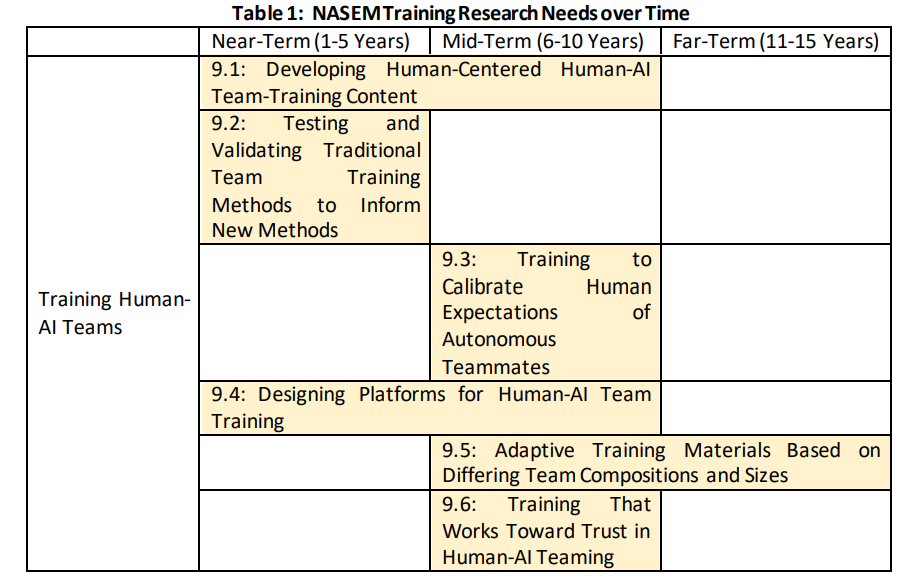

与人类-人工智能团队合作的目的是深入了解研究人员感兴趣的研究问题、自变量和性能衡量标准。这种洞察力将指导团队合作试验台的开发,并确保我们开发试验台的方式能够促进当前和新兴的研究议程。我们的目标是创建一个 STE,在有用的系统架构上提供相关的任务环境;具有适当的情景编写和修改能力;以及便于数据收集和分析。此外,由于这是一个自主组队测试平台,我们希望借此机会调查自主队友的特征,这将有助于研究人员正在计划的研究。

研究团队以我们的研究计划为基础,确定了研究人员可能提供有用信息的各种主题。根据这些知识征集目标,研究小组开发并审查了一系列开放式和李克特式问题,这些问题将使我们能够收集有关人类-人工智能团队合作研究界的信念和优先事项的见解。按照我们的内部质量保证流程,首席研究员在 Survey Monkey 交付工具中 "撰写 "了调查问卷。在发布调查问卷之前,我们进行了一次试点测试,在测试过程中,一名人工智能团队研究人员完成了调查问卷,并就调查问卷的内容提供了反馈意见。通过试点测试,我们采用了不同的方法来组织每个调查主题的问题;我们采用的策略是,要求受访者对每个调查主题的经验进行概括描述,然后通过提出更具体的开放式问题和封闭式李克特类型问题来进一步探究。例如,当问及科技教育中的数据收集时,调查要求受访者列出他们有兴趣收集的有关人类-人工智能团队研究的变量。在列出变量后,受访者被要求用 1(非常不同意)到 5(非常同意)的等级来评定他们对 STE 中特定变量和其他数据收集相关功能的重要性的同意程度。调查的每个子部分最后都会询问参与者有关该主题的其他想法、意见或问题。

试点测试结束后,研究团队向来自大学和政府研究实验室的 19 名人类-人工智能团队研究人员发布了调查问卷。每位研究人员都收到了一个独一无二的链接,如果需要,他/她可以在多个会话中完成调查。通过这些唯一链接,我们还可以监控受访者完成调查的进度。首席研究员还发送了提醒邮件,以提高回复率。最终,11 位受访者完成了部分调查,8 位受访者完成了整个调查。

答复期结束后,研究小组从 Survey Monkey 上下载了调查结果,以便进行离线分析。调查结果的分析分为两个部分。首先,两位主要研究人员对每个开放式问题的回答进行了独立的主题分析。在这些分析中,每位研究人员都会查看受访者对每个问题的回答,并将其记录为一个简短的短语/主题。这样做的目的是找出在不同答案中反复出现的观点,即使受访者使用了不同的措辞。完成独立分析后,研究人员共同在各自的列表中达成共识,以创建一个主列表。然后,我们将个人回答与共识列表进行映射。

其次,在对开放式问题进行定性分析的同时,研究团队还对各种李克特项目进行了定量分析。这些分析侧重于描述性统计,总结了受访者的回答分布情况。然后,主要研究人员在本技术报告中记录了调查结果以及我们对这些结果的解释。研究团队对报告进行了内部质量保证,将其存档,并分发给利益相关者(包括调查对象)。以下各节总结了我们收到的与 STE 各要素相关的意见。原始调查答复见附录 A。