随着人工智能(AI)技术越来越多地融入我们的日常生活,人们不禁要问,人工智能会带来哪些风险,会对人类和社会产生负面影响还是积极影响?要确定具有先进能力的人工智能模型是否会带来风险、如何带来风险以及会给谁带来风险,都是很困难的。人工智能行动者需要详细的信息来了解风险,并决定是否在特定情况下采购、部署或使用人工智能。

ARIA(Assessing Risks and Impacts of AI,人工智能风险与影响评估)是美国国家标准与技术研究院(NIST)的一项评估驱动型研究计划,旨在开发能够说明人工智能在现实世界中的风险与影响的测量方法。该计划建立了一个实验环境,以收集人们在受控的真实世界条件下使用人工智能时会发生什么的证据。与目前依赖概率和预测的方法不同,ARIA 将能够直接观察人工智能系统的行为和对用户的潜在影响。ARIA 在围绕特定人工智能风险设计的场景互动中,将人与人工智能应用程序配对,并对结果进行研究。应用程序由全球各地提交给 NIST,并根据风险是否在场景中实现以及所造成影响的规模和程度进行评估。参与团队将了解他们的应用程序能否在测试环境的不同情况下保持功能。

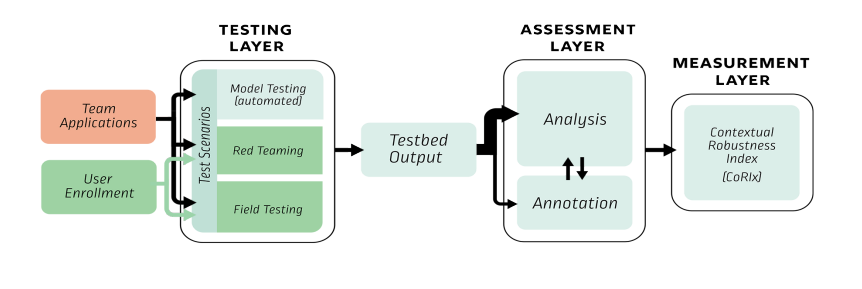

图 1 展示了 ARIA 实验环境的流程图,该环境可在人工智能风险和影响在用户交互过程中显现之前、期间和之后提供全面的视图。该环境的可配置设计可提供几乎无限数量的模拟,以填补人们在现实世界中使用人工智能技术时实际发生情况的缺失信息。最初,ARIA 将主要关注可通过用户与人工智能技术的交互直接观察到的风险。随着时间的推移,根据可用资源和 ARIA 研究社区的意见,该计划可能会扩展到研究更广泛的人工智能风险和相关影响,例如对劳动力的影响。

对人工智能应用的评估从 ARIA 的三级测试平台开始,其中每一级都使用不同的测试方法来探索潜在的风险和影响:

1.模型测试:确认声称的能力

2.红队:压力测试并尝试诱发风险

3.实地测试:检查在正常使用情况下可能产生的积极和消极影响

图 1. ARIA 的实验环境模拟了部署环境,以了解人工智能风险和影响是如何、何时以及对谁产生的。

接下来,ARIA 的评估层会对每个应用的试验台输出进行注释和分析,以确定风险是否在交互中具体化,并描述结果的特征。最后,在测量层中使用上下文稳健性指数(或 CoRIx)计算应用结果,该指数是 ARIA 的测量工具和指标套件。CoRIx 衡量人工智能应用是否能在不同部署环境下保持稳健、可信的功能。

在 ARIA 环境中收集的对话将经过整理和匿名处理,并计划在每个评估系列结束后公开发布。公布 ARIA 的方法、指标、实践和工具将有助于在行业和研究环境中采用和推广。ARIA 的 CoRIx 工具和衡量标准套件也将合作开发和发布,以便广泛采用。

选定的 ARIA 计量术语如下:

-

评估: 对特定软件模块、软件包或产品应用特定记录标准的行为,目的是确定软件模块、软件包或产品的验收或发布[2]。

-

基准:(i) 可衡量或评估结果的标准;(ii) 可用于将系统或组件与其他系统或标准进行比较的程序、问题或测试[2]。[2]

-

评价:(i) 系统地确定一个实体在多大程度上符合其特定标准;(ii) 评估某事物价值的行动[2]。

-

测量:(1) 定量测量是给一个实体分配一个数字或类别以描述该实体属性的行为或过程[2]。(2) 定性测量基于从观察、访谈、焦点小组或调查中的开放式文本字段中获得的描述性数据。