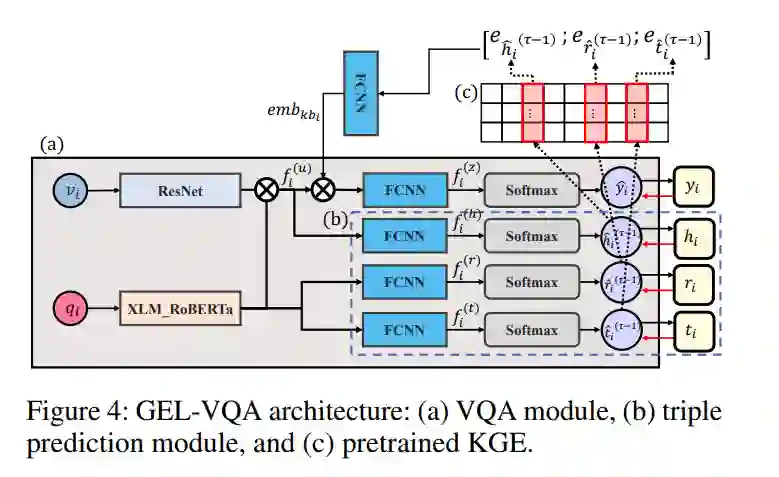

当前生成模型的研究方向,例如最近开发的GPT4,旨在为多模态和多语言输入找到相关的知识信息以提供答案。在这些研究环境下,对视觉问题回答(VQA)任务的多语言评估需求增加,VQA是多模态系统的代表性任务。因此,本研究提出了一个双语外部知识VQA(BOK-VQA)数据集,该数据集可以扩展到多语言。提出的数据包括17K张图片,针对韩语和英语的17K个问题-答案对,以及与问题-答案内容相关的280K条知识信息实例。我们还提出了一个框架,可以通过以图嵌入的形式对BOK-VQA数据的知识信息进行预训练,有效地将知识信息注入到VQA系统中。最后,通过深入分析,我们展示了构建的训练数据中包含的知识信息对VQA的实际效果。

成为VIP会员查看完整内容

相关内容

Arxiv

224+阅读 · 2023年4月7日