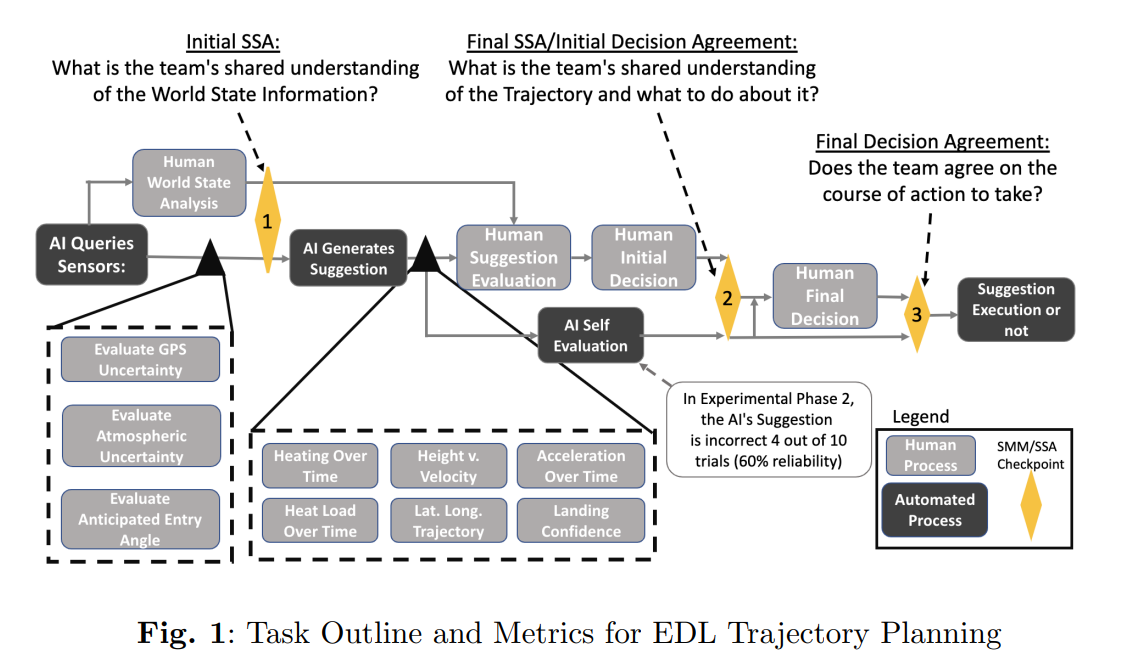

人工智能推荐系统通过向负责做出最终决策的操作人员提供建议,从而为决策支持提供帮助。然而,这些系统通常被认为是黑盒,在展示时往往没有任何背景或对底层算法的深入了解。因此,推荐系统可能会导致用户依赖性误判和态势感知能力下降。近期的工作主要集中在通过各种方式提高推荐系统的透明度,如改进推荐器对优点数字的分析和可视化,提供推荐器决策的解释,以及改进用户培训或校准用户信任度。在本文中,引入了另一种透明度技术,即调整向人类操作员展示上下文信息和推荐决策的顺序。这种技术旨在提高操作员的态势感知,从而提高操作员与推荐系统之间的共享态势感知。

本文介绍了一项分两个阶段进行的主体间研究的结果,在这项研究中,参与者和推荐系统共同做出了一项高风险决策。我们改变了参与者所掌握的情境信息量、优点数字的评估技术以及推荐系统的可靠性。我们发现,预先提供态势信息可以提高人类决策者的初步判断和最终判断,以及辨别推荐者错误边界的能力,从而提高团队的共同态势感知。此外,这项技术还准确地校准了人类操作员对推荐者的信任度。这项研究提出并验证了一种为人工智能系统提供模式识别透明度的方法,它可以为人类决策者提供支持,从而提高团队绩效。

讨论

本研究的基本前提是了解在设计推荐系统时,作为更全面认知过程的一部分,支持人类判断的重要性。我们通过评估提供任务环境上下文信息的影响来测试这一点,我们认为这将提高人类决策者的态势感知能力。此外,我们还专门调整了态势信息,使其与人工智能推荐系统在该任务领域中使用的信息相匹配,从而消除两个智能体之间的任何态势感知差异。我们将这种判断支持技术和共享态势感知与更常用的增加互动的建议评估支持技术进行了比较,以确定其对整体任务性能的相对影响。我们还增加了最后一次机会,让人类改变自己的评估,使之与人工智能推荐器的评估相一致,以了解提供判断支持和共享态势感知如何消除自动化偏差。最后,我们进一步评估了附加任务对脑力劳动负荷以及场景和学习信任的影响。

两个阶段的综合结果表明,无论人工智能伙伴的准确性如何,向人类提供任务环境的上下文信息都能提高他们与人工智能伙伴的团队表现。在第一实验阶段,人工智能任务计算机总是正确的,因此与人工智能达成一致等同于正确执行任务。第一阶段的结果表明,提供世界状态信息增强了共享态势感知,提高了团队表现。然而,我们从实验第二阶段(当人工智能任务计算机的准确率为 60%时)看到,当人工智能的建议不正确时,提供世界状态信息有助于调整人类的态势感知,从而调整团队的 SSA。这表明,无论智能体的可靠性如何,提供情境信息都是校准团队共享态势感知的有效技术。

世界状态感知似乎还能防止过度依赖自动化/人工智能队友。基线条件的结果表明,那些无法获得世界状态条件的人倾向于过度依赖人工智能伙伴来做出正确的决定。这一发现至关重要,因为从客观指标和主观指标可以看出,看不到世界状态信息可能会使人类的最终表现可以接受,并减少人类的努力、心理需求和挫败感,但最终会导致人类对自己的表现缺乏信心,并盲目服从人类无法理解的人工智能模型,这可能会导致灾难性的结果。相应地,提供任务环境的上下文信息有助于人类更好地理解其人工智能队友何时出错,该如何处理,并提高他们对自己任务表现的整体信心。

此外,将人类纳入决策制定过程的观察部分,为他们提供上下文信息也会增加他们的认知工作量。两个实验阶段的 TLX 数据都表明,人类在获得背景信息时需要付出更多的努力和心理需求。当与可靠的人工智能伙伴合作时,拥有上下文信息最终会减少任务的挫败感,而当人类与不可靠的人工智能伙伴合作时,挫败感则会增加。不过,在这两个实验阶段,获取世界状态信息都提高了人类自身对完成任务能力的信心。从整体上看,这些工作量结果表明,虽然人类在获得情境信息时需要付出更多,但这种技术最终会提高他们的客观表现,以及他们在与人工智能伙伴共同完成任务时的自我评估。

人类对人工智能的信任并不会因为情境信息的存在而受到影响,但会受到人工智能伙伴可靠性的影响。在实验阶段 1,不同世界状态认知水平的人对人工智能能力的信任度差异不大。然而,在实验第二阶段,随着世界状态意识的提高,对人工智能能力的信任度也在下降,尽管这种下降趋势在统计上并不显著。人类一旦发现人工智能的错误,就会降低对人工智能的信任度/宽容度,这一发现与目前的文献相符。

根据总体结果,我们可以看出,向人类提供情境信息并让他们参与决策过程的观察阶段,可以准确校准团队共享的态势感知,提高人类的整体任务绩效和他们对人工智能队友的心智模型,并在不增加太多工作量的情况下减少对自动化的过度依赖。

为了支持对建议行动方案的评估,我们在轨迹评估阶段引入了交互组件。增加互动的目的是迫使人类主动处理每个信息源。在实验阶段 1,我们发现确保人类理解轨迹建议的 "好坏 "并没有显著提高人类的表现,也没有提高队友之间的共享态势感知,这可能与现有文献相矛盾。然而,在实验阶段 2 中,那些与建议轨迹的优点数字进行互动的人比那些仅仅观察人工智能建议的人拥有更准确的团队 SSA 和最终表现。此外,在这两个实验阶段中,TLX 数据的总体趋势表明,与仅仅观察轨迹特征相比,交互部分往往会导致更差的用户体验。由于现实世界中的自动化系统都不可能完美无瑕、100% 准确地输出结果,这一重要发现表明,在人工智能输出/建议中加入交互是一种有效的技术,可以在人工智能团队成员不可靠的现实世界中提高 SSA,尽管人类体验较差。不过,需要注意的是,这种技术在提高团队 SSA 和最终绩效方面并不具有统计学意义,因此,仅靠支持对建议行动方案的评估还不足以抵消黑盒现象的隐患。

这项研究提供了一些证据,证明为人类决策者定位、调整人类对世界的理解以匹配其队友(在本例中为人工智能队友)的理解,以及不仅为决策而且为认知过程中的判断要素提供支持的重要性。不过,这项研究因评估任务的简单性而受到限制。它的局限性还在于,人工智能所犯的错误都是有风险的,是为了让人类决策新手能够发现。这里的参与者也都是新手,而且只在团队中工作了很短的时间--这可能限制了信任度指标的发现。重要的是,尽管我们在设计实验时认为,通过提供情境信息,态势感知应该会增加,但我们无法明确验证这一点,因为我们并没有在不同处理中测量相同的指标(例如,我们没有办法明确测量那些没有看到世界状态也没有与优点人物互动的人的态势感知)。但根据最终做出的决定,我们知道,随着世界状态意识的提高,团队的表现也会提高。由于我们从 SMM 文献中了解到,高绩效团队会利用 SMM,因此我们可以将绩效的提高归因于 SSA 的提高,而 SSA 是我们通过添加上下文信息的技术实现的。最后,我们不能将 SSA 的影响与我们对人类心智模式的最佳猜测分开。