我们给出了一个关于调查透明度和可解释性的前沿教程,因为它们与NLP有关。研究团体和业界都在开发新的技术,以使黑箱型NLP模型更加透明和可解释。来自社会科学、人机交互(HCI)和NLP研究人员的跨学科团队的报告,我们的教程有两个组成部分:对可解释的人工智能(XAI)的介绍和对NLP中可解释性研究的最新回顾; 研究结果来自一个大型跨国技术和咨询公司在现实世界中从事NLP项目的个人的定性访谈研究。第一部分将介绍NLP中与可解释性相关的核心概念。然后,我们将讨论NLP任务的可解释性,并对AI、NLP和HCI会议上的最新文献进行系统的文献综述。第二部分报告了我们的定性访谈研究,该研究确定了包括NLP在内的现实世界开发项目中出现的实际挑战和担忧。

自然语言处理中可解释AI的现状调研

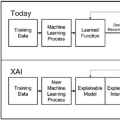

近年来,最领先的模型在性能上取得了重要的进步,但这是以模型变得越来越难以解释为代价的。本调研提出了可解释AI (XAI)的当前状态的概述,在自然语言处理(NLP)领域内考虑。我们讨论解释的主要分类,以及解释可以达到和可视化的各种方式。我们详细介绍了目前可用来为NLP模型预测生成解释的操作和可解释性技术,以作为社区中模型开发人员的资源。最后,我们指出了在这个重要的研究领域目前的挑战和未来可能工作方向。

https://www.zhuanzhi.ai/paper/377e285abccf56a823a3fd0ad7a3f958

成为VIP会员查看完整内容

相关内容

一个可以解释的AI(Explainable AI, 简称XAI)或透明的AI(Transparent AI),其行为可以被人类容易理解。它与机器学习中“ 黑匣子 ” 的概念形成鲜明对比,这意味着复杂算法运作的“可解释性”,即使他们的设计者也无法解释人工智能为什么会做出具体决定。 XAI可用于实现社会解释的权利。有些人声称透明度很少是免费提供的,并且在人工智能的“智能”和透明度之间经常存在权衡; 随着AI系统内部复杂性的增加,这些权衡预计会变得更大。解释AI决策的技术挑战有时被称为可解释性问题。另一个考虑因素是信息(信息过载),因此,完全透明可能并不总是可行或甚至不需要。提供的信息量应根据利益相关者与智能系统的交互情况而有所不同。

https://www.darpa.mil/program/explainable-artificial-intelligence

Arxiv

4+阅读 · 2019年5月6日