虽然深度学习技术在雷达图像处理任务中获得了部分应用, 但缺乏对黑盒模型的可解释性分 析和全面的性能评估, 限制了该技术在雷达图像领域中的应用性能、可信度和广泛性. 本文从可解释 性入手, 提出了雷达图像深度学习黑盒模型分析思路, 在开源 MSTAR 雷达图像数据集上进行实验验 证. 从深度学习模型的迁移机制和认知机理两个方面进行分析, 得到了关于迁移学习、归因方法应用 和模型鲁棒性评估方面的相关结论, 填补了现有研究的空白.

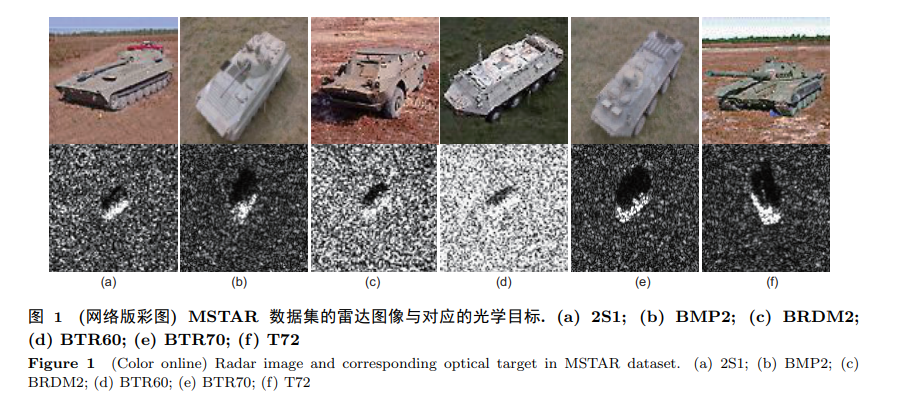

近些年来, 深度学习技术正逐步从光学图像领域应用到雷达图像领域, 在雷达目标识别、场景分 类和目标检测等雷达图像处理任务中取得了部分研究成果 [1, 2] . 目前深度学习模型在以上任务中表现 出了优良性能, 但仍存在一些尚待研究的问题. 一是需要根据雷达与光学图像的显著差异性, 进一步解释深度学习模型在雷达图像领域中的迁移 机制, 指导雷达图像深度学习模型的优化设计. 由于雷达与光学成像机理不同, 所得到的图像为目标 散射点分布. 如图 1 所示, 在 MSTAR 数据集 [3] 中表现为呈离散分布、强度不同的散射点, 与所对应 的光学图像之间存在明显差异. 将在光学图像领域中取得成功应用的深度学习模型迁移到雷达图像领 域时, 应当充分考虑这种差异性. 文献 [2] 梳理了小样本条件下基于迁移学习的雷达图像目标识别方 法, 部分研究针对两者的差异性设计了相应方法提高目标识别率, 但缺乏对其迁移机制影响的深入分 析, 可解释性研究有望为深度学习模型在雷达图像领域中的设计与优化提供全新的视角和知识. 二是由于雷达图像目标之间、目标与背景之间具有较强相似性, 需要对深度学习模型认知机理的 分析评估, 保证其在实际任务中的应用性能和可信度. 如图 1 所示, 这种相似性给人的认知和理解带来了极大的困难, 需要分析模型是否正确表征了目标信息. 目前对于模型的分析评估大多依赖于识别 率, 对实际任务而言, 识别率是对问题的不充分描述, 这可能会使得模型出现错误, 例如模型利用背景 信息的相关性提高识别率. 文献 [4] 提到华盛顿大学 (University of Washington) 的一项实验, 旨在创建 哈士奇与狼的识别器, 但模型实际上是根据背景是否存在积雪来进行识别的, 学习到的是背景干扰与 识别结果的强相关性, 而不是目标特征与识别结果之间的因果性. 文献 [5] 同样指出, 在测试集上的高 识别率并不能保证模型学习到正确的特征表征. 仅靠识别率等性能指标不能保证模型在实际任务中正 常工作, 也不能满足在某些关键任务 (如医疗、交通和军事等) 中人们的认知和决策需要. 因此, 只有 对深度学习模型认知机理的分析说明和识别结果的可信解释, 才能提高人们对于其黑盒模型的信任, 保证人们依靠其作出相应决策.

针对以上两个问题, 本文将使用可解释性方法 [6, 7] 作为分析工具从两方面展开研究. 一是通过可 解释性方法对比分析雷达和光学图像对深度学习模型的影响, 获取其黑盒模型内部知识, 解释深度学 习模型迁移机制, 从而进一步理解应用深度学习技术. 二是通过主观分析和客观指标评估可解释性方 法和深度学习模型, 从而在准确性和鲁棒性方面得到可信结论, 以此对其黑盒模型的认知机理作出分 析评估, 为实际决策提供帮助. 目前可解释性方法可分为事后解释 (post-hoc) 方法和事前设计 (ante-hoc) 方法. 事后解释方法 针对已经训练好、不具备可解释性的黑盒模型进行研究, 通过可视化展示模型内部结构、基于归因 方法 (attribution algorithms) 分析模型识别重点、使用特定输入研究模型、比较不同模型结构性能 等方式, 挖掘模型内部知识和解释模型认知机理. Zeiler 等 [8] 提出反卷积 (deconvnet) 的分析方法. Simonyan 等 [9] 提出两种基于梯度的分析方法. Szegedy 等 [10] 通过单元分析方法探索神经元的语义 信息, 并发现了对抗样本. Frankle 等 [11] 提出乐透假设 (lottery ticket hypothesis) 发现训练成功的大 型网络中包含一个相同性能的稀疏子网络. 事前设计方法构建具有明确语义或物理信息的模型, 可将在数学物理上具有明确意义的方法与深 度学习模型相结合, 提高模型的可解释性. 如通过知识蒸馏结合神经网络和结构化的逻辑规则 [12] ; 利 用注意力机制同时生成图像和文本解释 [13] ; 贝叶斯 (Bayes) 深度学习将深度学习模型的感知能力和 贝叶斯模型的因果逻辑推理能力相结合 [14] ; Gu 等 [15] 基于最优传输理论得到了半透明的生成对抗网络. 事前设计方法也可设计本身在语义、物理等层面上具有可解释性的模型. Sabour 等 [16] 提出胶囊 网络 (capsule network) 模型, 胶囊单元不同维度表征了手写数字的语义信息; Zhang 等 [17] 设计了一 种带有可解释性的卷积核. 当前, 有关雷达图像领域的深度学习可解释性方面研究较少. 郭炜炜 [18] 讨论了关于合成孔径雷 达 (synthetic aperture radar, SAR) 图像目标识别的可解释问题, 从模型理解、模型诊断和模型改进等 方面进行了初步探讨, 但暂无对雷达图像深度学习黑盒模型可解释性的具体实验研究. 本文结合目前深度学习可解释性方面的研究进展, 以雷达目标识别任务为例, 在 MSTAR 的 SAR 图像数据集上进行事后解释方法的实验分析, 实验结果有效揭示了深度学习模型在雷达图像领域中的 迁移机制和认知机理, 并且详细地提供了相应的分析思路和结论, 填补了当前对雷达图像深度学习黑 盒模型可解释性的研究空白. 主要贡献如下: (1) 基于事后分析方法提出了雷达图像深度学习黑盒模型分析思路, 为可解释性方法在雷达图像 领域中的应用奠定基础; (2) 通过实验比较分析了雷达和光学图像对于模型内部的影响, 得到了关于深度学习在雷达图像 领域中迁移机制的分析结论; (3) 通过归因方法分析了深度学习黑盒模型的认知机理, 从可解释性角度提出了 SAR 目标识别模 型鲁棒性评估的新方法.

本文后续结构组织如下: 第 2 节介绍相关工作, 第 3 节面向雷达图像领域提出深度学习黑盒模型 分析思路, 第 4 节依据所提思路进行实验验证, 第 5 节对全文总结并提出下一步研究方向.