2022最新177页博士论文《基于大型知识库进行问答的非参数化上下文推理》马萨诸塞大学阿默斯特分校

第一章 引言

-

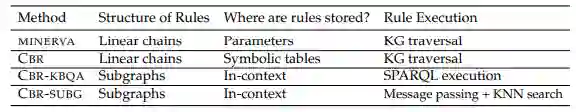

目前的质量保证和知识库完成模型通常是黑盒式的评分函数,学习实体和关系的固定词汇的向量表示(9;155;162;55)。模型的参数同时存储了逻辑和知识,使得模型所使用的底层推理过程不透明,也不清楚。 -

可以向质量保证系统提出的问题类型基本上是没有限制的,因此,模型必须学习并存储在其参数中的推理模式类型是巨大的。此外,在训练过程中,一个模型可能只遇到每种问题类型的几个训练实例。我们表明,KBQA的参数化模型在这样的环境中很困难(29)。 -

我们生活在一个不断发展的世界中,有很多异质性,同时新的实体和关系也在不断被创造。例如,描述新实体事实的科学论文和维基百科页面被不断添加。这些新的发现进一步引发了更多新的事实的推论,每一个事实都有其不同的推理。由于固定的预定义词汇,目前的知识库完成模型不能处理新增加的实体和关系,也不能对新数据进行推理。 -

随着我们观察到新证据(数据),人类的推理过程变得更加细微,即新的推理规则出现,现有的推理规则随着新数据的加入而演变。目前还不清楚如何稳健地更新深度神经模型的参数来编码更新的(和新的推理规则)。正如我们在论文后面所显示的,模型在对新到的数据进行训练时,往往会出现灾难性的遗忘,即模型已经忘记了它之前所学的东西(28;31)。 -

最后,当模型对一个给定的问题输出错误的预测时,它们为我们提供的见解和对错误预测的调试控制非常有限(31)。我们表明,非参数模型让我们有新的机会来修复错误的模型预测,让我们向KNN记忆 "注入 "案例,使模型更有可解释性和可控性。

1.1 期望

-

适用于新加入的数据。我们需要能够与动态世界无缝推理的模型。这意味着模型应该能够处理新的实体和关系,以及随着新数据的加入而出现的新的(潜在的)推理规则。 -

准确地回答需要复杂推理模式的各种自然语言查询。知识库的自然语言界面为存储在其中的信息提供了一种用户友好的访问方式。自然语言查询还允许我们提出更复杂的问题,这些问题很难用单一的知识库关系来表达。此外,看似简单的问题可能需要涉及KB中多个事实的复杂推理(例如,居里家族的成员获得了多少诺贝尔奖?) 回答许多这样的问题所需要的推理模式是子图的形状,而且往往比简单的推理链更复杂。我们需要能够对复杂的(潜在的)子图图谱进行所需的推理的模型,以准确回答此类问题。 -

具有可控性和可调试性的可解释推理过程。目前的QA和KB完成模型作为黑盒的功能,对其推理过程提供了有限的见解。此外,当它们对一个查询输出错误的预测时,除了在失败的输入上重新训练模型外,我们没有什么可以做的。我们需要的模型不仅在如何得出查询的答案方面提供更多的透明度,而且是可控制和可调试的,对如何修复错误的模型预测提供更好的洞察力。

1.2 已完成的工作总结

1.3 本文背景下的推理

1.4 本文组织

专知便捷查看

便捷下载,请关注专知人工智能公众号(点击上方蓝色专知关注)

后台回复“QAKG” 就可以获取《2022最新177页博士论文《基于大型知识库进行问答的非参数化上下文推理》马萨诸塞大学阿默斯特分校》专知下载链接

登录查看更多

相关内容

Arxiv

23+阅读 · 2019年12月12日