本文介绍由兰州大学黎育权和腾讯量子实验室谢昌谕博士等人发表在Nature Machine Intelligence期刊上的研究成果,论文通讯作者为姚小军教授。文章中报道了一种自动图学习方法,能够在人工不参与的情况下,在多种不同任务上取得先进的预测性能,超越过去的主流模型。作者还提出一种新的分子鲁棒性实验方法,并发现模型集成能够大幅提升鲁棒性。

1 研究背景

药物发现是一个耗时、昂贵和复杂的过程,在人类健康和福祉中发挥着至关重要的作用。机器学习方法,尤其是图学习方法有可能显著提高药物发现效率。它们能从现有药物相关数据集中进行学习,从而来预测分子相互作用和性质。同时,这也是机器学习能够从广阔的化学空间中以极快的速度和低成本寻找潜在候选药物的关键所在。

然而,在少部分数据集上追求高预测性能已经固化了它们的架构和超参数,这使得它们在新数据的利用上不在有优势。这种固化限制了他们在新数据上的学习能力和应用,使得他们的性能变得平庸。此外,大多数图学习方法严重依赖深度学习的专家知识来实现其声称的最先进结果。当作者不给出这些具体的神经网络架构和参数的时候,后来的研究人员甚至无法复现他们的模型性能。

这项工作提出了基于图学习的自适应机器(Graph learning based adaptive machine, GLAM),它可以适应数据集并在无需人工干预的情况下做出准确的预测。

2主要贡献

(1)提出一种自动机器学习方法,可以同时应用于分子属性预测、药物-蛋白相关关系预测、药物-药物相互作用预测。

(2)在相对公平比较的情况下(相同数据集分割),对比目前主流模型并取得最佳性能,包括分子属性预测任务,药物-靶标相关关系预测任务。 (3)提出一种合理的图模型鲁棒性测试方法,并发现集成模型比单模型的鲁棒性好。

3 方法

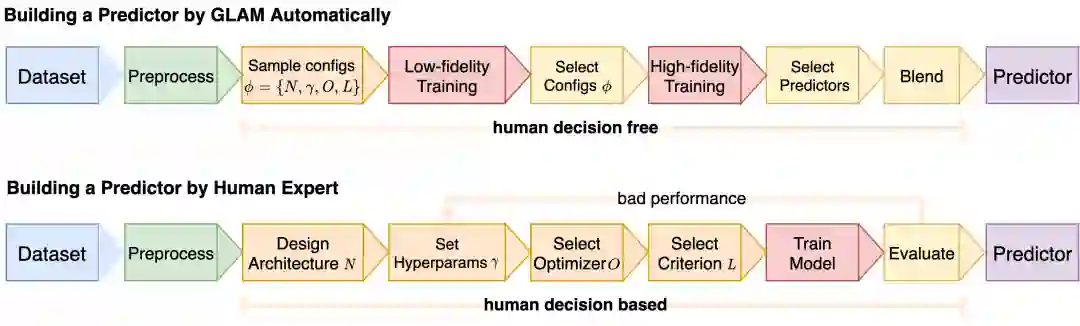

本文的方法跟过去的设计一个图网络不同,本文利用自动化的流程从数据集中学习并逐步建立一个预测器,如图 1 和图2所示。以前的图学习方法严重依赖人类专家来设计架构、调整模型超参数、选择优化器和选择损失函数。本文将这四个项目组合成一个配置,并将潜在的配置放入一个配置空间。从这个配置空间开始,GLAM 执行一系列步骤来构建预测器,如图 2 所示。GLAM首先从配置空间中采样了很多配置。然后将数据集喂给到这些配置以进行低保真训练,从而得到验证集分数以便于选择性能高的配置。低保真训练是指少量轮次的快速训练,从而得到所有配置的验证分数以快速估计他们的预测性能。高保真训练是指使用巨量的轮次(带早停)来精准地估计所选配置的预测性能。最后,将所有选定的预测器集成并建立一个最终预测器。

图1. GLAM和传统方法的对比.

图 2. GLAM 具体流程图.

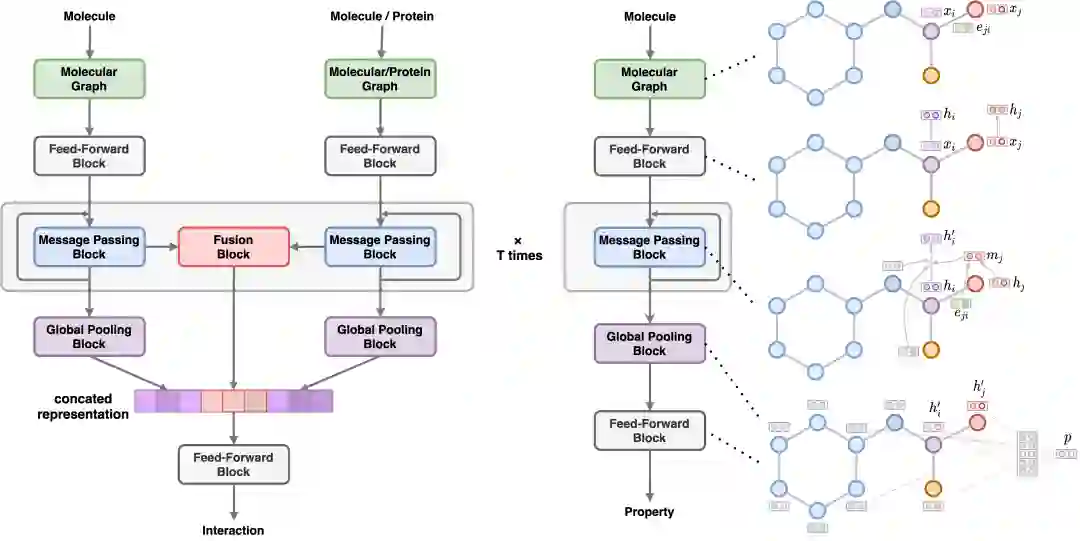

本文设计了两种通用架构,一种用于分子相互作用,另一种用于分子性质,如图 3 所示。通用架构中的每个模块都有自己的设计空间,如图 4 所示。这些神经网络架构接受的输入都为图,包括分子图和蛋白图。本文以原子为节点,以键为边建立分子图。对于蛋白图,本文首先使用RaptorX计算得到接触图(contact map),然后以氨基酸残基为节点,以接触图提供的信息作为边建立蛋白图。DTI任务同时考虑分子图和蛋白图作为输入。DDI任务考虑两个分子图同时作为输入。分子性质预测则接受单分子图作为输入。

图 3. 应用于DTI和分子性质预测的神经网络架构.

3 结果和讨论 3.1适应数据集并取得高性能 GLAM是为了适应数据集以获得高预测性能而设计的。为了考察该方法的适应性和性能,本文在14个数据集上与一系列具有代表性的传统方法进行了性能比较。测试数据集的类型包括药物-蛋白质相互作用、药物-药物相互作用、物理化学性质、生物活性、药代动力学和毒性。考虑到不同的数据集分割会导致不同的性能,本文让所有的方法共享相同的数据集分割,以获得公平的评价。为了体现GCN,GAT,MPNN在不同架构和参数的差异,本文还尽量使用人工的方式优化架构并调整参数,以达到在某个数据集上达到最佳性能,以便于对比其适应性。最后,本文在这些数据集上运行基准测试。

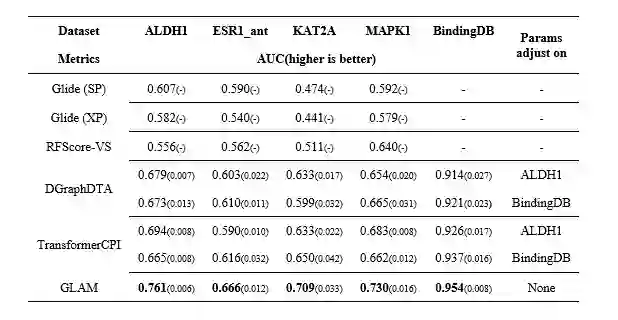

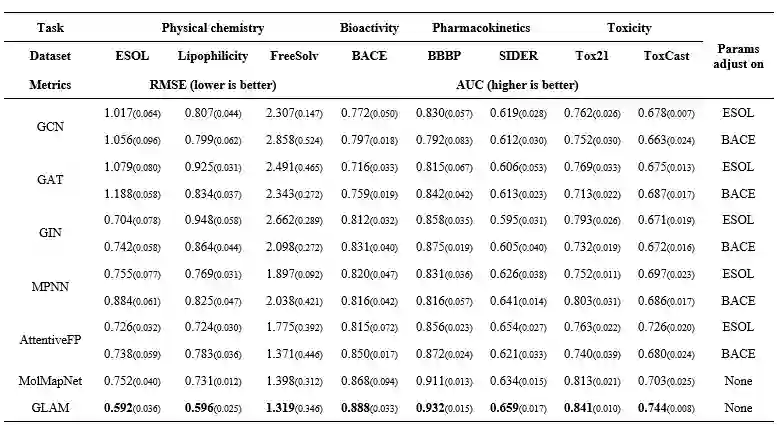

与所有传统方法相比,本文提出的方法能够很好地适应数据集,并取得了良好的预测性能,如表1、表2和表3所示。传统方法在不同数据集上固化下来的架构和参数表现出乘次不齐的性能,而GLAM可以在没有人为干预的情况下始终如一地获得最好的分数。因此,GLAM准备成为一种灵活、可靠和值得信赖的方法,在药物设计的广泛应用中都能很好地发挥作用。

表1. DTI任务上的性能对比

注:以上所有方法测试基于相同数据集分割。

表2. 分子性质预测任务上的性能对比

注:以上所有方法测试基于相同数据集分割,分割方式为基于scaffold的随机分割。

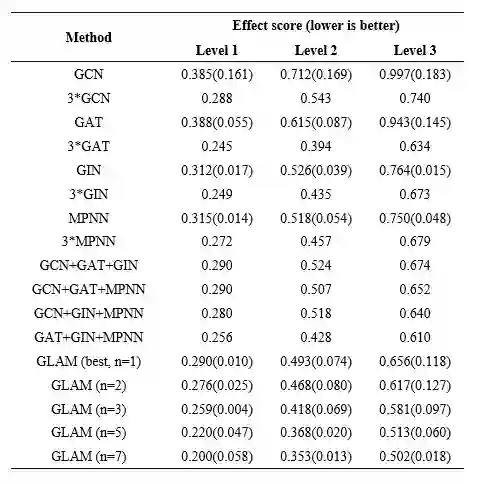

3.2面对分子结构扰动表现出高鲁棒性 本文认为鲁棒性也是衡量一种方法是否优秀的重要指标。本文假设,当施加对分子性质影响很小的结构扰动时,一个鲁棒的预测器不应显著改变其输出。机器学习方法可能受到各种自然干扰的影响,如果这样的干扰发生在一些安全敏感型行业(如医疗),后果可能是灾难性的。如图4所示,本文跟多个主流模型进行了对比。GLAM 的鲁棒性很可能是由于在流程末端的模型集成。集成的主要思想是训练几个模型,通过平均得到最终的预测。扰动分子结构可能会影响单个预测器,但不太可能会显著影响混合模型。更多关于鲁棒性实验的细节见论文原文。

表4. 鲁棒性实验

4 总结 本文提出了一种灵活的方法,可以适应任何数据集并做出准确的预测。所提出的方法采用自适应的自动机器学习流程从数据集中学习并得到一个高性能,高鲁棒的预测器。在没有任何人工干预的情况下,该方法在所有测试数据集上实现了比基于手工设计的的传统方法更好的预测性能。此外,本文发现所提出的方法比传统方法更鲁棒。这是第一个为分子数据设计的自动图学习方法。它的出现能够为新出现的全新数据赋能,即使充分利用好这些新数据。

参考资料 Li, Y., Hsieh, CY., Lu, R. et al. An adaptive graph learning method for automated molecular interactions and properties predictions. Nat Mach Intell (2022). https://doi.org/10.1038/s42256-022-00501-8