神经架构搜索

·

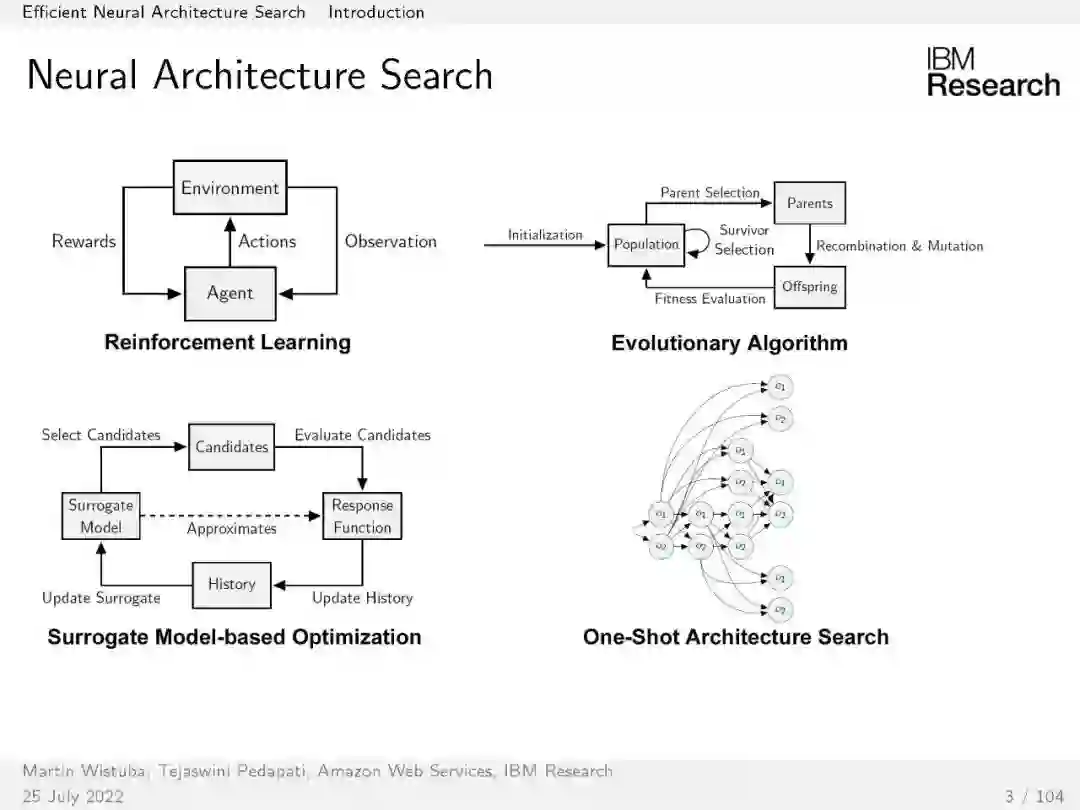

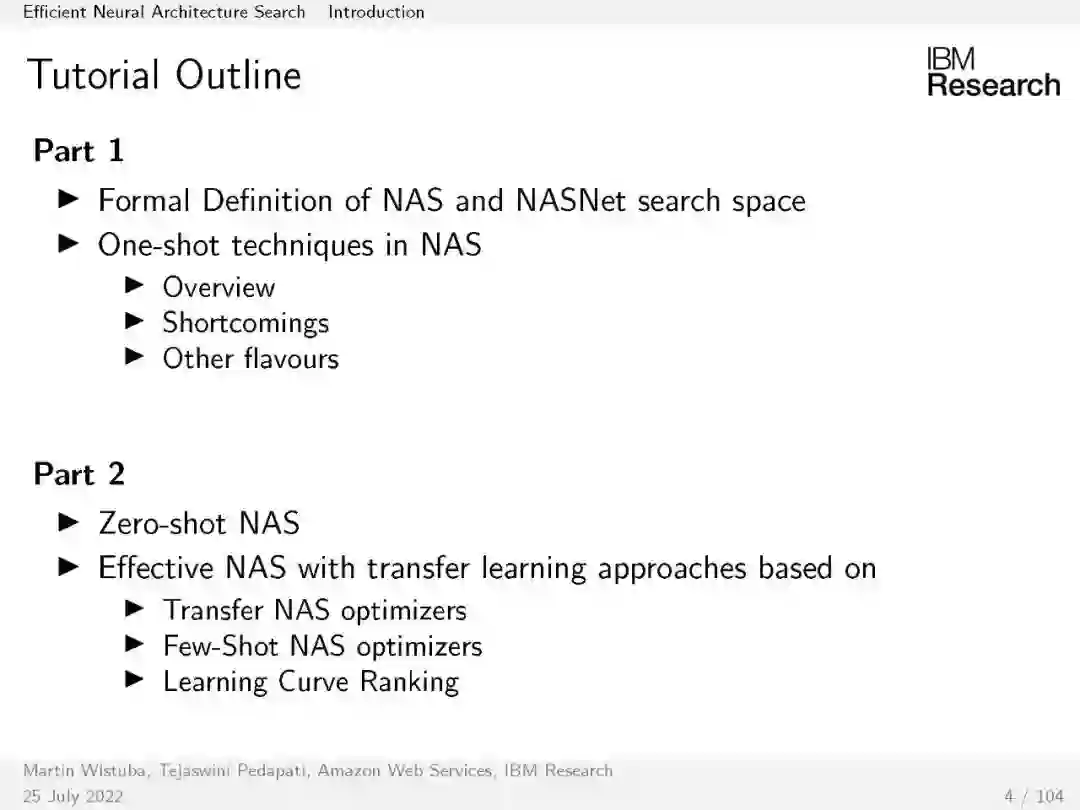

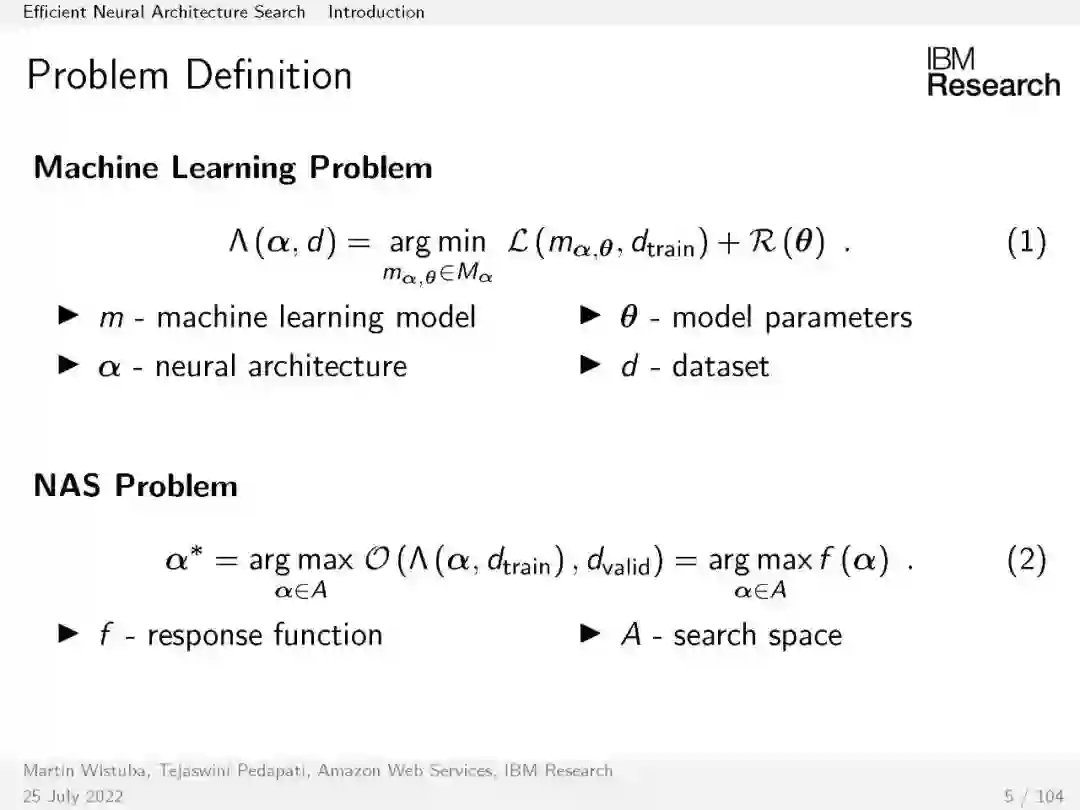

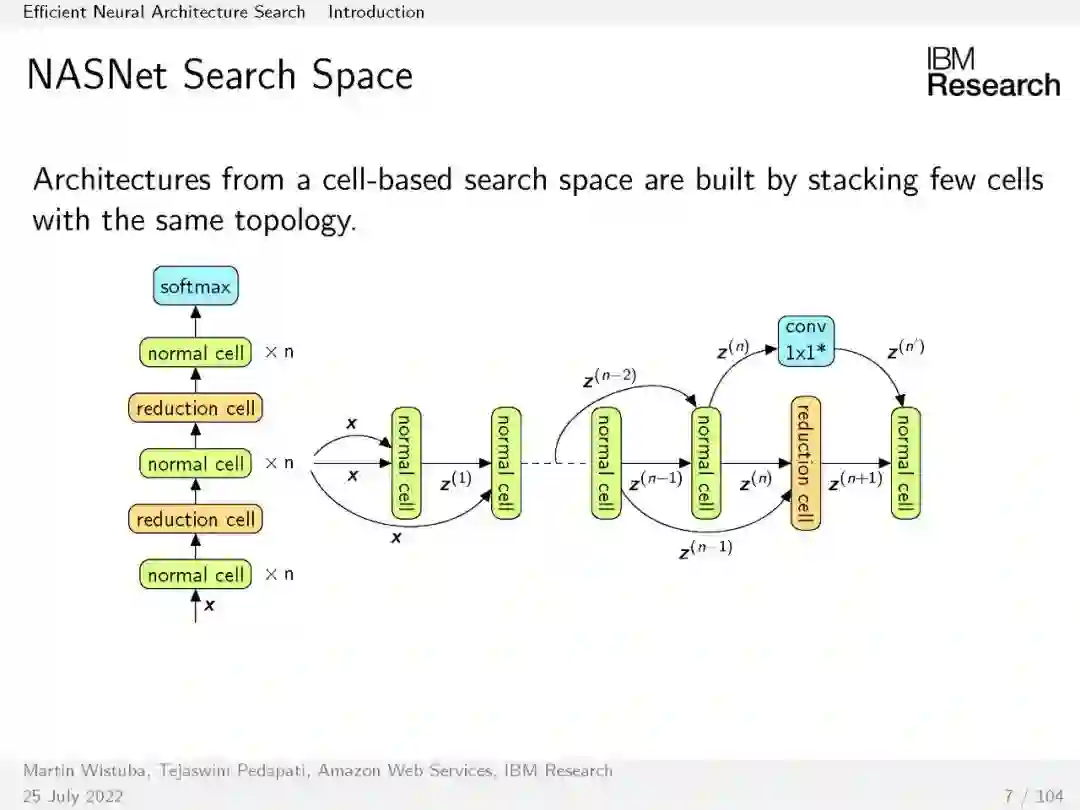

深度学习自动化的兴趣日益增长,导致了神经体系结构搜索的各种自动化方法的发展。然而,最初的神经架构算法是计算密集型的,需要好几天的GPU时间。训练候选网络是搜索过程中代价最高的步骤。接下来的几个算法提出了在候选网络之间共享参数,而不是从头开始训练每个候选网络。但是这些参数共享算法也有其自身的缺陷。在本教程中,我们将概述一些一次性算法、它们的缺点以及如何对付它们。后来的进步通过使用零样本、少样本和迁移学习等技术训练更少的候选者来加速搜索。通过使用随机初始化的神经网络的一些特性,一些搜索算法能够找到性能良好的模型。有些方法利用了迁移学习,而不是从头开始寻找。在本教程中,我们将介绍几种加速神经体系结构搜索的算法。

成为VIP会员查看完整内容

相关内容

Arxiv

0+阅读 · 2022年10月6日