给定一个机器学习模型,在近似、估计和优化误差的收敛速度不会随着维数的增加而恶化的意义上,什么样的函数可以用这个特定的模型有效地逼近?我们针对三类机器学习模型解决这个问题:随机特征模型,两层神经网络和残差神经网络模型。在此过程中,我们还将总结深度学习理论基础的现状,并讨论一些关键的开放性问题。

鄂维南,中国科学院院士,北京大数据研究院院长、北京科学智能研究院(AI for Science Institute,Beijing)院长,北京大学国际机器学习研究中心主任,美国数学学会、美国工业与应用数学学会 Fellow。研究领域为应用数学。多次受邀在数学、应用数学、物理、化学、力学等领域的国际顶会上发表报告。2003 年获国际工业与应用数学协会 Collatz 奖。2009 年获美国工业与应用数学学会 Kleinman 奖。2014 年获美国工业与应用数学学会 Theodore von Karman 奖。2019 年获得美国工业与应用数学学会和 ETH 共同颁发的 Henrici奖。2020 年获 ACM Gordon Bell 奖。

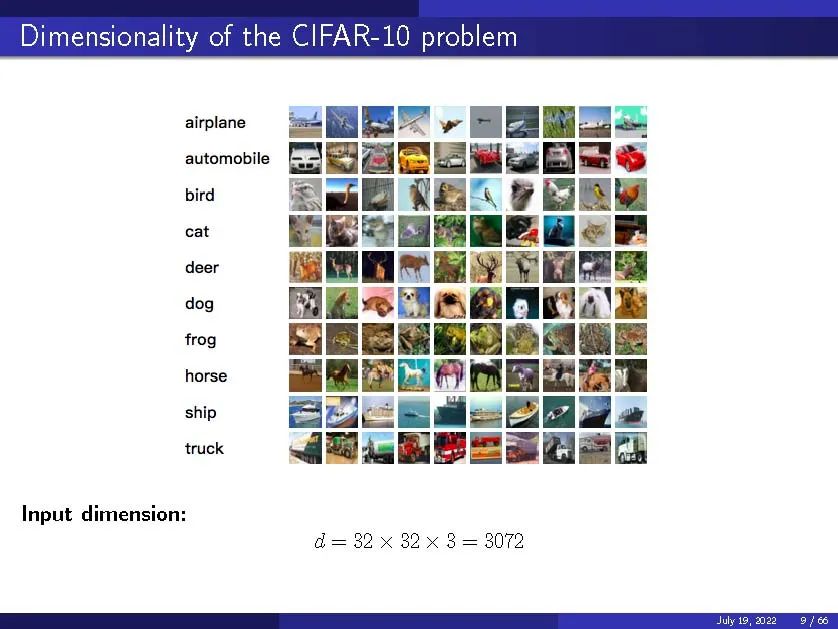

本演讲回顾了基于神经网络的机器学习数学理论领域的现状。他工作的中心主题是对高维函数的理解。他一开始就说,“机器学习是解决一些标准的数学问题,但是在非常高的维度上”。在数学的这个背景下,人们可以认为监督学习是使用有限的训练集逼近目标函数。使用图像分类的例子,我们感兴趣的函数是将每个图像映射到其类别的函数。我们知道函数在有限样本上的值(标签),目标是找到函数的精确逼近。

再举一个例子,在数学术语中,无监督学习是一个使用有限样本逼近潜在概率分布的问题。无监督学习的一个典型问题是生成不存在的数据,比如生成假人脸。虽然概率分布还不清楚,但我们确实有有限的真实人脸样本。用这个有限的样本,我们可以近似未知的概率分布,并产生新的样本。在其他机器学习方法中,强化学习是关于求解相关马尔可夫决策过程的Bellman方程,而时间序列学习则是关于逼近动态系统。

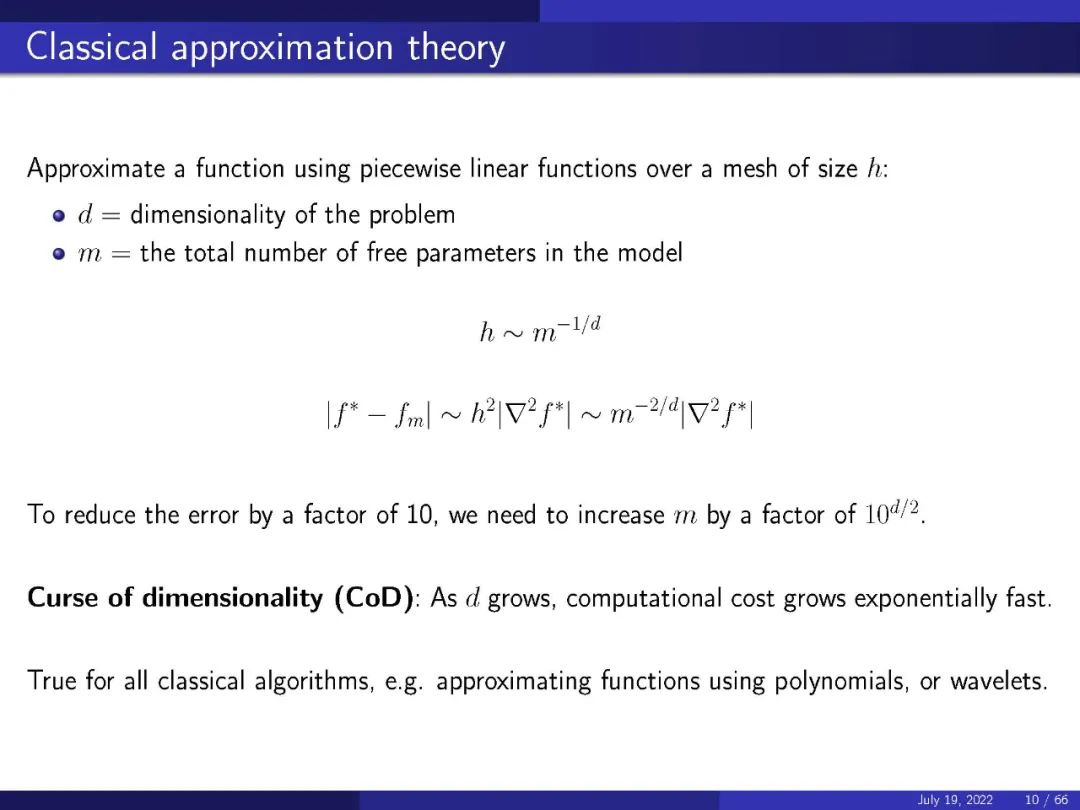

多年来,计算数学家一直在解决这类问题。唯一的区别是维度。以CIFAR-10问题为例,我们感兴趣的函数是将每个图像映射到其类别的函数。每个图像是32 x 32像素,有三个颜色维度,所以这个问题的整体维度是3072。这给经典的近似理论带来了一个问题(人们通常会在网格上使用分段线性函数逼近一个函数),因为随着问题的维数增长,计算成本呈指数增长。这对于所有用多项式近似函数的经典算法都是正确的。神经网络可以更有效地解决这类问题。

在他的演讲中重点讨论了一些关于基于神经网络算法的不同方面的证明,包括监督学习中的错误,随机特征模型,两层网络的近似理论,基于梯度的训练,以及在无监督学习中近似概率分布。

他总结说,虽然还有很多事情需要理解,但在高维近似理论和训练后期阶段的全局最小选择都有一个合理的视角。他强调,这项工作不仅仅是证明定理——还需要其他方法,比如仔细设计数值实验和渐近分析。

视频: