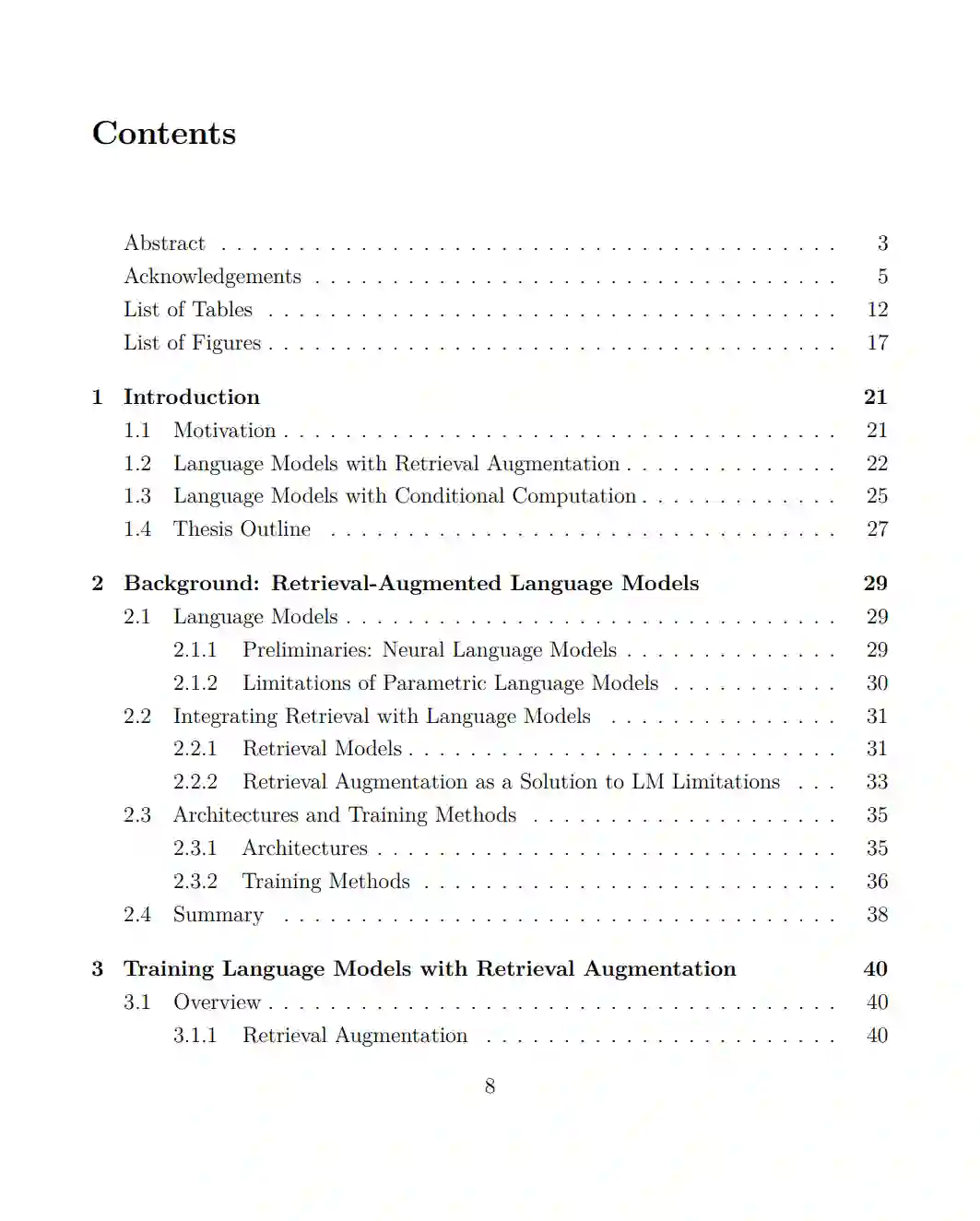

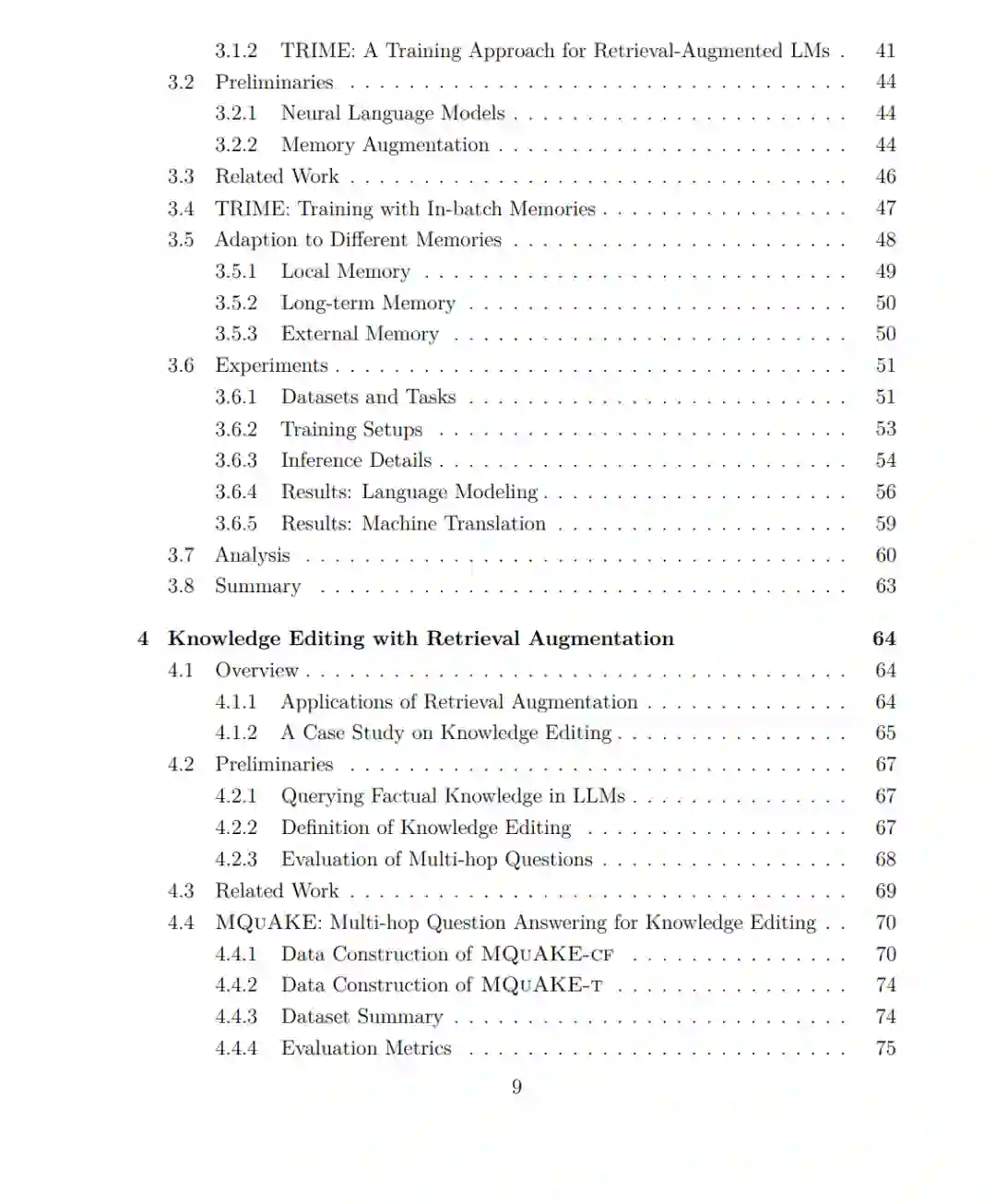

近年来,大型语言模型(Large Language Models, LMs)的研究主要集中于扩大模型参数规模和训练数据量,这虽然能显著提升性能,却也带来了高昂的计算成本。此外,传统的参数化语言模型本质上难以适应未知领域、编辑已学知识、保留长尾知识,并且容易泄露训练语料中的隐私数据。本论文旨在探索在解决上述问题的同时扩展语言模型的新路径。

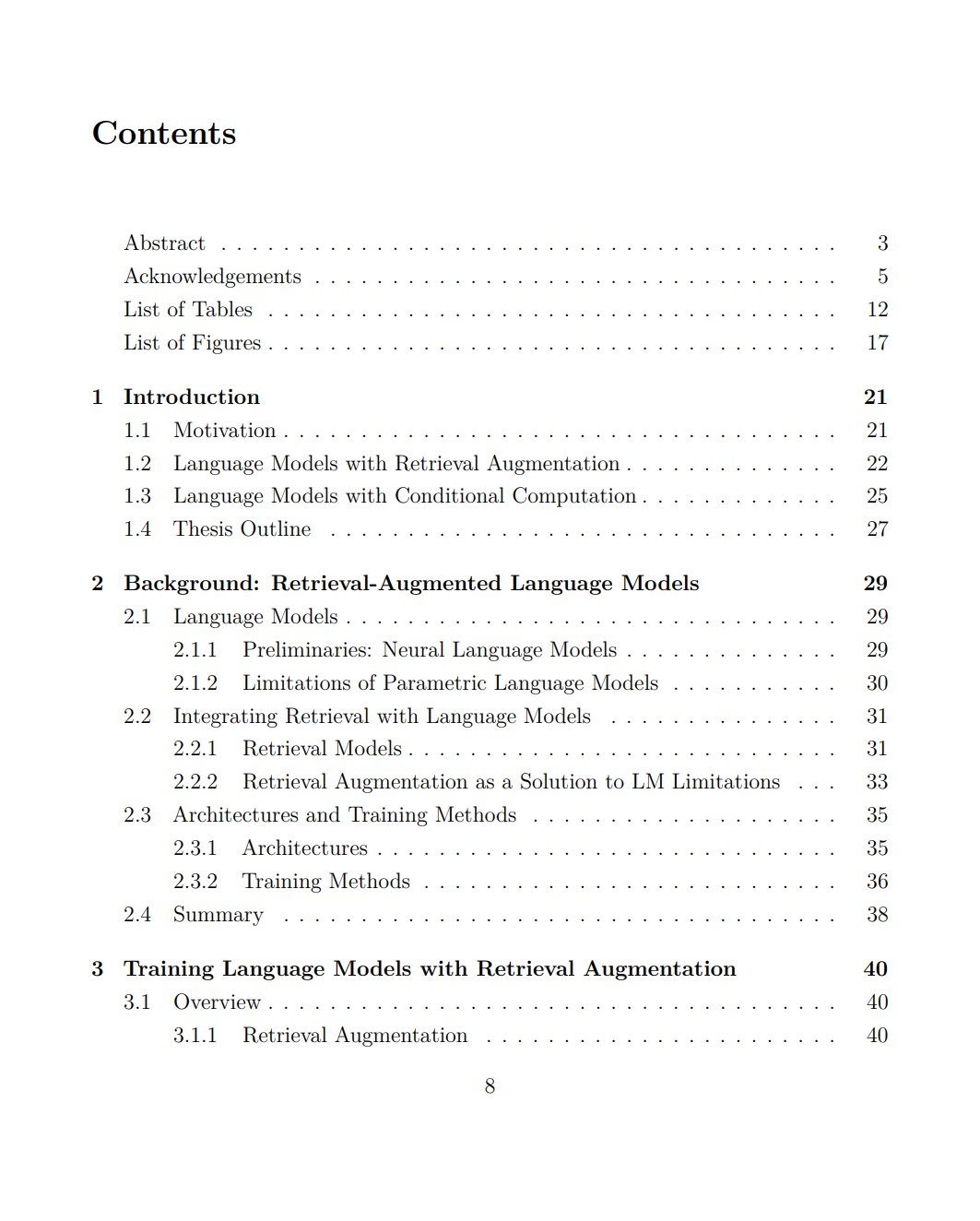

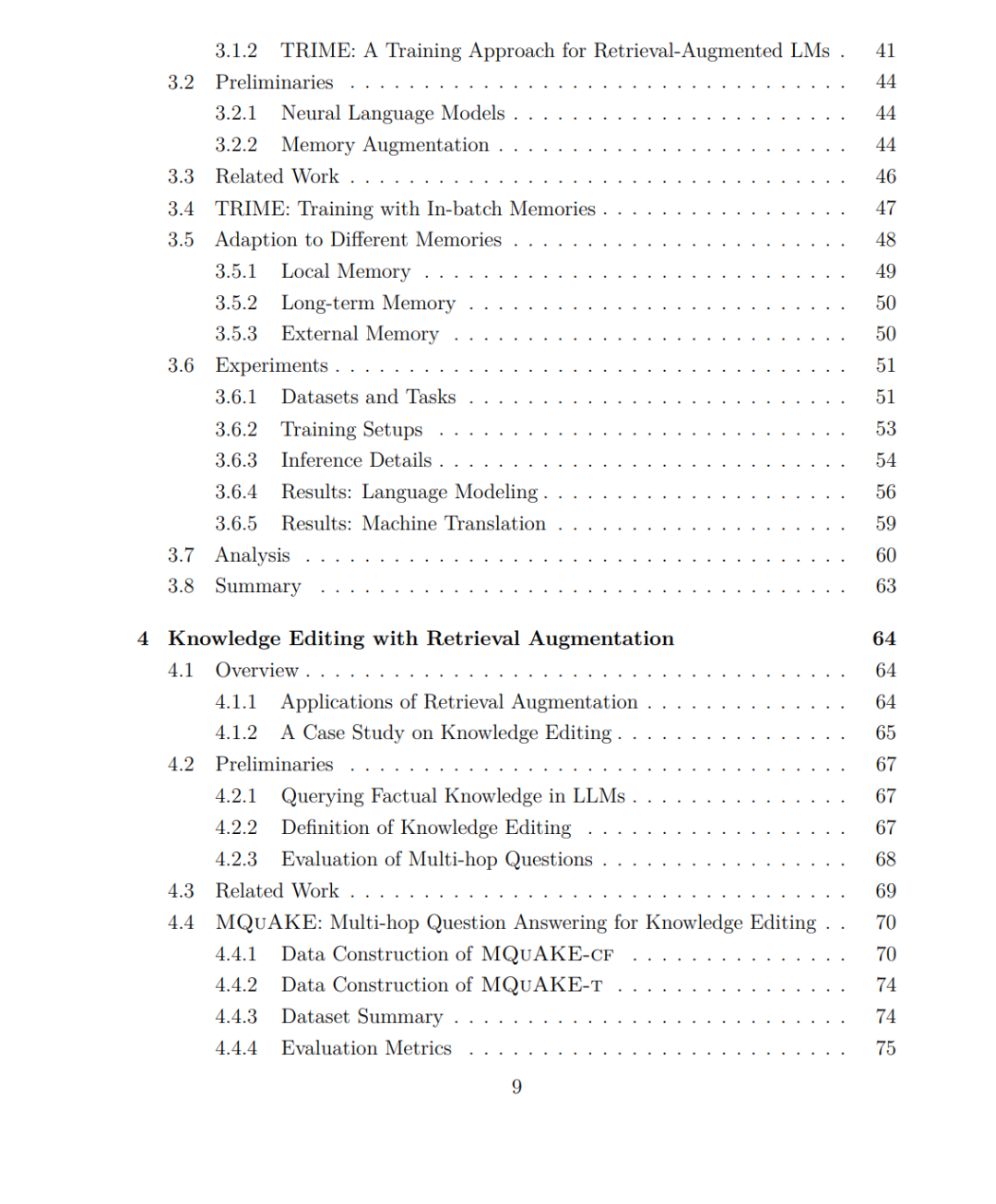

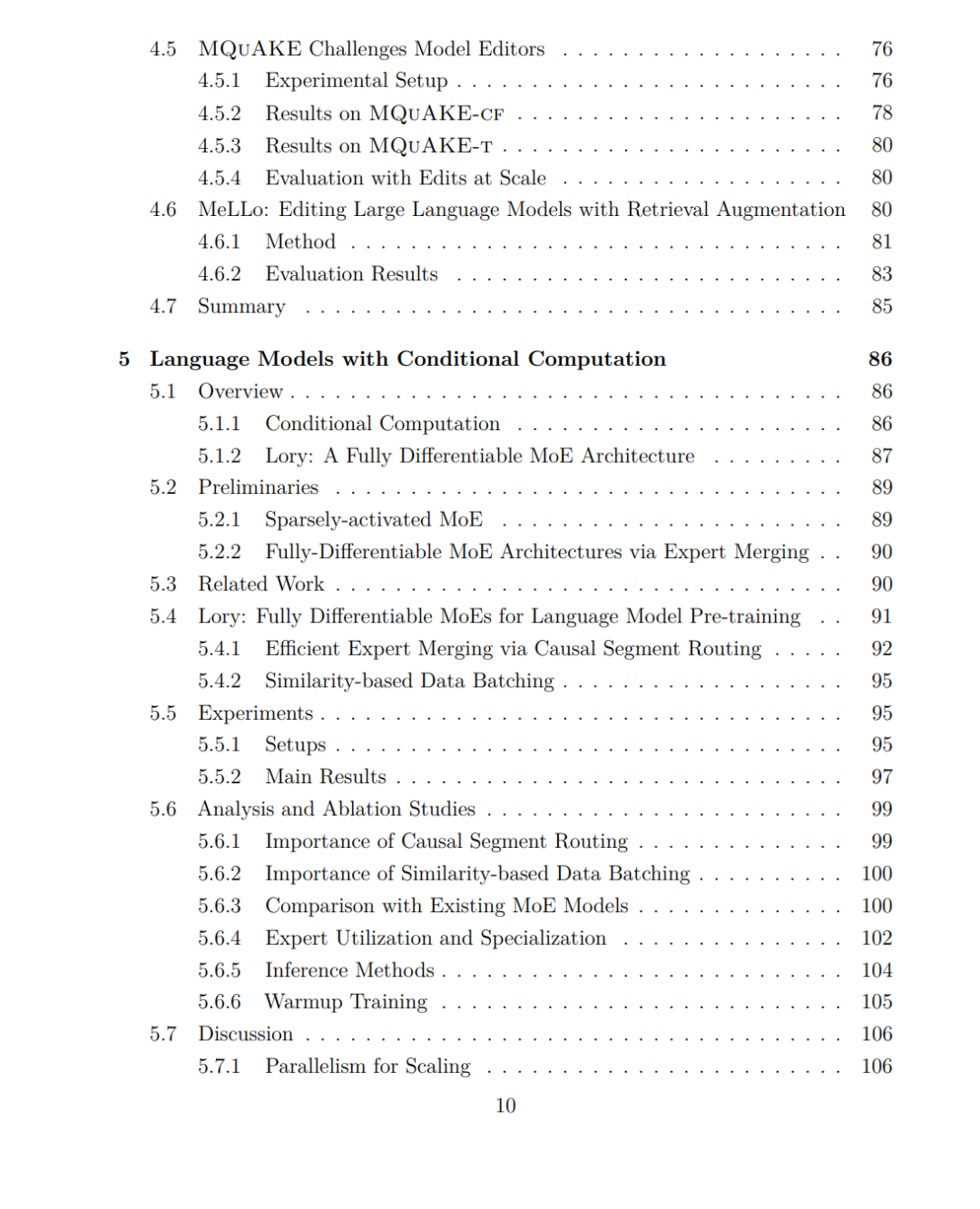

首先,我们研究了具备检索增强能力的语言模型,即语言模型通过外部数据存储进行预测。我们提出了一种新颖的端到端训练方法 Trime,该方法能够联合优化语言模型与检索模型。实验结果表明,Trime 能在不增加模型规模或计算预算的前提下,显著提升语言模型的性能。此外,使用 Trime 训练的检索增强语言模型能有效适应此前未见的领域。

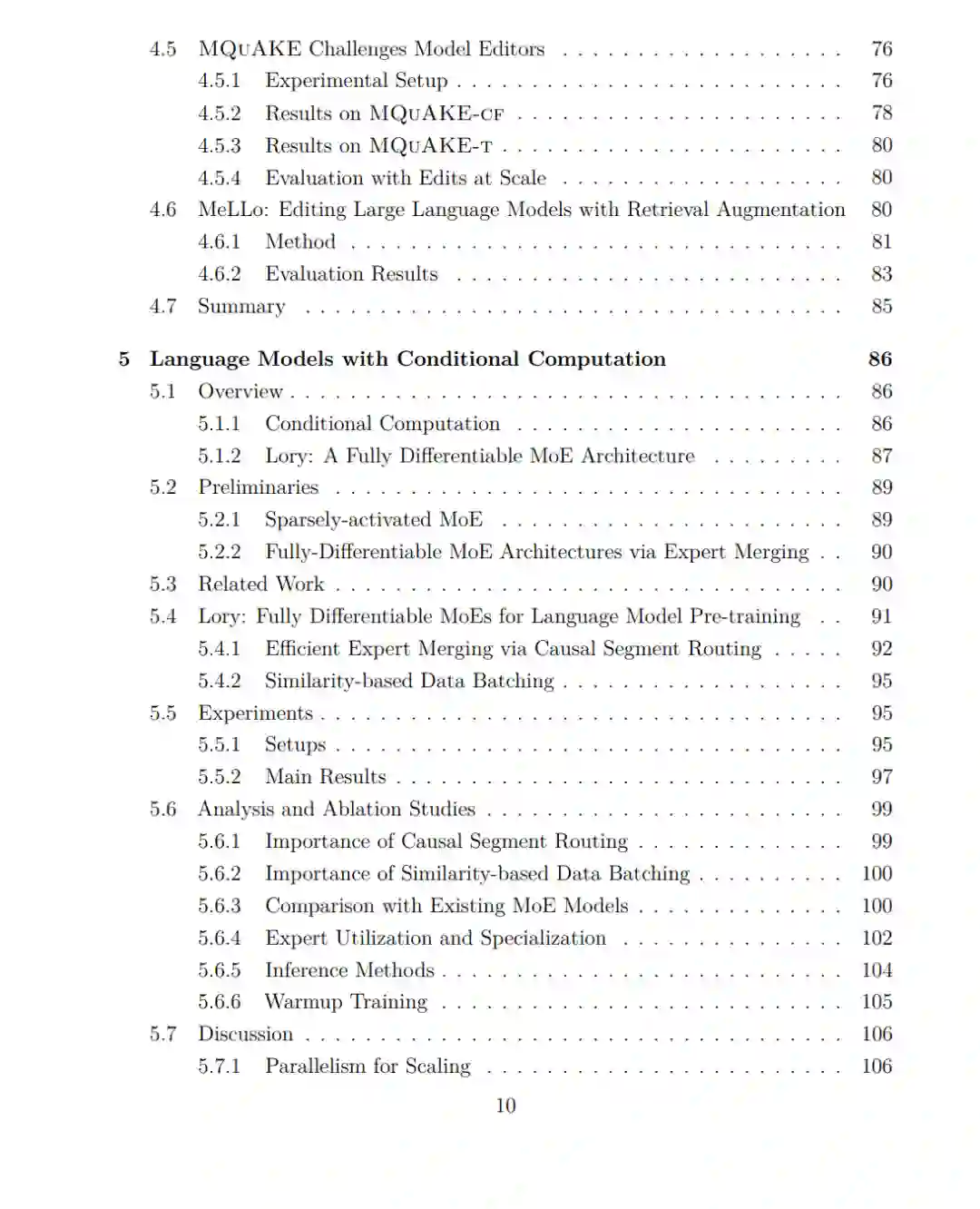

其次,我们聚焦于语言模型中的一个核心挑战:编辑模型参数中存储的知识。这是一个至关重要但尚未充分解决的问题,因为现实世界的信息是不断变化的。我们调研了当前最先进的知识编辑方法,并发现现有的评估范式非常有限。为此,我们提出了一个新的基准测试集 MQuAKE,其中包含多跳问题,用于评估模型在知识更新后是否能正确推理出由新事实所引出的变化。实验显示,现有的知识编辑方法在这些多跳问题上表现不佳。我们进一步提出了一种简单的检索增强方案,将所有编辑后的事实外部存储,性能远超现有方法。

第三,我们探索了通过条件计算机制扩展语言模型以降低计算成本。我们重点研究了“专家混合”(Mixture-of-Experts, MoE)机制,这是一种广泛应用的条件计算方法,适用于高效扩展语言模型。然而,训练 MoE 的路由网络面临非可微、离散目标优化的难题。为此,我们提出了一种全可微的 MoE 架构 —— Lory,用于自回归语言模型的预训练。该架构基于两个关键技术:(1)因果段路由策略,用于高效整合专家计算结果;(2)基于相似度的数据批处理方法,以提升专家的专精化能力。尽管采用了基于段的路由方式,Lory 模型在性能上仍能与采用基于 token 路由的最先进 MoE 模型竞争,同时还能体现出领域级的专精能力。

总体而言,我们的研究揭示了一种新的语言模型扩展范式,在根本上解决了现有模型的关键限制,并推动了更高效、更强大、更具适应性与可更新性的语言模型的发展。